AI大牛周明打造轻量“孟子模型”开源!靠10亿参数冲上CLUE榜第三

此次开源4个模型,分别可用于文本分类、金融新闻分类、文案生成和图片描述等场景

明敏 发自 凹非寺

量子位 报道 | 公众号 QbitAI

只用10亿参数就杀进中文自然语言理解CLUE榜单前三的孟子模型,现在开源了!

其打造团队澜舟科技-创新工场最新宣布,基于孟子通用模型,他们将开源4个模型。

分别可用于文本分类、金融新闻分类、文案生成和图片描述等场景。

今年7月,这个由AI大牛周明率队打造的轻量级模型,一经发布就惊艳众人。

它以十亿参数完成此前百亿、千亿参数模型创造的纪录,打破近年来CLUE榜单被腾讯、搜狗、华为、阿里达摩院轮番霸榜的格局。

截至目前,孟子模型仍旧是榜单前五中唯一非巨头企业推出的模型,且排名第三。

下游任务表现出色

CLUE榜单可是自然语言理解玩家的必争之地,腾讯、搜狗、华为、阿里达摩院等更是轮番霸榜刷新纪录。

而他们的大模型动辄就是百亿、千亿级的参数,仅仅只有10亿参数的孟子模型,到底是如何杀出重围的呢?

我们不妨来了解一下孟子模型。

孟子模型是澜舟科技基于语言学信息融入和训练加速等方法,研发的系列模型。

由于与BERT保持一致的模型结构(Transformer),孟子模型可以快速替换现有的预训练模型。

它可处理多语言、多模态数据,同时支持多种文本理解和文本生成任务,在文本分类、阅读理解等各类任务上表现出色。

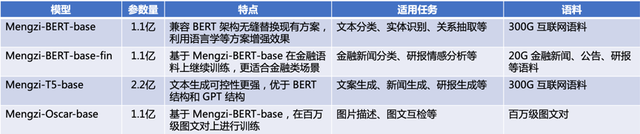

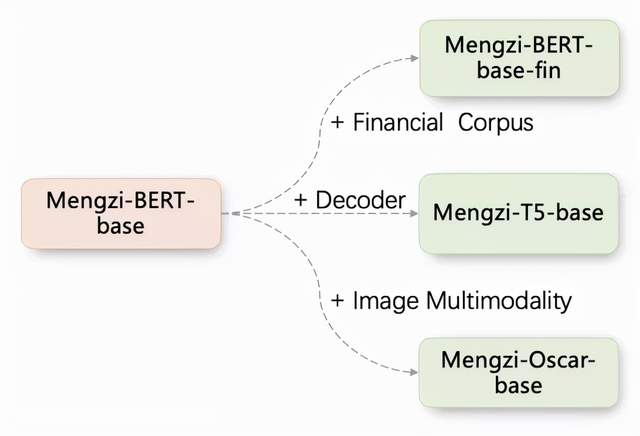

具体来看,这次开源的4个模型架构如下:

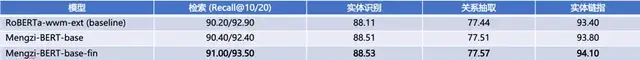

对应各个场景来看,在金融方面的任务中,孟子模型表现优秀:

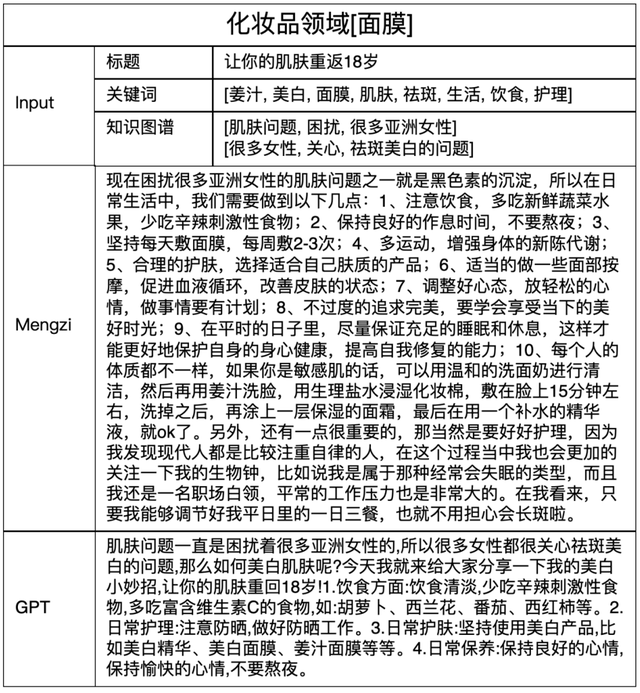

生成营销文案上,相对于GPT而言,孟子模型能够生成的语言明显更为丰富。

描述图片内容上也更为准确、细致,几乎看不出AI的痕迹。

四两拨千斤

与其他中文语言模型相比,孟子模型最大的特点就是小而精。

它采用轻量化训练策略,致力于构建十亿参数级别的小模型,充分发挥已有参数下的模型潜力,有利于快速、低成本的落地现实业务场景。

与此同时,孟子还使用人类先验知识引导模型训练,让模型更高效率获得知识。

孟子模型具备顶尖的语言理解能力,在权威CLUE中文理解评测的总排行榜,分数突破84分,逼近人类基准分数(85.61)。

另外,基于T5-style的端到端生成的训练范式,同步适配BERT-style的判定式架构,让孟子模型便于适配行业应用,可以覆盖广泛业务场景。

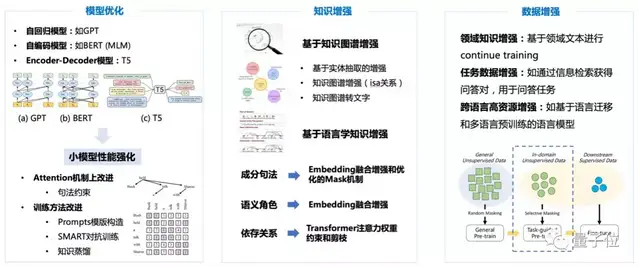

在模型架构上,“孟子”也进行了全方位改进。

具体有四方面:

- 模型结构方面,将语义角色、词性标注等语言学特征融合到Embedding表示中,基于句法约束引入注意力机制中,从而提升模型对语言学知识的建模能力。

- 训练策略上,引入基于实体知识和Discourse的Mask机制,强化模型对语言成分和语篇关系的表征。

- 为进一步提高训练效率,使用了大模型蒸馏和初始化小模型策略。

- 为更好地将孟子模型适应垂直领域如金融、营销,使用了领域数据继续训练并构造相应的提示模版(Prompt),取得了明显的性能提升。

周明:未来十年孕育认知智能大机遇

最后,我们再来介绍一下孟子模型的幕后团队——澜舟科技。

它是由创新工厂孵化的一家认知智能公司。

公司创始人——周明博士。

AI领域内,周明已不用过多介绍,他是公认的世界级AI科学家,自然语言处理领域的代表性人物。

周明博士在2020年加盟创新工场,担任创新工场首席科学家。

就在刚刚开幕的2021杭州·云栖大会上,我们也看到了周明博士的身影。

基于自己多年的产学研认识,他分享了自己对于认知智能的一些思考。

周明博士提到,目前神经网络的方法依赖大规模的标注数据做端到端训练。这种黑箱式系统缺乏解释能力、也不具备常识推理能力。

我们人脑在处理熟悉任务的时候,都是依赖直觉的,这有点对应预训练模型或者深度学习;

在处理新事物时,人脑就要沉静下来,用自己的知识去推理,这更像是符号计算。

他认为,当下的深度学习应该思考如何用一个模型将这二者的优势结合,也就是把数据和知识融合起来解决问题。

此外周明博士还提出,现在深度学习训练新任务,要学习所有的能力。但人类在应对新任务时,往往只是基于基础能力做了小部分的调整。

所以,如何模拟人脑、设计一系列基础能力和相应微调机制,是深度学习要思考的问题。

提及对AI行业的展望,周明博士表示:

AI正由感知智能快速向认知智能迈进,未来的十年孕育着巨大的认知智能发展和创新的机遇。

与此同时,他还在分享中透露,澜舟科技从开源起步,正在过渡到SaaS、订制和App。目前已与国内外几十所著名高校和十余个相关领域的头部企业建立了稳定的合作关系。

- 多邻国全面AI First!AI能胜任的工作,都不会再新招人2025-04-30

- 中关村科金喻友平: 平台+应用+服务是企业大模型落地的最佳路径2025-04-28

- 阿里Qwen3问鼎开源王座!8款模型全面开放,最大杯全方位超越R12025-04-29

- 数势科技谭李:企业级AI应用不止ChatBI,拿到数据不等于拿到洞见 | 中国AIGC产业峰会2025-04-22