大规模多构型具身智能新数据集和基准:5.5万条机器人轨迹数据,279项不同任务

国家地方共建具身智能机器人创新中心与北京大学计算机学院联合创建

伴随着全球人工智能技术飞速进步,具身智能产业迅猛发展,赋予机器人类人化的泛化能力是具身智能机器人技术的核心目标之一,实现这一目标的关键在于如何使各类机器人本体在面对多样化的环境和任务时,能够展现出卓越的性能。

正如ChatGPT需要海量文本数据来训练一样,想要培养出一个能力全面的机器人,也需要大量优质的训练数据,数据集是具身智能技术发展的重要基石。

与视觉或语言数据的获取相比,收集机器人训练数据远比收集文本或图像数据困难得多,需要在专门的环境中记录机器人的每个关节动作和末端执行器的信息,这个过程不仅需要昂贵的硬件设备,还需投入大量人力来确保数据质量,因而业内目前最具通用性的机器人操作策略主要依赖于在有限多样性条件下收集的数据,大规模多构型具身智能数据集和Benchmark是极为稀缺的资源。

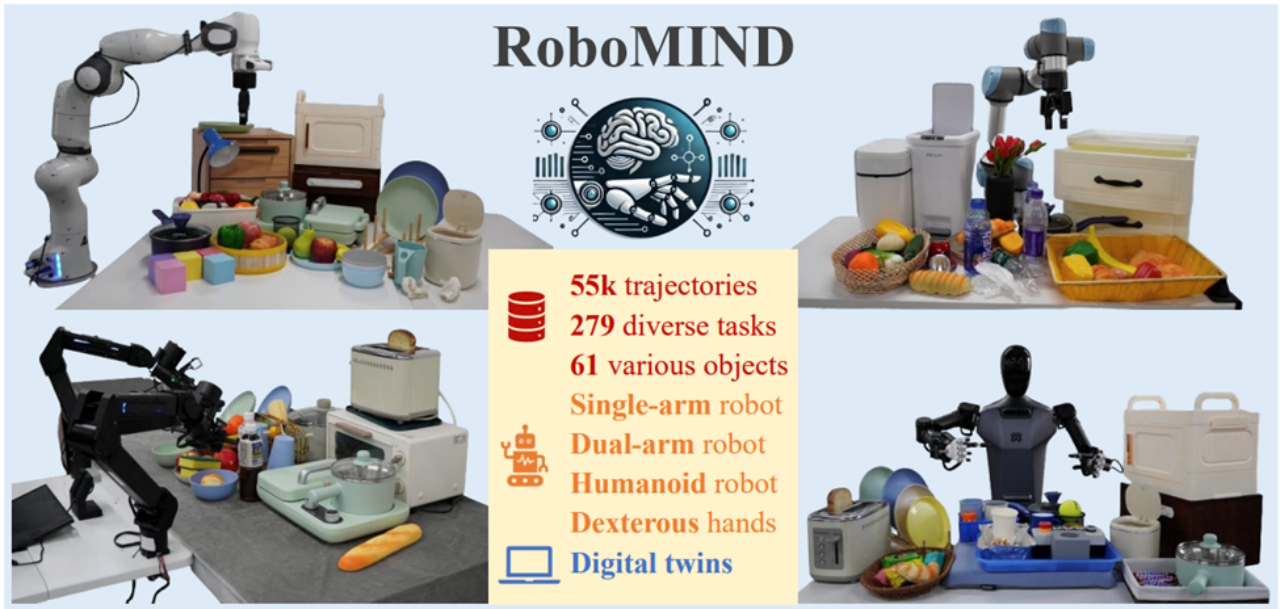

为了解决这个难题,国家地方共建具身智能机器人创新中心与北京大学计算机学院联合推出了一个大规模多构型智能机器人数据集和Benchmark——RoboMIND。

RoboMIND捕捉机器人面对复杂环境、长程任务时的各种交互和经验,从而促进能够掌握不同操作策略的通用模型的训练。

RoboMIND包含5万5千条机器人轨迹数据,涉及279项不同的任务,涵盖了高达61种不同的物体,覆盖了家居、厨房、工厂、办公、零售等大部分生活服务场景。

此外,该数据集包含根据真实场景搭建的数字孪生场景,进一步丰富和扩充了此数据集的多样性,同时提升数据采集效率。机器人构型包含单臂机器人、双臂机器人、人形机器人,手臂末端使用夹爪或者灵巧手。

为了评估RoboMind数据集的质量,研究团队在主流单任务模仿学习模型上(如ACT)和具身多模态大模型上(如OpenVLA、RDT-1B)进行了广泛的评测,发现RoboMIND数据集可以有效提升模仿学习模型在现实场景下任务的成功率。该评测得到了北京智源人工智能研究院的大力支持。

RoboMIND数据集特征分析

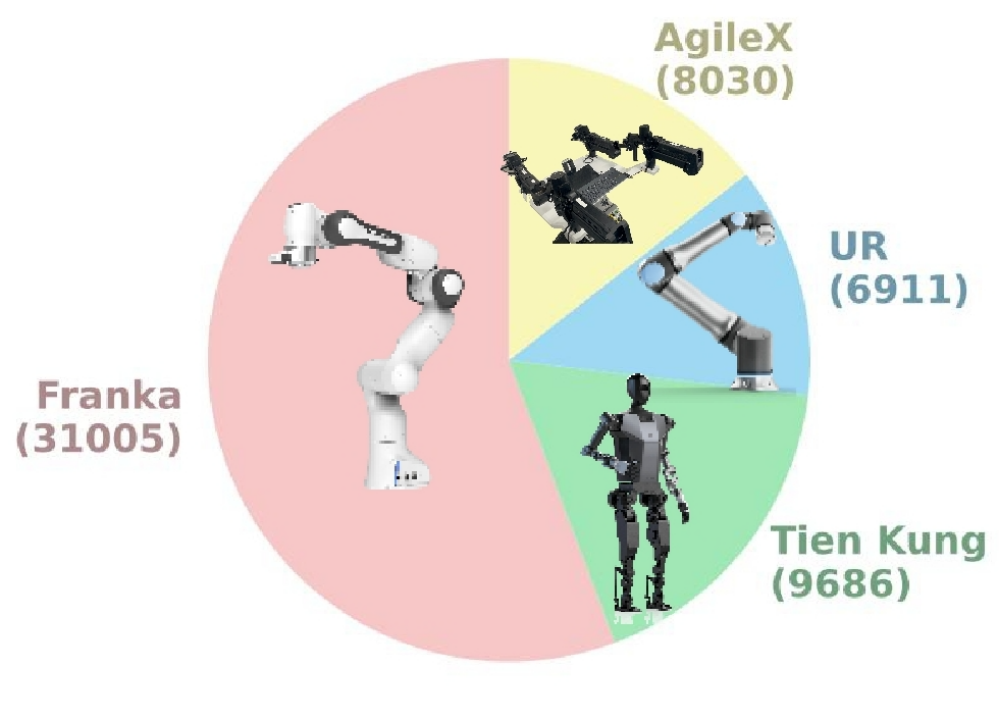

多样化构型:

RoboMIND的数据来源包括31,005条Franka Emika Panda单臂机器人轨迹、9,686条“天工”人形机器人轨迹、8,030条AgileX Cobot Magic V2.0双臂机器人轨迹以及6,911条UR-5e单臂机器人轨迹。

研究团队使用自研的“天工”人形机器人,收集了17.4%的数据,其中包含了大量的双臂操作任务,需要较高的双臂协调能力。

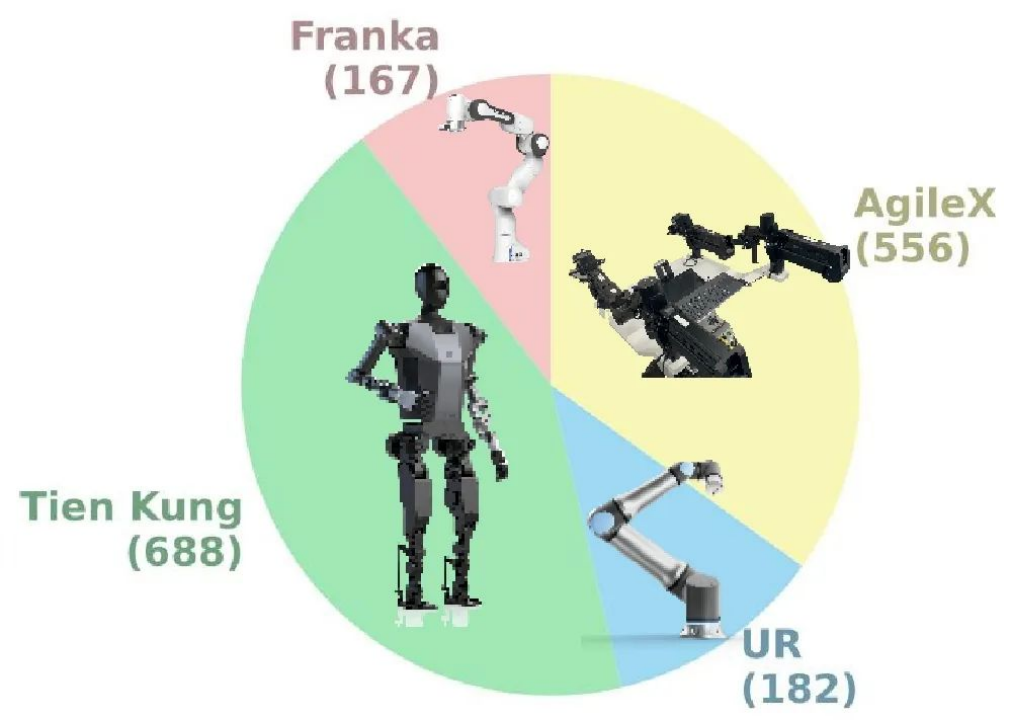

多样化轨迹长度:

研究团队计算了每种机器人模型在任务执行过程中的平均任务时长(即每条轨迹中的时间步数)。如图所示,Franka和UR的任务通常具有较短的轨迹(少于200个时间步),适合用于训练基础技能。相比之下,“天工”和AgileX的任务轨迹较长(超过500个时间步),更适合用于长时间跨度的任务训练以及技能组合。

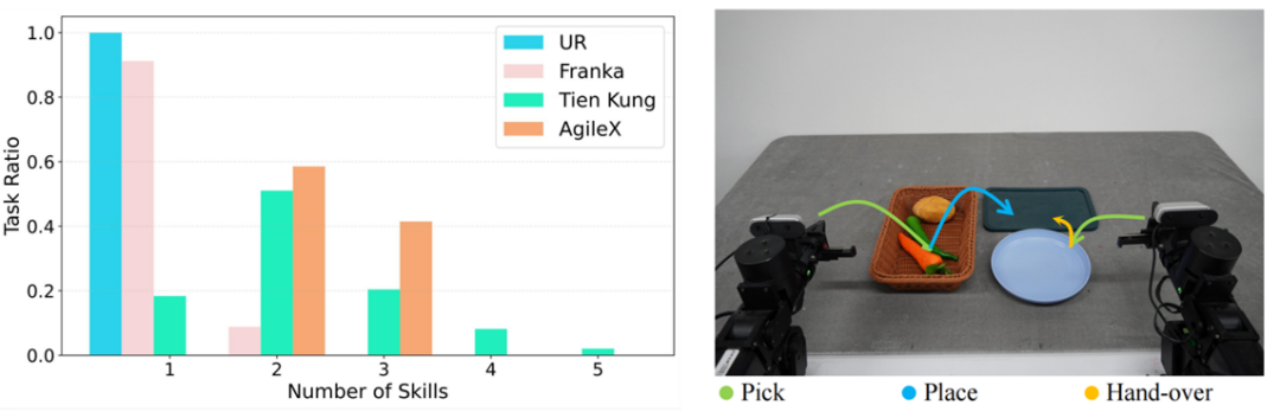

下图展示了四种机器人平台在任务中所涉及的技能数量分布的直方图。

从图中可以看出,AgileX的任务通常涉及两到三种组合技能,这使得任务的时长较长。而“天工”的任务则长度不一,其中一些任务涉及多达五种技能。

为了进一步说明这一点,研究团队选取了一项包含三种技能的AgileX任务,并在图中展示了其双臂操作的轨迹:首先,两只手臂依次执行抓取技能,随后左臂将胡萝卜放置,右臂将其移交给黑色盘子,整个过程需要高水平的协调操作能力。

任务多样性强:

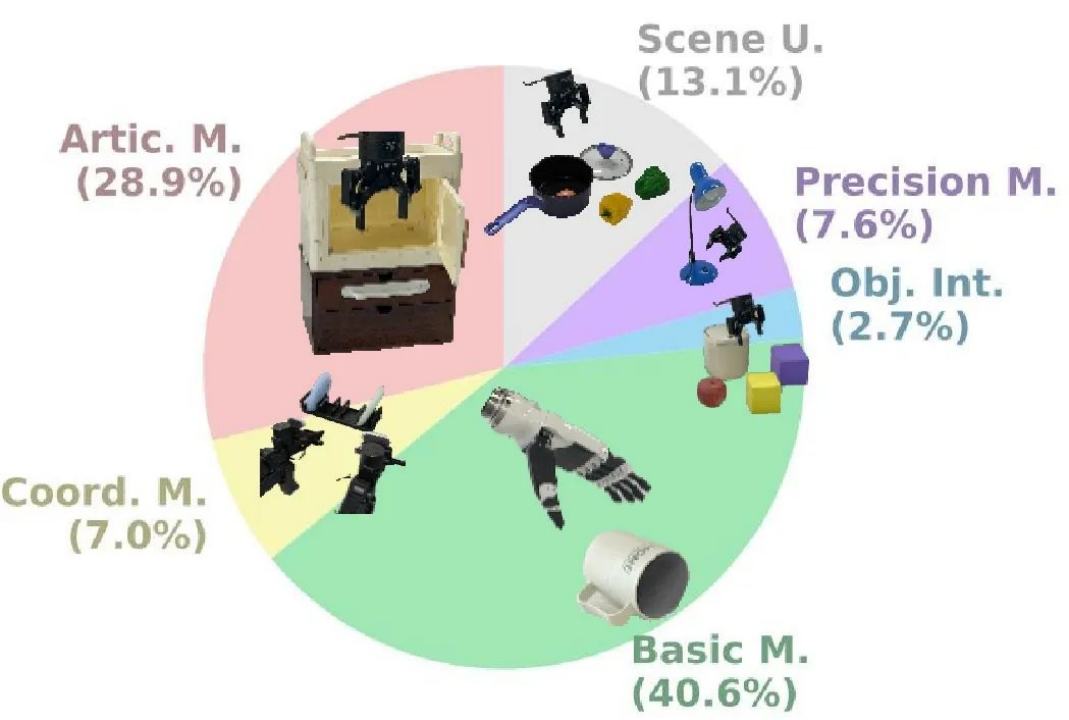

研究团队根据自然语言描述,根据物品大小、使用场景、操作技能等因素,将整个数据集中的任务分为了五大类,分别是:基础技能、精准操作、场景理解、柜体操作、协作任务。任务的具体分布如下所示:

可以看出,除了基础的操作任务,RoboMIND数据集还包含了大量的复杂任务,为通用机器人策略的训练提供了丰富的数据保障。

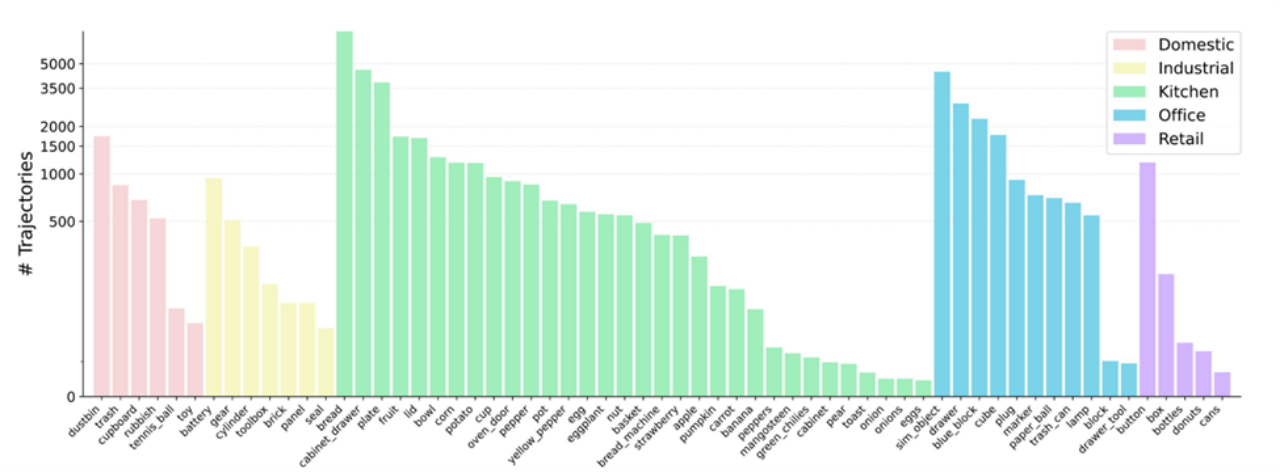

物品类别丰富:

RoboMIND数据集包含了61种不同的物品类别,具体如下所示。

可以看出,在厨房场景中,数据集不仅包含了常见的食物,如草莓、鸡蛋、香蕉和梨子等,也包括了复杂的可调节物体,如烤箱和面包机。在家庭场景中,数据集既包括了刚性物体,如网球,也包括了可变形物体,如玩具。办公和工业场景则包含了需要精确控制的小物体,如电池和齿轮。

多样化的物体种类不仅增加了数据集的复杂性,也有助于训练能够在各种环境下执行操作的通用操控策略。

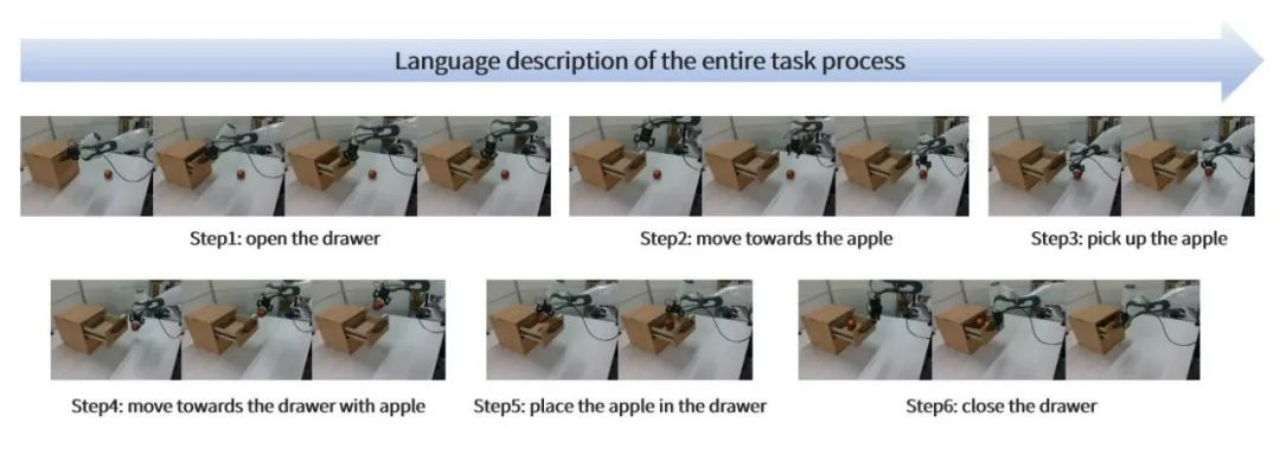

语言描述精确:

以AI(Gemini)和人工审核相结合的方式,研究团队为10000条成功轨迹提供详细的语言注释,包括关键物体、重要操作和操作细节等。

RoboMIND数据收集策略

遥操作真机数据采集

与通常通过脚本化收集、或者依靠VR设备的机械运动数据不同,RoboMIND的数据通过自研的遥操作系统进行收集,更自然、连贯和平滑,能够更好地模拟人类的行为和认知过程。

对于Franka、UR-5e机器人和模拟机器人,研究团队按照Gello方法的设置,创建了相应的同类遥操作设备和控制系统。对于AgileX机器人,研究团队采用了内建的双臂遥操作系统。而对于人形机器人“天工”,研究团队结合使用了Xsens动作捕捉服和Gello风格的遥操作设备。

所有数据收集工作都在指定的内部区域进行,且操作人员的轮换最小化,保持统一的收集节奏,遵循内部标准,从而提高数据集的质量。

智能数据平台管理

随着收集数据量的增长,数据的高效记录、传输、管理和分析成为了一个重大挑战。为了支持具身智能系统的设计和开发,研究团队开发了一个智能数据平台,该平台采用云原生架构和分布式计算,可进行大规模数据处理,提供以下四大功能模块:

- 数据收集:包括实时数据传输、收集设备管理等功能

- 数据存储:支持PB级存储,能处理结构化和非结构化数据

- 数据管理:包括数据清洗、质量评估和版本控制

- 数据处理与分析:对收集的数据进行分析与处理

数据质检

由于所有数据都来源于操作员实时控制系统,可能会因为操作员的身体限制(如疲劳、习惯、注意力分散或外部干扰)而导致错误。为了减轻这些问题,研究团队通过轮换系统和提供舒适环境的方式,帮助操作员保持专注。此外,研究团队还对收集到的所有数据进行质量检查,以确保其可靠性。研究团队还定义了质量保证标准,避免不必要的接触和重复抓取等问题。质量保证过程分为以下三个步骤:

- 初步检查:快速浏览视频,确保没有明显的技术问题,例如丢帧或冻结现象;

- 详细检查:逐帧或慢动作分析,确保符合质量标准;

- 数据过滤和问题记录:记录不符合标准的数据的具体时间戳和描述,并分类处理,便于进一步改进或处理。

这一系列严格的数据收集和质量管理流程,确保了数据的高质量和可靠性,有助于为训练更加精准和可靠的机器人模型奠定坚实的基础。

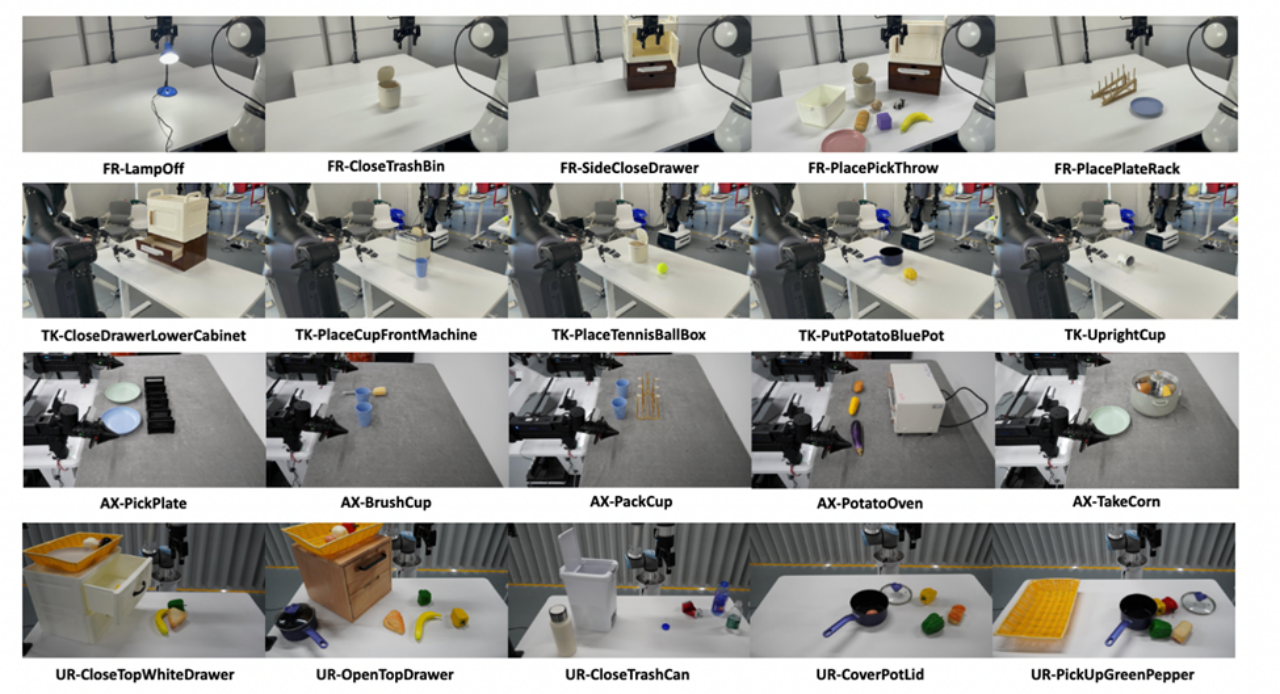

RoboMIND数据集实验验证

研究团队使用RoboMIND数据集,测试了4种目前主流的机器人学习模型,分别为ACT、BAKU、RDT-1B和OpenVLA。以下是RoboMIND数据集包含的部分任务样例:

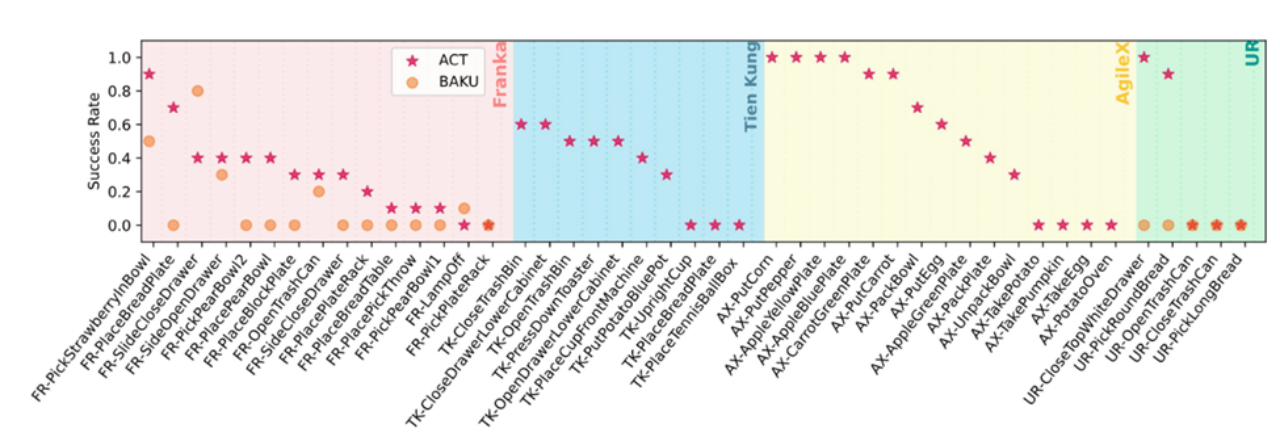

在单任务实验中,研究团队根据任务类型、物品类型等,均匀选取了45个代表性任务进行训练和测试,实验结果如下:

如上图所示,研究团队发现ACT算法在AgileX机器人上对15个任务的平均成功率为55.3%,其他构型上Franka30.7%、UR-5e38.0%和“天工”34.0%。

实验结果表明,ACT算法在大多数任务中至少能够完成一次成功的任务,这不仅证明了该方法的有效性,还验证了RoboMIND提供的视觉感知和机器人关节信息的准确性。

此外,ACT算法在一些更为复杂的“天工”任务上也取得了不错的结果,例如在TK-CloseDrawerLowerCabinet任务上取得了60%的成功率。

这些结果表明ACT在复杂的灵巧手操作任务中表现稳健,突显了RoboMIND数据的高质量。因此,研究团队认为,RoboMIND中包含的单臂、双臂和灵巧手的数据集,能够作为高质量的训练集,提升单任务模仿学习的表现,从而推动整个视觉-语言-动作(VLA)模仿学习领域的发展。

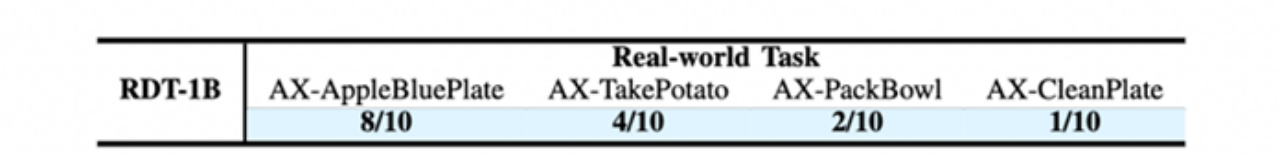

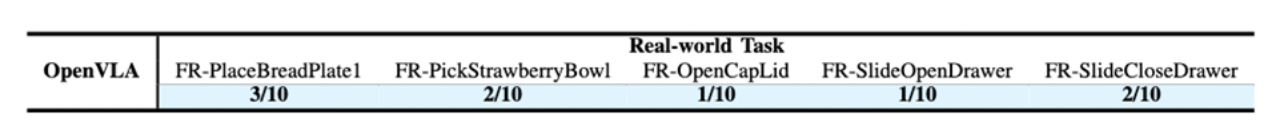

在多任务实验中,研究团队使用多类不同任务和技能组合成的多任务数据集,分别测试了RDT-1B和OpenVLA的效果,结果如下:

RDT-1B模型,在多项任务中表现优异,例如在将苹果放入蓝色盘子中高达80%成功率。

OpenVLA模型,展示了良好的任务适应能力,经过数据集微调后平均成功率提升10%~30%。

可以看出,RDT-1B和OpenVLA均展现出了一定的多任务操作能力,经过在多种模仿学习模型上的测试验证,通过RoboMIND数据集进行模型训练,可有效改进机器人的操作策略,实现更高的操作成功率,且展现出强大的泛化能力。

总之,RoboMIND为机器人操作模型的训练提供了一个高质量、广泛多样的数据基础,旨在提升机器人在复杂环境中的操作能力和适应性。通过大规模、多样化的数据集,机器人模型能够更好地适应各种任务和环境变化,从而推动通用机器人技术的发展。

论文链接 :https://arxiv.org/abs/2412.13877

官方网站 :https://x-humanoid-robomind.github.io/

- 一次示范就能终身掌握!让手机AI轻松搞定复杂操作丨浙大&vivo出品2025-05-01

- 又一开源AI神器!将机器学习论文自动转为可运行代码库2025-05-01

- AI卧底美国贴吧4个月“洗脑”100+用户无人察觉,苏黎世大学秘密实验引争议,马斯克惊呼2025-04-30

- 全网首测!Qwen3 vs Deepseek-R1数据分析哪家强?2025-04-30