53页PDF爆料OpenAI“AGI时间表”,爆料者:马斯克诉讼搅了局

“2027年发布AGI完全体”

克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

OpenAI神秘的Q*计划,又有新鲜爆料。

今天凌晨,一篇53页google文档开始在网络上热传,透露OpenAI“计划在2027年前实现完全AGI”。

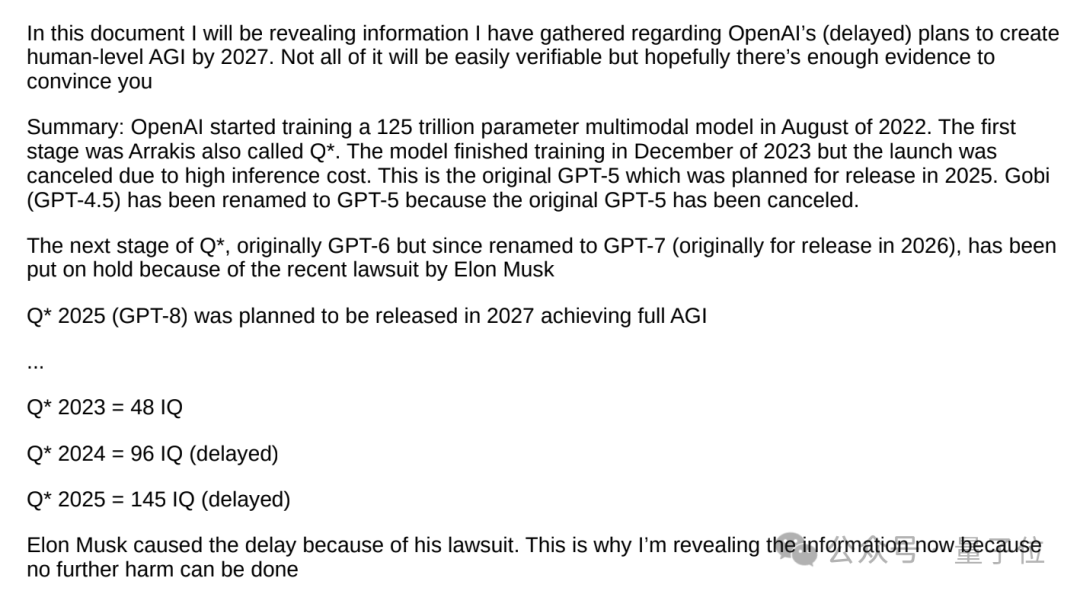

爆料者称,自己选择发布这篇文档是不想让马斯克继续“造成伤害”,他认为后者发起的诉讼造成了AGI的推迟。

△文档封面由爆料者制作,并非来自OpenAI官方

消息一经发布,就在网络上引起了轩然大波,甚至有人认为实现AGI可能不需要等那么久……

当然也有人对其真实性表示质疑,认为文档来源不明且无法证实真伪。

那么,这份被热议的爆料文档,都说了些什么呢?

系列发布计划重新调整

文档显示,OpenAI训练了一个125T(万亿)参数的多模态大模型,而Q*就是该模型的第一个阶段。

据称,该模型就是原计划在2025年发布的GPT-5,训练于2023年12月完成,智商达到了48。

而之后的Q* 2024和Q* 2025(计划发布时间分别为2026和2027年),智商被认为将达到96和145。

96分的IQ已经是普通的人类的水准,而145分则是达到了天才水平。

但坏消息是,由于推理成本过高,加上马斯克诉讼的影响,这一系列计划被推迟,相应模型的名字也换了一圈。

而按照爆料者的说法,AGI在GPT-4完成训练时,也就是2022年8月就已初现端倪。

GPT4时已有AGI?

爆料者说,神经网络的参数就如同生物体的突触,参数量越大(突触数量越多),表现也会更智能。

GPT-2有15亿个连接,这比老鼠的大脑(大约100亿个突触)还要少;而GPT-3有1750亿个连接,已经与猫接近。

2020年,GPT-3发布后,许多人开始推测一个大约大600倍、拥有百万亿参数的模型可能会有怎样性能,因为这个参数量接近了人类大脑的突触数量。

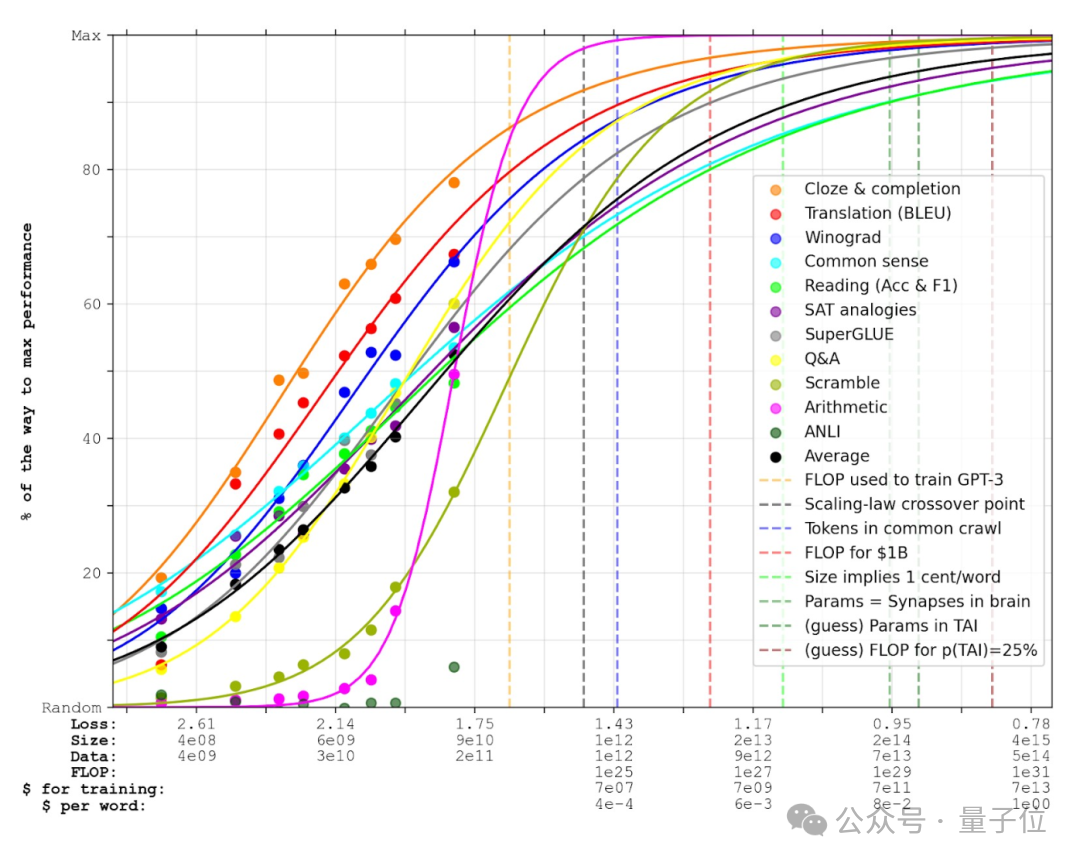

文档作者引用了英国Open Philanthropy学者Lukas Finnveden(Lanrain)的观点,表示根据模型的参数量,人们将能够预测AI的性能。

人类大脑大约有2×10^14(200万亿)个突触,大致相当于神经网络中的参数数量(绿线)。

而Lanrian展示的外推预测显示,AI性能似乎随着参数量一同达到了人类水平。

在假定AI性能确实可以根据参数量来预测,而且大约100万亿参数就足以与人类相当的前提下,何时出现AGI的问题就变成了什么时候会出现百万亿参数的AI模型。

而OpenAI开发百万亿参数模型的传闻,最早出现在在2021年夏天,这是奥特曼参投的Cerebras公司CEO Andrew Feldman在Wired杂志的一次访谈中透露的。

同年9月,奥特曼在AC10在线聚会和问答环节中,承认了该计划的存在。

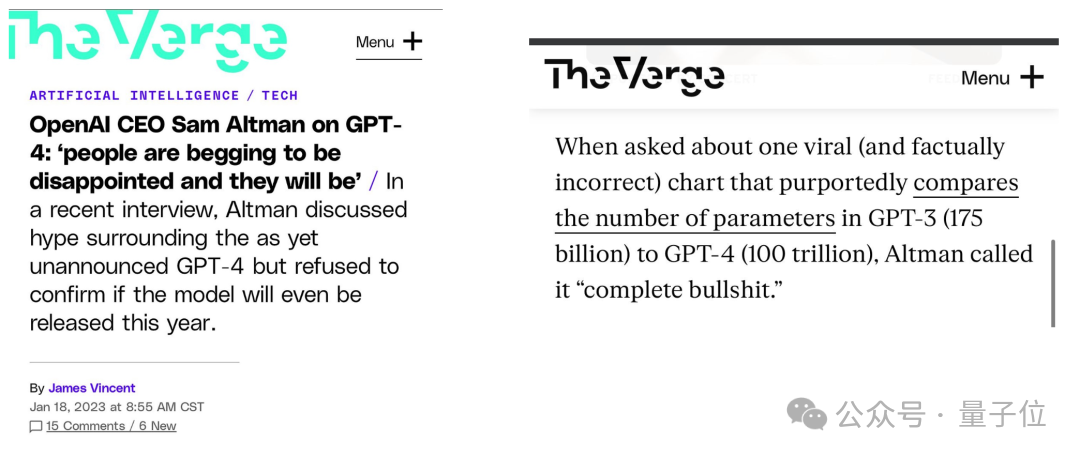

不久之后,网络上又产生了GPT-4即是该模型的传闻,导致包括奥特曼在内的OpenAI员工不得不紧急辟谣。

OpenAI的官方立场,是认为GPT-4具有百万亿参数的说法纯属无稽之谈,但文档作者认为其说法亦非完全属实——在他看来,GPT-4是这个百万亿参数模型的一个子集。

爆料者还称,OpenAI声称GPT-4在2022年8月份“完成了训练”,但有一个“庞大”的多模态模型据信在8-10月正在接受训练。

他推测,要么是OpenAI撒了谎,要么是GPT-4完成第一轮训练后在8月至10月之间进行了额外训练,关键是这段时间与训练百万亿模型所需要的时间十分接近。

但是,2022年DeepMind发布的Chinchilla,用相对较小的参数量击败了较大参数量的模型,说明单靠参数量预测模型表现的方式不够准确。

对此,OpenAI总裁Greg Brockman表示已经意识到此前认为的Scaling Law存在缺陷,并已采取措施进行适应。

进一步地,爆料者认为,有了新的补充,这个百万亿模型将能够达到与人类同等的水平……

而至于这份爆料的真实度,一方面看,其中引用的一些人,的确曾对OpenAI的行动做出过准确预测。

但另一方面,爆料这个消息的推特博主,总共就只有两条推文,而且还是在同一天发出的。

所以,这份文档中的内容可信度究竟有几分,读者朋友们还是理性吃瓜为好。

文档地址:

https://drive.google.com/file/d/1xlRDbMUDE41XPzwStAGyAVEP8qA9Tna7

- 宇树机器人强化学习代码全面开源,训练到仿真和实操手把手教学2024-12-17

- OpenAI员工意外泄露下一代ChatGPT!网友:故意的还是不小心的?2024-12-11

- AI营销的风,还是吹到了A股2024-12-05

- 通信巨头入局视频生成,直接霸榜权威评测:人物跨越多场景依然一致2024-12-05