游戏bug帮大模型学物理!准确率超GPT4o近4个百分点

开源模型

PhysVLM团队 投稿

量子位 | 公众号 QbitAI

融合物理知识的大型视频语言模型PhysVLM,开源了!

它不仅在 PhysGame 基准上展现出最先进的性能,还在通用视频理解基准上(Video-MME, VCG)表现出领先的性能。

在这项研究之前,想让AI像人类儿童一样,通过观察世界理解基本的物理常识,是一个主要挑战。

对于现实世界的视频来说,全面覆盖和解释所有正常的物理现象既困难又不必要。

相比之下,游戏视频(gameplay videos)通常包含违反物理常识的“故障现象”(glitches),这有助于简化物理常识理解的定义和评估,即专注于解释物理常识的违反现象,而不是试图列举所有存在的正常物理现象。

为此,PhysVLM在专门整理的一套数据集上训练,包括用于评估的PhysGame benchmark、用于监督微调的PhysInstruct数据集和用于偏好对齐的PhysDPO数据集。

PhysGame benchmark 设计

如图所示, PhysGame包含880个含有故障现象的游戏视频,每个视频都配有一个高质量的多项选择题,专门针对故障现象的性质进行标注。

△PhysGame类别分布

PhysGame涵盖了四个关键的物理领域(即力学、运动学、光学和材料属性),并细分为12个具体类别(如重力和速度)。

- 力学(Mechanics):该类别涉及力与力矩及其对运动的影响,提供了解释和分析视频中物体运动的基础原理。典型案例包括重力、弹性和摩擦力。

- 运动学(Kinematics):该领域研究不考虑力的情况下的运动,涉及精细分类,如随时间变化的速度和加速度。

- 光学(Optics):该领域关注光的行为与特性及其与物质的相互作用,包括反射、折射以及吸收与透射。

- 材料属性(Material properties):该领域指的是物质固有的特性,包括颜色、刚性、物体形状以及人体姿态。

PhysGame benchmark构建

视频收集和过滤:

PhysGame中的视频主要从Reddit页面抓取,该页面包含带有异常事件和故障现象的游戏视频。为了平衡不同的类别,团队还通过关键词搜索从 YouTube增强视频数据。团队根据以下两项标准进行人工筛查:

- 重复检查:Reddit论坛可能会多次引用同一视频,导致重复下载。团队手动检查,确保PhysGame benchmark中的视频不存在重复;

- 内容检查:下载的视频可能包含非游戏元素,团队对这些内容进行了严格筛选,确保它们不被纳入PhysGame benchmark中。

选项生成:

本文以多项选择题的形式创建问答对。具体来说,正确选项描述了视频中违反物理常识原则的特定故障现象。为了增强干扰选项的可信度,本文要求干扰选项中的故障现象应与视频中观察到的个体或动作高度相关,这使视频LLM理解故障内容,而不仅仅通过识别包含的物体或动作来选择答案。

质量控制:

为了保证数据集的质量,本文进行了一项包括人工检查和自动LLM辅助检查在内的双重质量控制过程:

- 人工检查:所有初步标注的问答对都经过不同人工标注人员的严格交叉检查。对于正确选项,检查人员必须评估它们是否全面准确地描述了所有存在的物理常识违反实例。对于干扰选项,检查人员需评估它们是否足够具有迷惑性;

- LLM 辅助检查: 团队去除那些仅凭问题和选项,不需要查看视频就能由GPT-4o正确回答的问答对。

△PhysGame示例

PhysInstruct&PhysDPO数据集构建

PhysInstruct:

为了提升视频LLM的物理常识理解能力,团队开发了PhysInstruct数据集用于监督微调。视频收集过程与PhysGame中的流程相同。为了防止数据泄漏,团队严格排除任何已包含在PhysGame中的视频。团队遵循Self-instruct范式通过提示GPT-4o来构建PhysInstruct。

PhysDPO:

团队构建了偏好对齐数据集PhysDPO,以提供更可信和可靠的回答。如图3所示,团队将PhysInstruct 数据集中生成的答案视为preferred回答,而dis-preferred回答则通过元信息篡改(meta-information hacking)、时间篡改(temporal hacking)和空间篡改(spatial hacking)生成。团队用误导性的元信息以及减少帧数和降低帧分辨率的视频帧来提示 GPT-4o。

以下是PhysDPO数据集构建流程图:

模型评估与分析

PhysGame benchmark 实验结果:

- 在所有专有模型中,GPT-4o和Gemini-1.5-pro表现最佳,分别达到了56.1%和55.2%的平均准确率。在所有细分领域中,GPT-4o在摩擦和加速度方面表现优越。相比之下,Gemini-1.5-pro在理解与重力、弹性、反射、吸收与透射、颜色和刚性相关的物理常识方面表现更强。

- 现有的开源模型远远落后于专有模型。即便是表现最好的开源模型 LLaVA-OneVision,其平均准确率仅为47.7%。相比之下,本文提出的PhysVLM在所有专有和开源模型中都达到了最先进的性能。与开源方法相比,本文的PhysVLM在12个评估领域中的6个领域达到了最高性能。值得注意的是,PhysVLM-DPO在平均准确率这一指标上比最佳表现的专有模型GPT-4o超出了3.4%。

△PhysGame benchmark实验结果

Video-MME benchmark实验结果:

本文的PhysVLM模型在所有7B模型中表现优越。令人惊讶的是,作为7B模型,PhysVLM-SFT和PhysVLM-DPO在整体表现上分别比 34B 模型 LLaVA-NeXT-Video提高了3.2%和3.8%的绝对值。通过比较PhysVLM-SFT和PhysVLM-DPO,团队发现,使用所提出的PhysDPO数据进行 DPO训练在短视频和长视频上的表现都有所提升,而在中等长度的视频上的表现略有下降。

△Video-MME benchmark实验结果

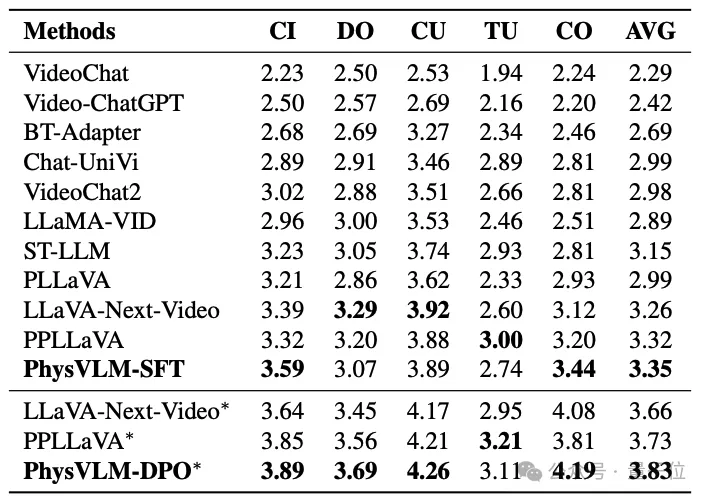

VCG benchmark实验结果:

在仅使用SFT的模型中,本文的PhysVLM-SFT在平均得分方面表现最佳。在四个子类别的评估中,PhysVLM-SFT在信息正确性和一致性类别上表现尤为出色。与使用DPO或PPO训练的PPLLaVA和LLaVA-Next-Video相比,本文的PhysVLM-DPO也展现出卓越的性能,进一步验证了所提出的PhysVLM模型在通用视频理解中的出色能力。

△VCG benchmark实验结果

PhysVLM相关论文、代码、数据均已开源:

pre-prints: https://arxiv.org/abs/2412.01800

代码链接: https://github.com/PhysGame/PhysGame

leaderboard: https://physgame.github.io/#leaderboard