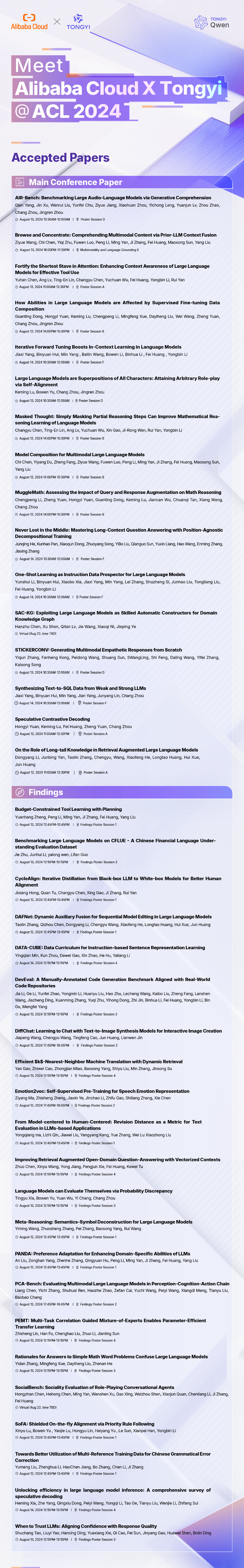

阿里云38篇论文被顶会ACL录用,通义团队披露多项大模型前沿技术

包括16篇主会论文

8月14日消息,计算语言学和自然语言处理领域的顶级学术会议ACL 2024年会本周在泰国举行,阿里云共有38篇高水平论文被大会录用,包括通义千问团队多篇大模型相关论文,主题涉及大模型SFT技术、LLM角色扮演能力、多模态模型测评基准等。设在曼谷大会现场的通义展台被世界各地的NLP研究人员和开发者围观,通义成了现场最受关注的中国大模型。

ACL 年会(Annual Meeting of the Association for Computational Linguistics)由国际计算语言学协会组织,是计算语言学和自然语言处理领域排名第1的顶级学术会议。ACL 2024是该协会的第62届会议,今年大会特别关注“以开放科学、开放数据、开放模型促进可复现的自然语言处理研究”这一话题。

阿里云一直以来都是ACL论文入选数量最高的科技公司之一,今年累计有38篇文章被收录,包括16篇主会论文。作为中国大模型“开源开放”力量的代表,通义大模型团队在本次大会披露了多项大模型前沿技术,并与世界各地的NLP研发人员和开发者面对面交流。

《Large Language Models are Superpositions of All Characters: Attaining Arbitrary Role-play via Self-Alignment》首次提出用于大模型角色扮演的自我对齐策略DITTO,显著提升了LLM的角色扮演能力,通义团队已将DITTO开源;《AIR-Bench: Benchmarking Large Audio-Language Models via Generative Comprehension》介绍了通义团队推出的音频语言理解模型测评基准AIR-Bench,用于评估模型的生成式指令跟随能力,填补了业界空白;《How Abilities in Large Language Models are Affected by Supervised Fine-tuning Data Composition》通过一系列实验展示了SFT数据如何影响LLM的数学、代码、人类对齐能力,可为研究者和开发者的SFT工作提供借鉴。

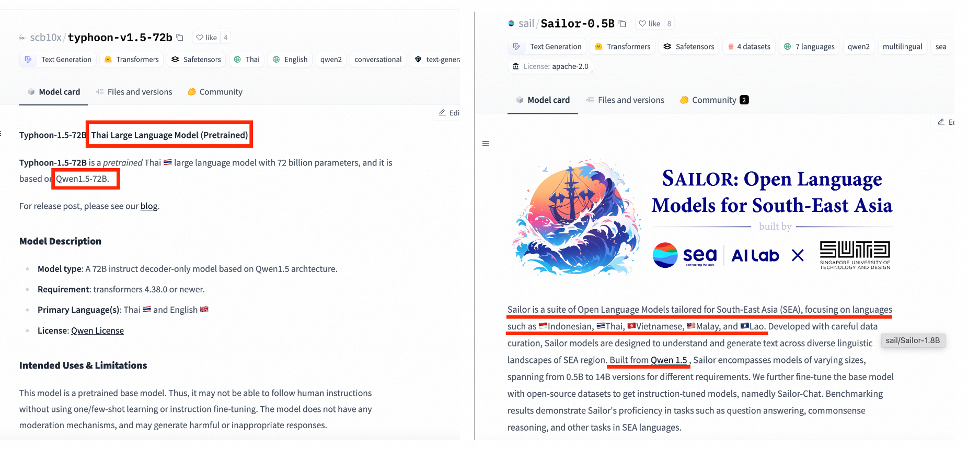

海外开发者基于Qwen训练了泰语大模型和东南亚语大模型

自2023年8月以来,通义千问已经开源数十款LLM、多模态和专项能力模型,Qwen系列开源模型下载量超过了2000万。

在东南亚地区,通义千问开源模型也有很多忠实用户,开源社区经常可见基于Qwen训练的泰语、越南语、东南亚语等大模型。比如,新加坡工程师刘乾基于Qwen1.5训练了广受欢迎的东南亚语大模型Sailor,覆盖0.5B、1.8B、4B、7B、14B等全套尺寸;越南语工程师Nguyen Quan开发了越南语大模型,他说:“根据我们内部的基准测评,Qwen2基础模型超越了目前市场上所有的闭源大语言模型”。

附:阿里云被ACL 2024收录的论文清单

- 元戎X火山|AI汽车加速进化2025-04-24

- 蚂蚁数科开源虚拟机DTVM,开启区块链AI开发时代2025-04-24

- 热爱让“她力量”无限进阶,2025璀璨女性影响力大会北京圆满举办2025-04-23

- 分化浪潮中的投资新局|第19届中国投资年会·年度峰会在京召开2025-04-23