CSDN「智研社-The Intelliger」共话大模型技术演进与 AI Infra 创新

进行 AGI 相关前沿科技的深入探讨

7 月 28 日下午,CSDN 高端技术领导者社群「智研社-The Intelliger」第三期活动在北京鼎好超互联 AGI 科技生态创新空间成功举办。

活动特别邀请到 Stability AI 机器学习运维主管、知名 AI 开源组织 LAION 工程负责人 & 创始人 Richard Vencu 和 CSDN 创始人 & 董事长、中国开源软件推进联盟副主席蒋涛进行深度对话,CSDN 高级副总裁李建忠、Momenta 工程质量负责人邹欣、华为“天才少年”申博、白海科技创始人卢亿雷、荣耀首席专家张轶博等重磅嘉宾到场,汇聚了大模型技术专家、大厂技术大牛、大模型公司 CXO、生态合作伙伴代表。现场嘉宾一起交流思想、分享经验,进行 AGI 相关前沿科技的深入探讨。

第三期智研社-北京站活动现场合影

「智研社-The Intelliger」由 CSDN CTO 俱乐部重磅升级而来。CSDN 高级副总裁李建忠在开场中为大家介绍了智研社未来发展的三个方向:

一是为技术人提供充分沟通交流的平台;

二是提供 AGI 技术发展与应用实践的探讨与合作空间;

三是带领中国 AGI 技术人走向全球,参与国际 AGI 技术交流,抓住 AI 爆发带来的机遇。

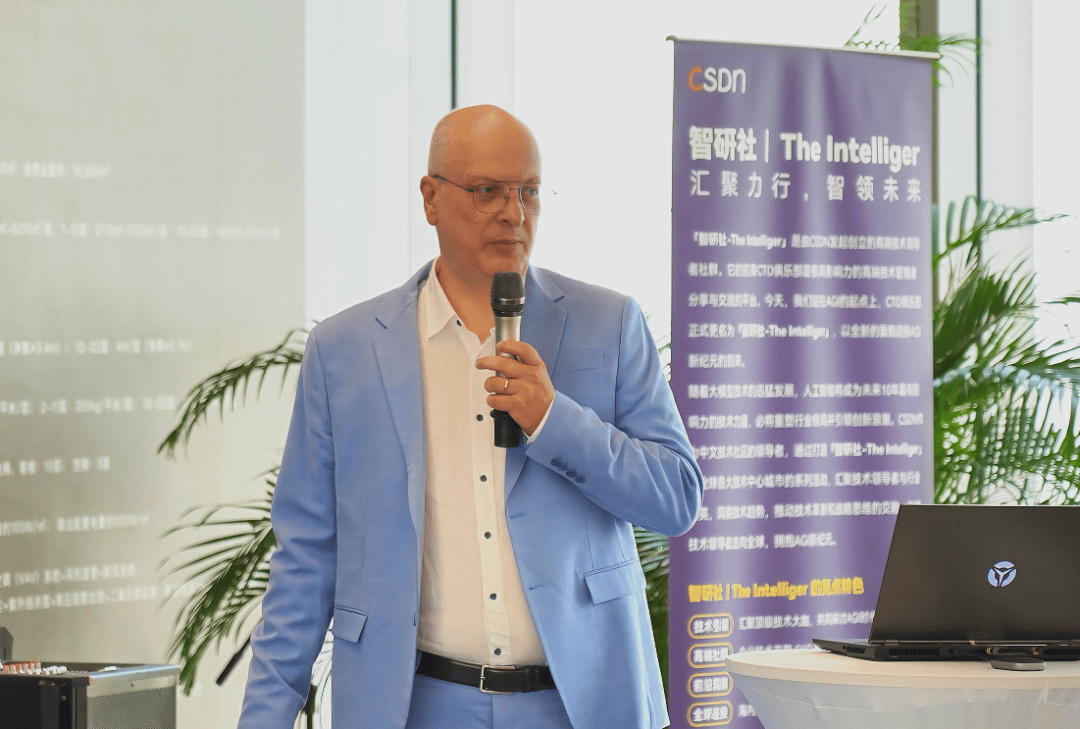

在当今快速发展的人工智能领域,大规模计算资源的管理成为了一个关键挑战。Stability AI 机器学习运维主管、知名 AI 开源组织 LAION 工程负责人 & 创始人 Richard Vencu 在现场带来了《在 AWS 云上打造 Stability AI 超级计算机》的主题演讲,深入阐述了在云环境中运行 5000 个 GPU 的经验,揭示了这一规模计算所面临的挑战及其解决策略。

Richard Vencu,Stability AI 机器学习运维主管、LAION 工程负责人 & 创始人

核心挑战在于:

机器学习训练与推理的差异:Vencu 指出,机器学习训练本质上不是一个网络问题,而机器学习推理则是。这种区别源于推理需要通过标准化的网络通道向全球用户提供服务。

多团队需求管理:不同 AI 团队对规模和上市时间的要求各不相同,导致优先级不断变化。这要求资源管理系统具有高度的灵活性。

共享环境中的信任问题:在共享的高性能计算(HPC)集群中,用户通常无法获得 root 访问权限,这限制了系统的灵活性。

大规模资源管理:主要目标是减少 GPU 的闲置时间,提高利用率,并减少因缺陷导致的停机时间。

使用追踪:需要精确追踪每个项目和用户的资源使用情况,以便进行报告、税务处理和计费。

作为解决方案,Vencu 推荐使用 SLURM 作为资源调度器。SLURM 是一个有20多年历史的开源系统,维护良好,提供抢占和重新排队机制(脚本需要意识到这一点并能够自行恢复)、跨不同优先级的优先机制和公平共享机制。这些功能有效解决了最大的挑战——最小化 GPU 闲置时间。

在现场,Vencu 和到场嘉宾进行了互动,为那些希望在云中部署大规模 AI 计算资源的开发者提供了宝贵的见解和实践指导。云环境中管理大规模 GPU 资源是一项复杂的任务,涉及多个方面的挑战。通过采用适当的资源调度策略、严格的安全措施、灵活的项目管理以及全面的监控系统,可以显著提高资源利用率,降低成本,同时满足不同团队的需求。

随着大模型的广泛应用,AI 技术已经在自然语言处理、计算机视觉、多模态理解等领域取得了显著的突破。大模型强大的生成能力和理解能力,还在各种领域的实际应用中展现了巨大的潜力。然而,大模型的训练和推理需要庞大的计算资源,AI 基础设施(AI Infra)的建设成为了当前技术发展的关键。

为了解答这一系列问题,由 Momenta 工程质量负责人、CSDN 《新程序员》内容顾问邹欣主持,Stability AI 机器学习运维主管、知名 AI 开源组织 LAION 工程负责人 & 创始人 Richard Vencu 和 CSDN 创始人 & 董事长、中国开源软件推进联盟副主席蒋涛展开圆桌对话,围绕“2024 大模型技术演进与 AI Infra 创新”的话题进行了多个方面的探讨。

以下是他们对每一方面内容的讨论焦点:

计算机系统的架构转变

- 当前,我们正在从以 CPU 为中心向以 GPU 或其他 AI 加速器为中心的模式转变。这种转变意味着计算任务将更多地依赖于专门化的硬件,以提高处理速度和效率。

- 未来可能进入“软件 2.0”时代,编程将不再仅仅依靠代码,而是利用数据和神经网络来驱动程序的执行。这表明软件开发的方式将发生根本性的变化,更加依赖算法和数据处理能力。

- 多家公司正在开发专用 AI 芯片,竞争格局尚未明朗。这预示着未来硬件市场的竞争将非常激烈,且可能会出现新的行业标准和生态系统。

大模型与小模型并存发展

- 超大规模集群支持的通用大模型将继续发展。这些模型通常需要大量的计算资源,能够处理复杂的任务和大规模的数据分析。

- 端侧小模型也很重要,用于特定场景和保护隐私。这意味着在设备端进行高效且安全的数据处理将成为一个重要的研究方向,特别是在涉及敏感信息时。

- 两种模型各有优势,将并行发展。这种多样化的策略可以确保在不同的应用场景中都能找到合适的解决方案。

开源 vs 闭源模型

- 结合 NVIDIA CEO 黄仁勋近日提出的“孪生地球”观点,具体分析 Linux 基金会和 Apache 基金会等典型的开源项目案例,在场嘉宾讨论了开源模型未来的商业化和产业化问题。如今像 OpenAI 这样的领先公司仍缺少“护城河”,所以长期来看,开源模型可能会超过闭源模型。

- 开源促进了模型的快速迭代和改进,允许更多的开发者参与到项目中,从而加速了技术的成熟和应用的广泛性。

- 但在某些领域,闭源模型仍可能保持优势。闭源模型提供了更好的控制和安全性,对于某些对数据安全有极高要求的行业来说尤为重要。

数据与训练挑战

- 高质量训练数据对模型至关重要。这意味着获取和标注大量高质量的数据集将是未来发展的一个重点。

- 未来可能需要更多物理世界的数据。随着技术的进步,如何有效地收集和利用现实世界中的数据将成为提升模型性能的关键因素之一。

- 数据开源和共享可能成为一个重要话题。这不仅有助于提高数据的质量和多样性,还促进了跨组织之间的合作和知识共享。

AGI 展望

- 当前,人工智能处于早期阶段,业界对 AGI 实现的时间表和可能性存在不同看法。尽管人工智能已经取得了显著进展,但要达到真正的通用人工智能水平仍然充满挑战和不确定性。这需要持续的研究和技术突破。

- 在场嘉宾积极提问,就开源闭源之争、具体工程实现、未来 AI 硬件问题和 AGI 愿景等多个角度展开精彩的交流互动。

现场掠影,嘉宾互动活跃

「智研社-The Intelliger」是由 CSDN 发起创立的高端技术领导者社群。「智研社-The Intelliger」的前身为 CTO 俱乐部,自 2009 年由 CSDN 创办以来,是极具影响力的高端技术管理者分享与交流的平台。随着大模型技术的迅猛发展,人工智能将成为未来 10 年最有影响力的技术力量,必将重塑行业格局并引领创新浪潮。CTO 俱乐部正式更名为「智研社 The-Intelliger」,意味着其将以全新的面貌迎接 AGI 新纪元的到来。

- 阶跃星辰推出开源 SOTA 图像编辑模型,一个月连发三款多模态模型2025-04-27

- 清华系智谱×生数达成战略合作,专注大模型联合创新2025-04-27

- 夸克AI超级框上新“拍照问夸克” 加码多模态能力2025-04-27

- 一季度超百万辆!比亚迪凭实力书写行业 “霸榜” 传奇2025-04-27