风口预警!Meta一分钟文本转3D模型炸场,游戏规则已改变,赛道着火了

包括高质量纹理和PBR材质贴图

西风 发自 凹非寺

量子位 | 公众号 QbitAI

Meta放大招!发布3D生成最新成果——Meta 3D Gen。

号称1分钟内即可文本端到端高质量转3D,包括高质量纹理和基于PBR材质(基于物理的渲染)贴图的3D Mesh。

支持修改已有的3D对象/模型的纹理。

例如,编织风:

像素风:

暗黑恐怖风:

单拎出来一只金属哈巴修狗,毛发纹理等各种细节拉满:

搭配其它工具装上骨架让3D模型动起来,效果也可以用“精细”两字形容:

有网友看到此效果直呼“改变行业游戏规则”、“改变工作流程”。

还有不少网友认为生成的模型可以直接3D打印了:

不过,这次Meta 3D Gen的发布木有代码,木有Demo可玩。

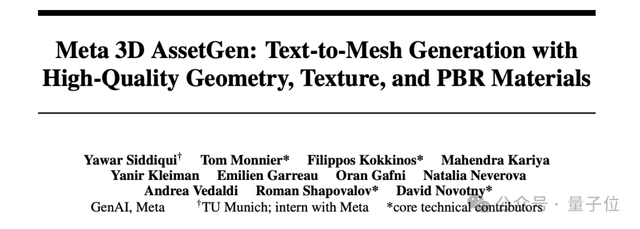

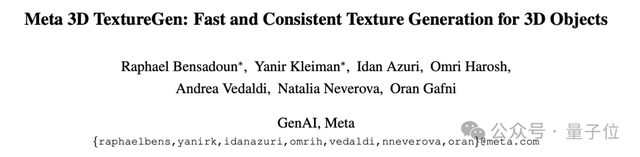

与效果一同发布的,是一份技术报告以及两篇论文,介绍了Meta 3D Gen背后用于文本到3D生成和文本到纹理生成的方法。

3D对象生成器+纹理生成器

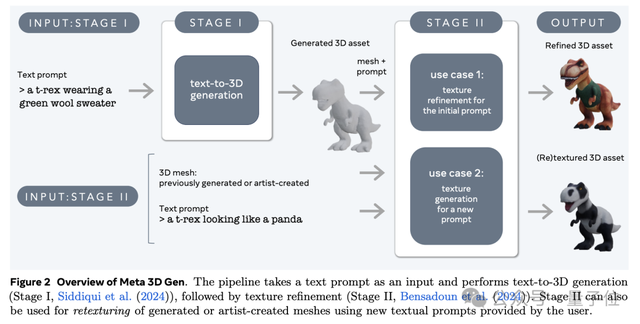

翻看技术报告,原来Meta 3D Gen是一种组合系统,基于Meta另外两项研究,即同时发布的两篇论文:Meta 3D AssetGen、Meta 3D TextureGen。

Meta 3D AssetGen用于文本到3D对象的生成(第一阶段),Meta 3D TextureGen用于文本到纹理的生成(第二阶段),两者是Meta 3D Gen的关键组件。

AssetGen负责从文本描述生成完整的3D对象,其工作流程大致为:

1)用一个神经网络根据文本描述生成多个2D视图;

2)使用另一个神经网络从这些2D视图重建3D Mesh和初始纹理;

3)通过融合重投影的纹理来优化初始纹理。

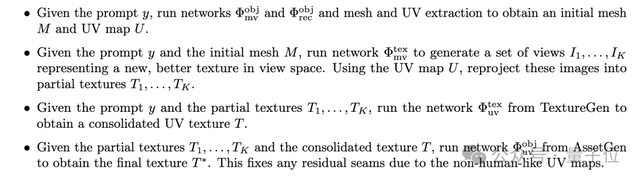

TextureGen负责为给定的3D对象生成纹理。它接收一个3D对象(包含形状和UV坐标信息等)和一个文本描述作为输入,工作流程大致为:

1)使用一个神经网络生成这个3D对象的多个2D视图;

2)将这些2D视图重新投影到对应的纹理图像上;

3)另一个神经网络将这些纹理和原始文本描述结合,生成一个完整的UV纹理;

4)可以选择使用一个超分辨率网络来提高纹理的分辨率。

值得一提的是,TextureGen中的纹理融合和增强网络基于3D艺术家提供的“真实”UV图进行训练,与AssetGen生成的自动提取的UV图大有不同。

而Meta 3D Gen集成了这两种方法,所以整体流程是:

首先使用AssetGen生成初始的3D形状和UV映射。然后,使用TextureGen的第一个网络,基于这个3D形状生成更高质量的2D视图。接着,使用TextureGen的第二个网络,从这些高质量视图生成统一的UV纹理。最后,使用AssetGen的纹理优化网络进行最终的纹理融合和增强。

以下是在Meta 3D Gen在第一阶段(左)和第二阶段(右)后的视觉对比:

方法细节,感兴趣的家人们可以查看技术报告和论文,重点来看效果测试。

404个文本提示评估

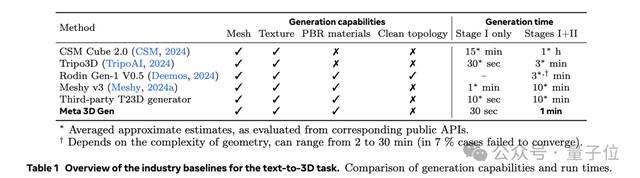

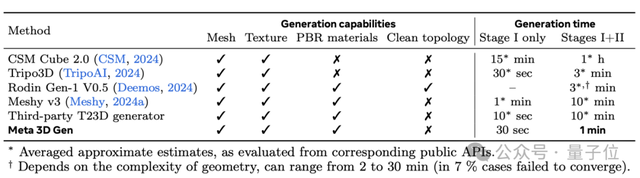

基准测试部分,Meta 3D Gen的比较对象包括:CSM Cube 2.0、Tripo3D、Rodin Gen-1 V0.5、Meshy v3和一个第三方文本转3D生成器。

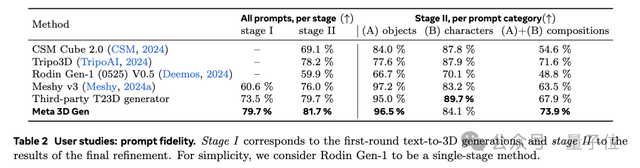

定量比较方面,Meta使用了404个来自DreamFusion的不同文本提示(分为物体、角色和组合场景三类,难度由低到高)让模型进行3D生成。

然后让普通用户和专业3D艺术家对模型在不同测试类别中的表现进行评估和打分,评估指标包括提示保真度、整体视觉质量、几何质量和纹理质量。

评估针对每个模型单独进行或通过随机A/B测试来比较不同模型的表现。

根据Meta的测试结果,首先在生成时间方面,Meta 3D Gen仅需1分钟,超越所有其它方法(3分钟到1小时不等):

文本提示保真度,即模型的生成与文本prompt的符合度,Meta 3D Gen和其它模型的比较结果如下:

整体Meta 3D Gen效果最佳,Tripo3D、Third-part T23D generator与其相差不大,CSM Cube 2.0、Rodin Gen-1 V0.5稍显逊色。

值得一提的是,用于对比的工业基线中,Tripo3D来自国内玩家VAST,Meshy则是胡渊鸣在太极图形之后创办的独立新品牌。

在难度最高的组合类场景生成中,Tripo3D排名第二,与Meta 3D Gen相近,但却在最简单的物体生成上表现不如Meta,拉低了整体评分。

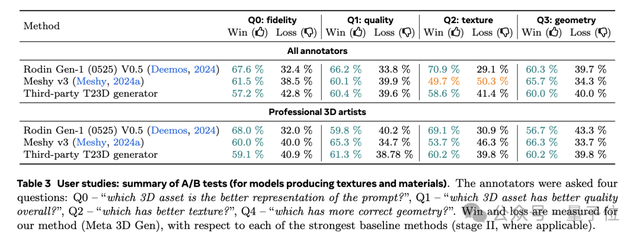

A/B测试方面,主要是为了比较Meta 3D Gen和那些同时生成纹理和使用PBR材料的基准模型。所有用户、仅专业3D艺术家的评估结果分别如下,Meta 3D Gen在大多数指标上表现优于竞争者:

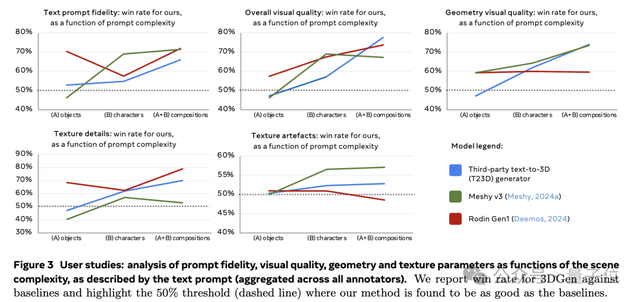

此外,Meta还分析了不同3D生成模型在处理不同复杂度的场景时的性能,下图是Meta 3D Gen与基线方法相比的胜率。

纵坐标是Meta win rate,低于50%说明对比方法比Meta好,折线越低方法越好。

结果显示,随着场景复杂度增加,例如从单一对象过渡到包含多个角色和元素的复合场景生成,Meta 3DGen的表现开始显著优于其它模型。

接下来再看定性比较。

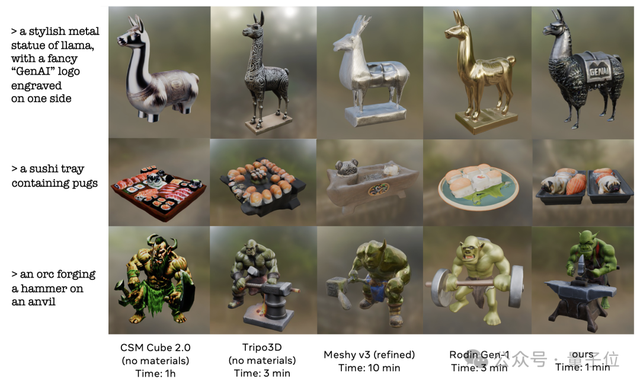

相同提示词,不同模型文本提示保真度对比是这样婶儿的:

除了Meta 3D Gen,Tripo3D表现也不错,比如第一个生成带有“GenAI”logo的金属羊驼的例子,Meta 3D Gen虽然在logo生成上表现很好,但腿部生成明显有缺陷,而Tripo3D的腿部生成更胜一筹,且纹理细节也很好。第二个寿司测试,CSM则表现优异。

第三个“半兽人在砧板上锻造锤子”的例子,Tripo3D和Meta各有优势。Tripo3D纹理和几何细节更丰富、orc更保真、“锻造锤子”也展现出来了;Meta的砧板相对好些,但整体纹理细节差些。

其它几个模型的结果语义丢失严重。

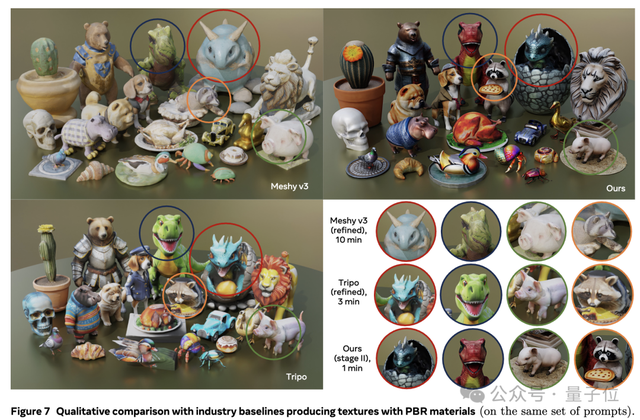

此外,针对纹理的对比结果如下,在下面的这张图中,Meta 3D Gen的纹理细节处理的很细致:

3D生成赛道真热闹

Meta 3D Gen的发布,无疑给持续升温的3D生成赛道又添了一把火。

在对比测试中,也不乏国内玩家的身影,比如Tripo 3D就是由AI初创公司VAST在今年初推出的3D生成大模型。

VAST创始人兼CEO为宋亚宸,此前在商汤负责AIGC技术在动画及游戏等行业实际落地,也曾参与创立AI独角兽Minimax。CTO梁鼎是商汤的通用模型负责人、首席科学家曹炎培曾在腾讯AI Lab领导AIGC 3D方向的研发工作。

此外,Meshy模型也是由国内玩家打造。

Meshy联合创始人兼CEO是计算机图形学知名学者胡渊鸣,胡渊鸣毕业于清华大学姚班,也是MIT博士、太极(TaiChi)编程语言作者。

说回Meta 3D Gen,虽然根据Meta的技术报告,Meta 3D Gen的表现在很多方面超过了基准模型,不过也有人对此测试结果表示存疑。

首先在生成时间上,就有网友表示给CSM Cube 2.0标的时间不准确:

据量子位测试,其实Tripo3D最新Web版生成时间也缩短了,Stage1是10秒左右,Stage2现在只需要2分钟。

据量子位在Tripo Discord beta频道测试,Tripo3D新版几何质量也有了进一步提升:

Tripo团队发文表示更好的几何和PBR都在路上了:

另一边,胡渊鸣也发推文表示,Meshy很快就会发布速度提升10倍的模型。

Rodin团队也出面表示欢迎Meta加入3D生成赛道,未来想制定更综合和合理的3D生成评判标准。

除此之外还有网友认为,没有Demo大家又玩不上,对于Meta 3D Gen很难评。

雀食,Tripo3D、Meshy等模型都是可以玩的。

而且还不是简单玩玩,开头网友说的3D打印甚至已经落地了。

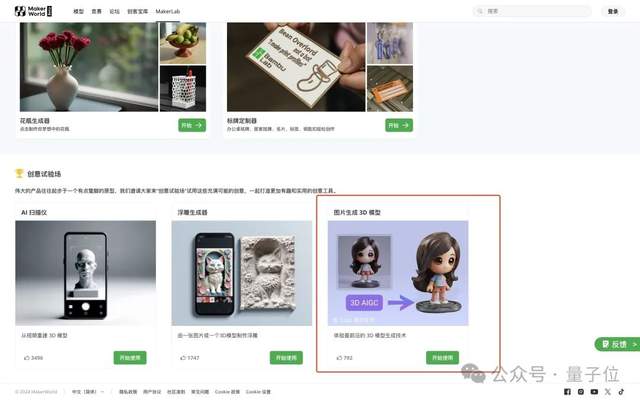

就拿Tripo3D来说,不仅在全球最大的3D素材交易网站-CG模型网已上线艺术家内测版本:

而且已经和全球家用3D打印机龙头企业们达成合作,拓竹的Markerworld和Anycubic旗下的模型社区网站Makeronline等都已上线,3D打印爱好者们可以尝试起来了!

在行业探索上,Meshy之前和Snap达成合作上线了AI 3D特效,CSM则做了更多产品化的探索,上线了Cube。

全球AI艺术家也在3D生成赛道上卷起来了,Tripo上个月做了全球第一个AI 3D全球渲染大赛,目前正在和CivitAI一起举办AI电影大赛Project Odyssey。

这次泼天的热度算是落到3D生成赛道了。

参考链接:

[1]https://x.com/AIatMeta/status/1808157832497488201

[2]https://ai.meta.com/research/publications/meta-3d-gen/

[3]https://x.com/tripoai/status/1808427964339470445

[4]https://x.com/DeemosTech/status/1808207652188836020

[5]https://x.com/YuanmingH/status/1808352082824683818

- 新晋顶流Agent颠覆设计师!Lovart一手实测来了:是该刷屏爆火2025-05-15

- 鹅厂放大招,混元图像2.0「边说边画」:描述完,图也生成好了2025-05-16

- 一个「always」站在大模型技术C位的传奇男子2025-05-10

- 机器人开始抢“主持人”饭碗!上海张江,傅利叶宣布下个十年规划,要做“以人为本的具身智能”2025-05-10