自动驾驶要啥实路测试?L4当红独角兽新模型:2D视频输入4D场景输出!难怪老黄看好

CVPR分享最新成果

一凡 发自 副驾寺

智能车参考 | 公众号 AI4Auto

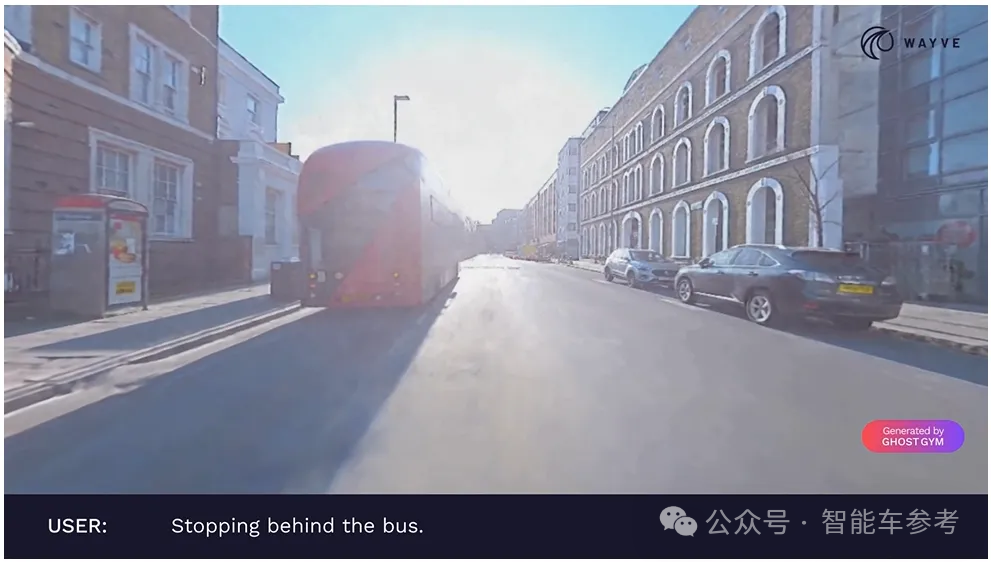

用视频生成的仿真场景,能有多逼真?

两旁的行人,前车的刹车灯……连这些细节,都能动态显示地清清楚楚。

两辆自行车行驶在道路中间,避让通过:

这就是如今自动驾驶“当红炸子鸡”Wayve,在CVPR 2024上分享的最新成果:

自动驾驶仿真模型PRISM-1,没有激光雷达,没有3D标注信息,只基于摄像头输入的信息。

PRISM-1:利用视频数据重建4D真实场景

模拟仿真测试是自动驾驶的重要环节。

实车测试周期长,成本高,覆盖的工况和长尾问题有限,尤其是极端场景下的Corner Case,实车测试比较危险,且调试程序后,可能不好复现验证。路还是那条路,但路况和道路参与者一直都在变。

因此,通过合成数据,仿真测试自动驾驶系统的路线,正在受到关注。

成本低,配置灵活,场景覆盖率高,对特殊的Corner Case能够复现后再验证,可以与实车测试形成互补。

不过自动驾驶模拟仿真也面临着诸多挑战,比如在场景重建环节,复杂的城区道路,有很多动态元素难以准确呈现,像行人和自行车,不仅形态各样,而且行为灵活难预测。

传统还原通过场景图的方式,将元素组织成层次结构,用节点表示场景中的实体,用彼此的边缘表示它们之间的关系。

这种方式不够灵活,因为当车辆模拟测试时,周边场景其实一直在动态改变,一些元素无法完美分离,会导致错误传播。

为了突破传统方式的局限,Wayve转向更灵活、能自适应的模拟方案,在端到端的基础上,提出了PRISM-1模型。

主要是三个特点:

- 框架更灵活:能有效处理常见元素,模拟移动元素,甚至包括瞬态场景元素,比如风吹动的树叶,隧道中的波动光线。

- 自监督场景分离:无需标注或预定义模型,分离场景中的动态元素和静态元素。

- 可扩展表示:即使场景复杂度增加,PRISM-1仍能保持高效。这最大限度地减少了工程量和错误传播。

详细过程,Wayve没有披露,只是主要介绍了视图合成方面的创新点。

具体地说,PRISM-1重点关注摄像头观测到的路径的偏差。

无需依赖其他传感器,只靠摄像头,获取车辆行驶时的一组稀疏图像,重建4D场景。

当然,用摄像头获取数据场景数据,有一个天然限制,那就是在动态场景下,只能从一个视角拍摄其中的元素。

如何在任意时刻,从不同视角重建4D场景?

PRISM-1在承认车子动态特性的前提下,通过两种方式改变摄像头路径:

第一种方式,冻结时间。

测试车辆周遭一切都暂停了,场景的时间维度不变,但空间可变,摄像头左右平移,以不同角度查看周边场景。

第二种方式,冻结空间。

测试车辆自身保持静止,空间数据不变,但时间还在变化,周遭事物还能运动,观察其变化。

两种方式结合,Wayve可以利用PRISM-1从各种视角重建场景,甚至复现一些细节,比如前车刹车灯亮了。

Wayve还将在此基础上,继续迭代工作。

下一步,Wayve打算加强模型的可扩展性和灵活性。

比如,用模型去重建一个“行人通过斑马线”的场景。

如果需要,也可以把行人移除掉。

推出PRISM-1,提高自动驾驶模拟的真实性,加快算法迭代的同时,Wayve还开源了一个场景数据集WayveScenes101 Dataset,顾名思义,包含了101个复杂动态场景。

涵盖了英美两地,不同的驾驶环境和路况,包括多种天气和光照条件下的城区、郊区和高速公路。

当然,能被微软和英伟达同时相中押注,Wayve的工作成果远不止这些。

自动驾驶独角兽,微软英伟达都投了

遍观全球,最近一段时间,特别是在自动驾驶领域,很少有独角兽,能盖住Wayve的风头了。

5月7日,Wayve官宣了10.5亿美元(折合人民币约为75.8亿元)的新一轮融资。

软银领投,微软和英伟达跟投。

数额之巨,投资者阵容之豪华,实属罕见,轰动一时。

在此前,只有Waymo、Argo和Cruise等,获得过这个级别的融资。

Wayve一举刷新英国AI公司单笔融资的记录,连英国首相也在声明中表示,这「巩固了英国作为AI超级大国的地位」。

彼时的Wayve都有什么技术成果,吸引巨头押注?

主要是一个架构,两个模型:

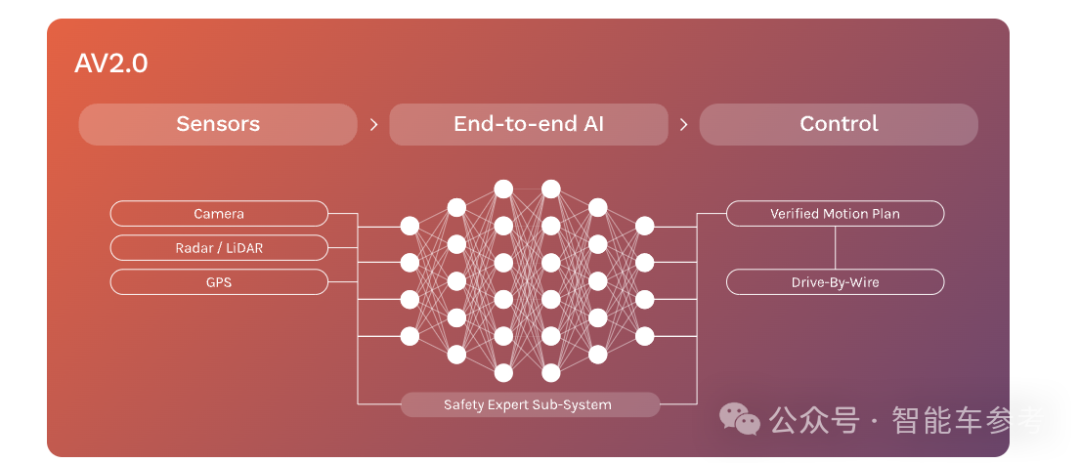

一个架构是指端到端的AV 2.0,不依赖高精地图,Wayve称可兼容纯视觉和激光雷达多种方案。

两个模型是指LINGO系列以及GAIA-1,分别是Wayve在AI的可解释性与AIGC上的成果。

首先来看LINGO系列,去年9月,Wayve推出了LINGO-1模型。

Wayve将其称之为VLAM(视觉-语言-动作模型),与传统技术范式不同的是,视频数据之外,Wayve还引入了老司机语音包进行训练:

Wayve请来很多专业司机,要求他们在开测试车辆做出相应操作时,大声说话,解释自己为什么这么做。

这样,自然语言就被引入了自动驾驶,LINGO-1实现了在开车时,解释自己的决策逻辑,这提高了模型的可解释性。

这项工作最近升级至LINGO-2,进一步增强了人车交互,司机可以通过限定的命令,比如「靠边停车」,调整智驾的开车策略。

另外一个模型则是GAIA-1,是一个为自动驾驶打造的多模态生成式世界模型,参数规模90亿。

输入视频、文本和操作,就能生成逼真的自动驾驶视频,不同路况和天气,效果都能以假乱真。

诶等等,GAIA-1能生成自动驾驶测试的视频,PRISM-1能用视频模拟真实场景,两个一结合,这不就闭环了吗?doge

当然没有这么简单,在去年6月,Wayve推出GAIA-1早期版本后,就有相关研究人员指出,模型生成的视频中,会有一些元素在后续“突然消失”,还不完善。

虽然去年10月,Wayve更新了GAIA-1,扩大了参数规模,增加了训练时长,模型生成视频的细节和分辨率都有明显提升,但是否完全克服了“元素突然消失”的问题,还有待充分验证。

引领Wayve打造这些成果的,是两位联合创始人:

Alex Kendall(亚历克斯·肯德尔)与Amar Shah(已退出)。

两人都是剑桥大学机器学习专业的博士,于2017年创立了Wayve。

其中肯达尔去年曾陪同比尔·盖茨试乘旗下产品,比尔·盖茨后来点赞其工作:

That was fantastic!

或许是这次试乘打动了比尔盖茨,微软连续两次出手,投资Wayve。

Wayve也是不负所托,最近一年频频拿出成果,给行业带来惊喜。

时值CVPR 2024,Wayve也举办了一系列活动,PRISM-1研究人员就在现场。

到场的朋友,可以去#1712展台交流交流。

- 上海车展见证历史:从「西为中用」到「中为西用」,行业风向标携手Momenta2025-05-01

- 上海车展探馆:国产百万级越野限量发售,武汉造,太尊了!2025-04-29

- 上海车展探馆:本田涨智慧靠中国,Momenta辅驾护航,DeepSeek赋能座舱2025-04-29

- 上海车展对话:高阶辅驾普及改变座舱需求,7B成模型上云分水岭2025-04-29