CVPR‘24全程满分+最佳论文候选!上交大港中文等提出神经场网格模型三大定理

盲审阶段三位审稿人一致满分(5/5/5)

纯真学者出神入化 投稿

量子位 | 公众号 QbitAI

在CV、ML等领域经常用到的神经场网格模型,如今有了理论框架描述其训练动力学和泛化性能。

来自上交大,港中文和酷哇科技的研究人员,对用来表示神经场的网格模型进行了详尽的理论分析,还提出了新的模型。

该项目不仅在盲审阶段获得了三位审稿人一致的满分意见(5/5/5), 还获得了CVPR24最佳论文提名。

作者指出,利用网格模型来表示神经场是一种常见的技术,但对这些模型的系统分析仍然缺失,阻碍了这些模型的改进。

对此,作者基于正切核理论(GTK)提出了新的框架,促进了对各种基于网格模型的一致和系统的分析。

此外,该框架还激发了一个名为乘法傅里叶自适应网格(MulFAGrid)的新型模型,具有强大的泛化性能。

本工作也即将在Jittor深度学习框架平台进行实现和开源,接下来就来一起了解下。

提出网格模型新理论框架

首先了解一下什么是神经场。

神经场是基于坐标的网络,表示一个场,实质上是一种连续参数化,代表一个物体或场景的物理量。

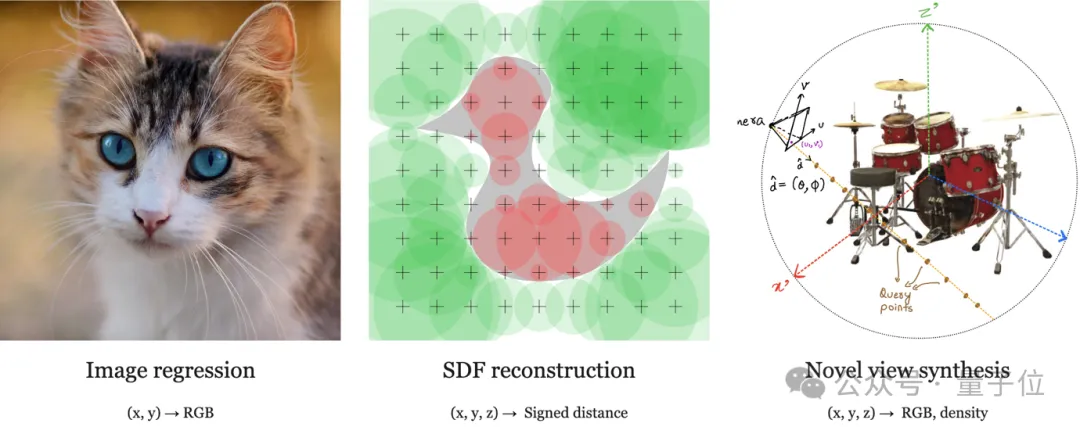

神经场在计算机视觉和其他研究领域的各种任务中显示出了显著的成功,其典型应用如下图所示:

神经场有多种不同的模型类型,作者的研究主要针对其中的网格模型(grid-based models)展开。

网格模型在参数化和功能上与传统的神经网络(如MLP)有根本不同,主要包括:

- MLP往往包含多层非线性神经网络;

- MLP没有显式查询的过程;

- MLP的输入不一定是位置坐标。

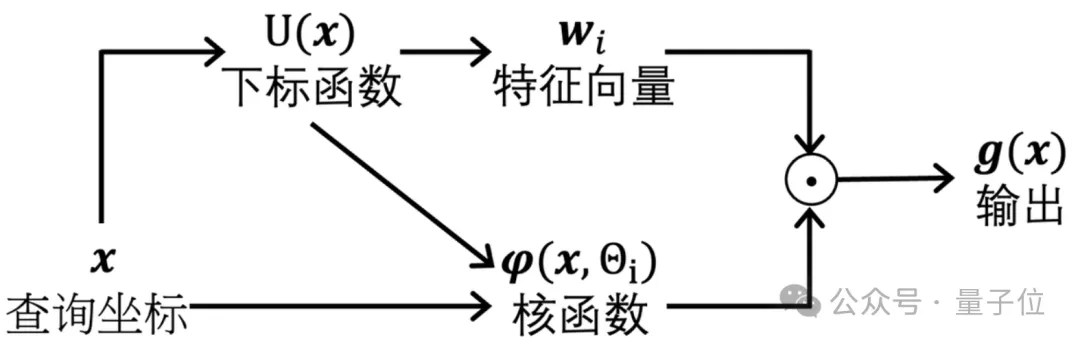

而网格模型以查询坐标为输入,该坐标被发送到下标函数以从网格中获取一组特征向量。

然后,模型输出核函数和这些特征向量的加权平均值,该模型需要学习参数的主要是特征向量。

最简单的核函数是不含参数的插值算法(如最近邻算法或者双线性插值算法),核函数里面也可以包含可学习的参数。

为了更好地理解和增强网格模型,作者通过三个主要问题进行了研究:

- 如何理解网格模型的训练动态?

- 如何衡量网格模型的泛化性能?

- 如何设计一个更好的网格模型?

为了解决这些问题,研究团队提出了一个基于正切核(Tangent Kernels)的理论框架。

正切核这一概念来自于著名的深度学习理论文章神经正切核(Neural Tangent Kernels,NTK)。

NTK 是一种核函数,最初由研究者在研究神经网络的训练过程时提出的。

当神经网络在参数空间中靠近其初始值时,通过对神经网络梯度下降优化过程的分析,发现网络的行为可以用一个固定的核函数来描述,这个核函数就是神经正切核。比如神经网络的输出可以用其参数的梯度来表示。

在训练过程中,网络参数的更新会导致输出的变化,而这种变化在参数空间中的变化速率可以用梯度来表示。NTK 定义了两个输入数据点的输出变化之间的相似度。

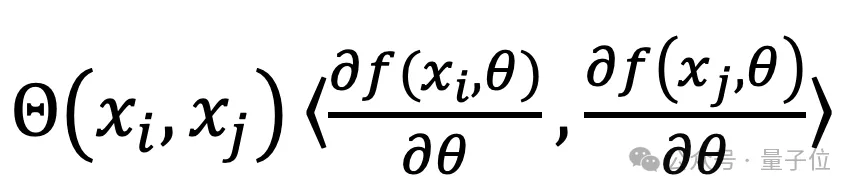

形式上,对于输入数据点xi和xj,神经正切核Θ(xi,xj)可以定义为网络输出对参数的梯度的内积:

其中,f(x,θ)是神经网络的输出,θ是网络的参数。

理论结果表明,网格模型的近似和泛化性能与网格切线核(GTK)有关。

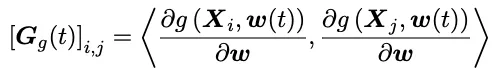

GTK被定义为一个正半定矩阵,它测量梯度空间中两个数据点之间的距离。

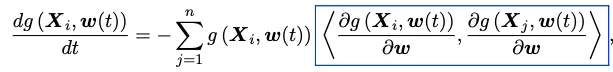

下面的式子展示了GTK的定义:g是由w(t)参数化的网格模型,X是一个数据集,其中Xi是第i个数据。GTK可以这样表示:

注意这个形式跟神经正切核(NTK)的形式是吻合的,因为他们都是正切核,他们的主要区别是适用的模型不同,GTK主要适用于网格模型。

后面可以看出,因为网格模型本质上比较简单纯粹,所以GTK的理论基本不需要近似,但是NTK的理论需要网络无穷宽的假设才能成立。

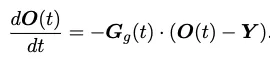

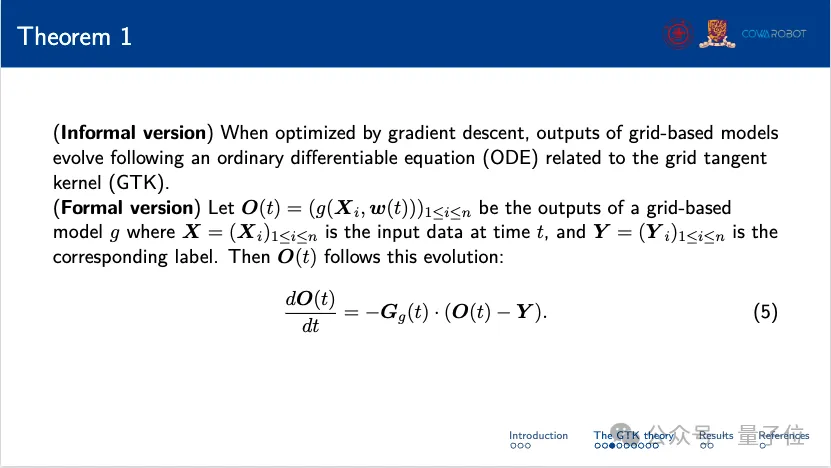

研究团队得到的的定理一(网格模型优化定理)说明,网格模型的模型参数根据微分方程(如下面方程所示)演化。

这里O(t)表示网格模型的输出,G(t)表示网格模型的GTK,而这里的Y表示数据集的标签(向量化,Yi表示第i个数据的标签)。

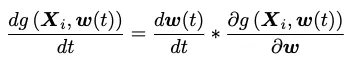

这里简单对这个定理进行一个证明,模型的参数在梯度下降算法下按照下面的公式进行迭代:

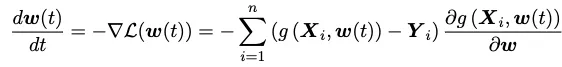

此时考虑一个L2损失函数L,它的梯度将被运用于更新模型参数,因此我有:

结合上面两个方程,可以得到:

这里蓝色方框里就是我们关心的GTK。这个定理有什么意义呢?

直观地讲,有了这个定理我们就可以预测模型的效果,也就是说不用亲自“炼丹”就能确定模型的好坏。

下面这张图小结了定理一的内容。

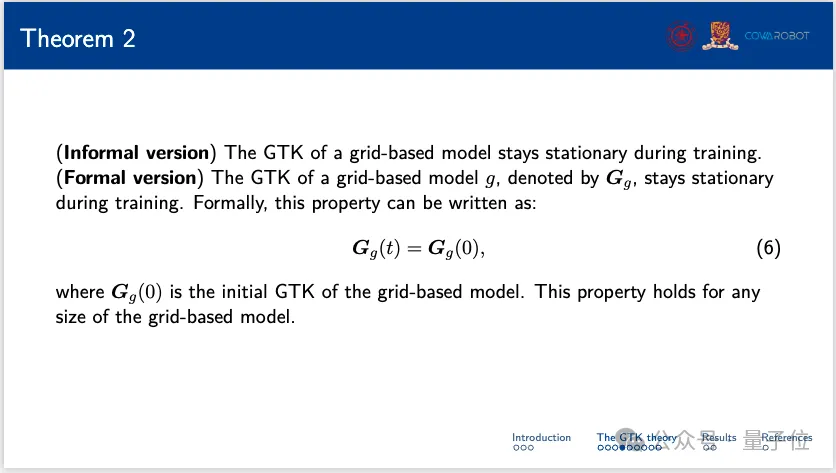

接下来,研究团队又提出了另一个定理——GTK不变定理。

定理2指出,网格模型的GTK在训练期间保持不变。这意味着无论网格模型的大小如何,初始GTK在整个训练过程中保持恒定。

这一定理揭示了GTK是由模型和数据集决定的一个内在特性,与模型的训练过程无关,有了这个定理,自然也不难理解网格模型的很多性质都与GTK有关了。

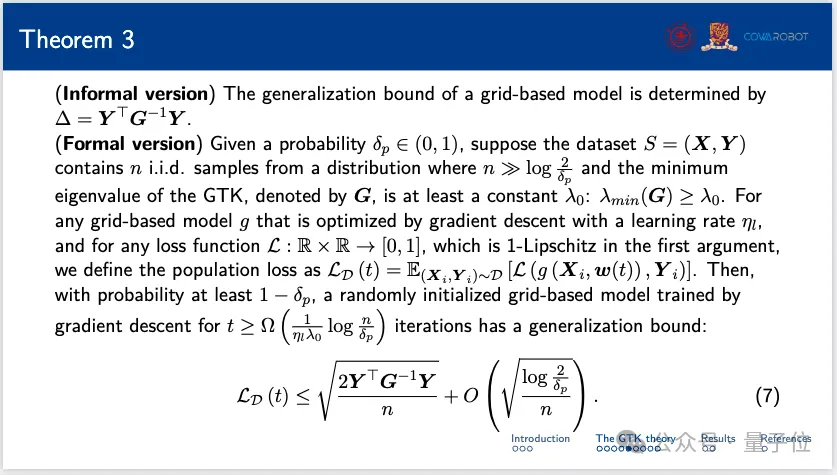

定理三则可以描述网格模型的泛化性能。

在理论深度学习中,泛化性能的好坏通常由泛化界(generalization bound)来刻画。

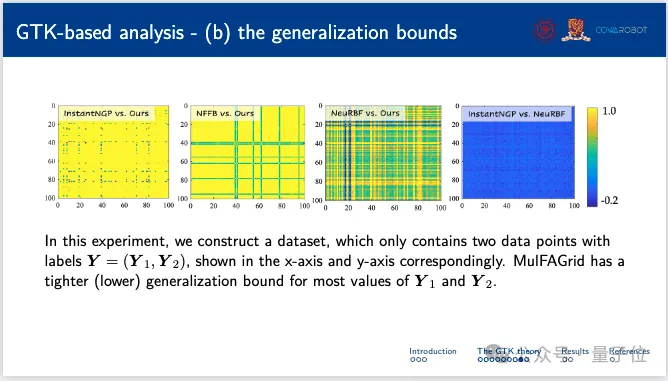

该定理揭示了网格模型的泛化界由一个特定的度量Δ决定,而Δ = Y^T·G^(-1)·Y,与网格模型的GTK和数据集的标签有关。

形式化的说,该泛化界提供了模型性能的概率保证。该定理说明了模型的泛化性能既与GTK有关,也与数据集的结构有关。结合该定理与GTK的特征值,可以获得更多关于泛化性能的信息。

基于GTK的全新网格模型及实验结果

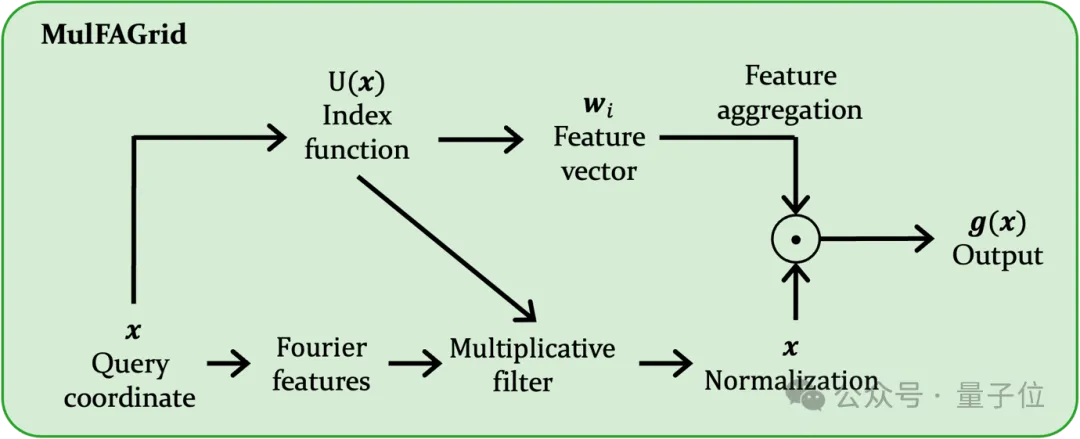

GTK理论可以为具有更好训练和泛化性能的网格模型的设计赋能,研究团队也基于该理论审计了一种新的网格模型,名为MulFAGrid。

该模型使用傅里叶特征来提升高频信号的学习,并采用乘法滤波器来为模型提供节点信息,示意图如下:

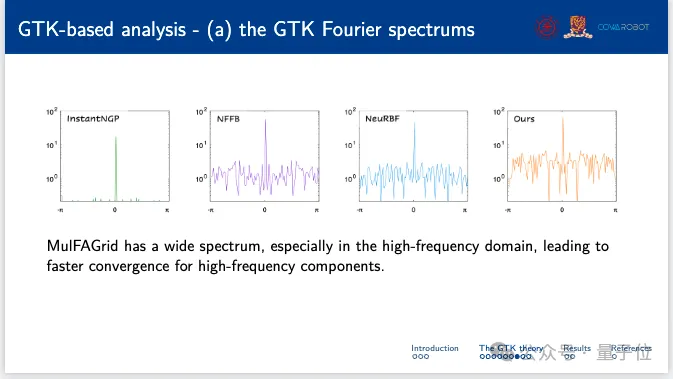

然后,作者基于GTK理论对MulFAGrid进行了一组数值实验。

首先,在频谱分析中,MulFAGrid显示了比较宽的频谱,特别是在高频域。这一特性导致高频成分的收敛速度更快。

在这个实验中,作者构建了一个包含两个数据点及其对应标签的数据集。MulFAGrid对于大多数标签值表现出更紧的泛化界,表明其泛化性能更好。

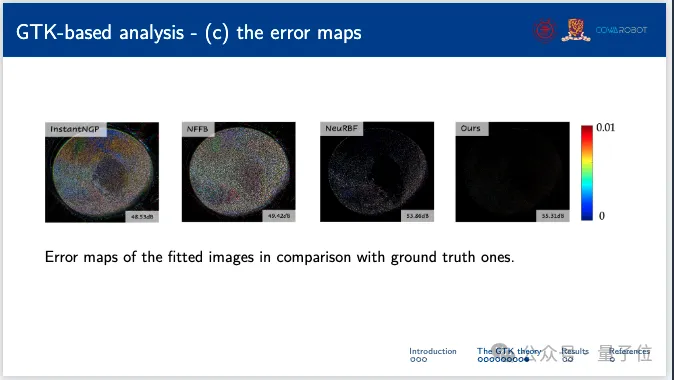

精确度方面,相对于各种基线方法和作者的误差图,MulFAGrid都提供了更准确的拟合,展示了其优越的性能。

下面的误差图衡量了预测图像与真实图像的差异。

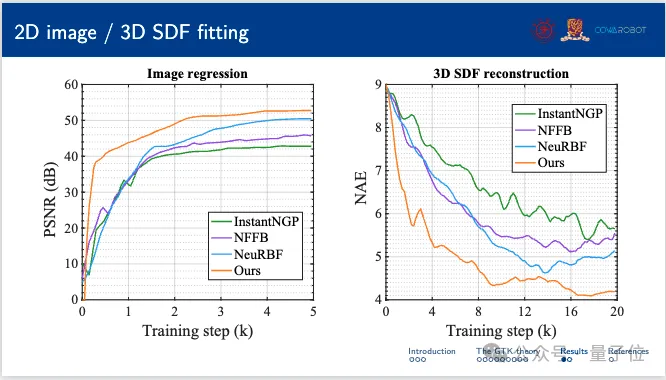

另外,模型在拟合二维图像和三维符号距离函数(SDF)的性能测试中,MulFAGrid也显现出了较高的准确性和效率。

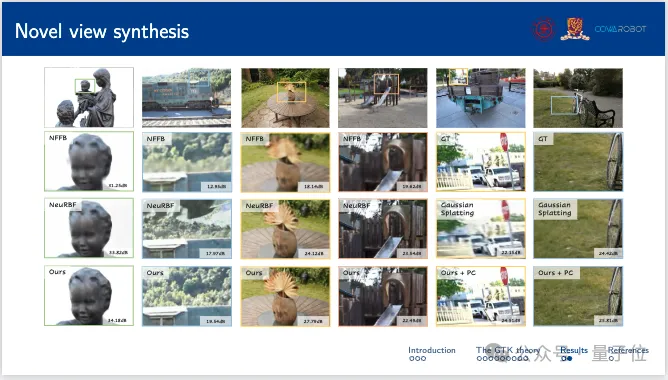

最后,作者探究了MulFAGrid在新视角合成方面的能力。详细结果表明,MulFAGrid在生成高质量的新视角方面表现出色,突显了其实际应用性。

作者简介

本文第一作者赵泽林,在上海交通大学计算机系获得学士学位,即将进入佐治亚理工学院攻读博士学位。

赵泽林曾在NeuRIPS,ECCV,CVPR,AAAI等顶会发表四篇一作论文,引用数超过600。

他所在的ReThinklab实验室由上海交通大学人工智能学院与计算机系严骏驰教授创立,主要研究方向是机器学习及交叉应用。

严骏驰教授带领实验室发表第一/通讯作者CCF-A类论文超百篇,谷歌引用过万次,获PaperDigest评选的最具影响力AAAI21、IJCAI23论文榜首。

严骏驰教授长期任机器学习三大会议ICML/NeurIPS/ICLR领域主席,模式识别旗舰期刊TPAMI、PRJ编委。实验室学生获得挑战杯特等奖、CCF优博/CV新锐奖、交大学术之星等荣誉和本科生自然科学基金。

本文通讯作者来自香港中文大学数学系研究助理教授范凤磊博士,他所在的Center for Mathematical AI由曾铁勇教授创立。中心自2018年成立以来,在中心主任曾铁勇教授的带领下,先后承担科技部国家重点研发计划项目等一系列关键项目。

范凤磊博士于美国伦斯勒理工学院(Rensselaer Polytechnic Institute)获得博士学位,导师为国际知名影像专家王革教授,主要研究方向是脑启发智能以及神经网络的数学理论,在JMLR,TMI,TNNLS,TCI等杂志发表论文二十余篇,引用数过千。曾获得IBM AI Horizon Scholarship和国际神经网络协会(INNS)2021年杰出博士论文奖。

论文地址:

https://arxiv.org/abs/2403.20002

项目主页:

https://sites.google.com/view/cvpr24-2034-submission/home

- 装满智能体AI的手机,正在呼唤一个“Type-C时刻”2025-04-16

- 英伟达含量为零!华为密集模型性能比肩DeepSeek-R1,纯昇腾集群训练2025-04-15

- Llama 4遭竞技场背刺!实锤用特供版刷榜,2000+对战记录公开2025-04-08

- “AI眼镜的终极功能,是AI+社交” | 对话影目科技创始人2025-04-07