缓存驱动联邦学习架构来了!专为个性化边缘智能打造 | TMC 2024

通信效率提高了两个数量级

Ethan Parker 投稿

量子位 | 公众号 QbitAI

伴随着移动设备的普及与终端数据的爆炸式增长,边缘智能(Edge Intelligence, EI)逐渐成为计算机学科研究领域的前沿。

在这一浪潮中,联邦学习(Federated Learning, FL)作为分布式机器学习的新范式,不断吸引着学术界和产业界的关注。

联邦学习通过多个设备协作训练共享AI模型的同时,避免了私有数据的交换,从而既保障了数据隐私,又实现了模型训练的分布式进行,成为落实边缘智能的关键技术路径。

然而,如何在保持高通信效率的同时,满足终端设备多样个性化需求的模型训练是一个关键性挑战。

最新发表于《IEEE Transactions on Mobile Computing》的论文”FedCache: A Knowledge Cache-driven Federated Learning Architecture for Personalized Edge Intelligence”为这一问题提供了创新性解决方案。

边缘智能中的个性化

边缘智能场景下,模型的协同训练不仅要应对设备硬件差异化的挑战,还需在优化目标、通信效率、隐私保护等方面进行多维度权衡:

- 设备的硬件资源和用户使用习惯各异,需要部署既能满足个性化任务目标又能适应硬件规模的模型。

- 通信能力的局限性和对隐私的重视要求在协作训练中最小化通信成本,并且严格禁止私有数据的共享。

- 设备连接的不稳定性决定了协同过程中不适合采用同步的通信方式

超越主流架构的FedCache

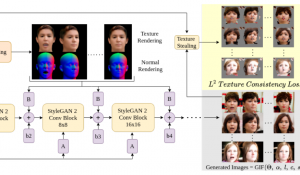

FedCache是一种缓存驱动的联邦学习架构,旨在为个性化边缘智能(Personalized Edge Intelligence)提供强有力的支撑。FedCache通过在服务端维护一个知识缓存,用于捕获与每个私有样本关联的最新知识,并使用知识缓存驱动的个性化蒸馏技术进行终端设备模型的训练。

在初始化阶段,所有私有样本通过深度预训练的神经网络被编码成哈希值,以便在边缘采用隐私保护的方式判断样本之间的相关度。

在正式训练阶段,终端设备基于本地样本索引迭代地向服务器发送知识请求,从中取用相应的关联性知识,并在设备上开展基于蒸馏的个性化优化。

FedCache的核心在于其独特的服务器端知识缓存机制,该机制利用哈希值管理设备样本的相似性和关联知识,以优化训练过程。

这种独特的设计不仅保护了数据隐私,还避免了设备之间的参数交互,显著降低了通信负担。此外,FedCache允许不同设备的模型架构完全独立,优化目标差异化,且支持异步分布式优化。

实验结果

本文在四个公开数据集上验证了FedCache的性能。

实验结果显示,主流的个性化联邦学习方法相比,FedCache的通信效率提高了两个数量级,同时在模型性能也能达到相当的水平。

FedCache的这些特性不仅展示了其在架构设计上的创新性,也证明了其在实际应用中的巨大潜力。

通过这种缓存驱动的联邦优化方法,FedCache预期引领个性化边缘智能的未来,为分布式AI的实施开辟新的道路。

论文地址:https://ieeexplore.ieee.org/document/10420495

代码链接:https://github.com/wuzhiyuan2000/FedCache

- 一次示范就能终身掌握!让手机AI轻松搞定复杂操作丨浙大&vivo出品2025-05-01

- 又一开源AI神器!将机器学习论文自动转为可运行代码库2025-05-01

- AI卧底美国贴吧4个月“洗脑”100+用户无人察觉,苏黎世大学秘密实验引争议,马斯克惊呼2025-04-30

- 全网首测!Qwen3 vs Deepseek-R1数据分析哪家强?2025-04-30