小鹏公然AI“造假”,啧啧啧

视频里可塞任何物体

金磊 发自 凹非寺

量子位 | 公众号 QbitAI

家人们,我们先来看一段视频,你能否发现其中有什么异样?

如果说,在这段视频里,有一个物件是假的,是被合成进去的,你能发现吗?

不卖关子,现在就来揭晓答案。

“造假”的物体,正是这个出现在不该出现位置的红绿灯。

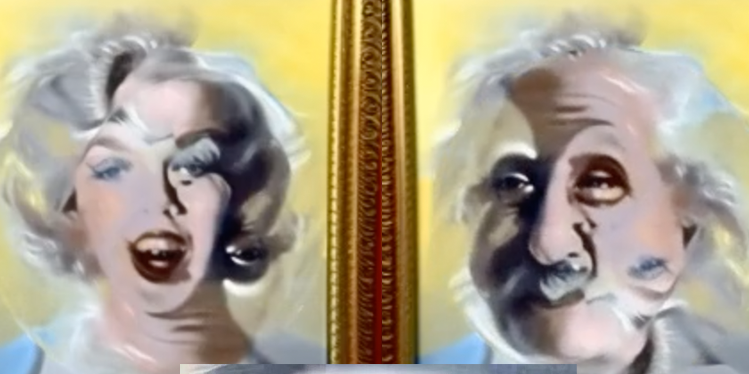

我们再来玩一把“大家来找茬”,请看题目:

答案是:放在置物架上的这个设备。

这就是来自小鹏汽车最新的一项研究——Anything in Any Scene。

主打一个往真实环境里毫无违和感地“塞”进去任何东西。

并且研究团队给予这个通用框架的评价是:

它的应用远远超出了视频数据增强的范围,在虚拟现实、视频编辑和其他各种以视频为中心的应用中显示出巨大的潜力。

甚至有网友在看完效果之后直呼:

再见了视频证据~这个技术插入视频的物体可以保持与原始素材相同的真实感。

那么这项AI技术更多效果如何,我们继续往下看。

Anything in Any Scene

先从室外场景来看下效果。

在视频中合成某个物体的时候,往往不逼真的原因,可以总结为位置放置错误、无阴影、无HDR和无样式迁移等原因。

正如下面几个错误案例所示:

而小鹏团队的效果,是这样的:

相比刚才缺少各种因素的情况而言,效果显然是相对逼真的。

再与其它已有的算法和框架做比较,例如DoveNet、StyTR2和PHDiffusion,它们在室外场景中合成物体的效果是这样的:

小鹏的Anything in Any Scene从效果上来看,依旧是相对更为逼真。

同样的,在室内环境中,不论是包包还是鞋子,小鹏新AI技术所生成的效果可以说是真假难辨的那种了。

更多的效果展示如下图所示:

除了视觉效果之外,小鹏团队在CODA数据集的原始图像上,将训练的YOLOX模型的性能与Anything in Any Scene框架在原始和增强图像的组合上训练时的性能进行了比较。

从整体精度上来看也有了不小的提高。

怎么做到的?

从此次提出的框架上来看,Anything in Any Scene主要由三个关键部分组成。

首先是物体放置和稳定化的过程。

团队先确定相机在场景中的世界坐标系位置,并将其作为物体插入的参考点;使用相机的内参矩阵和姿态(旋转矩阵和位移向量)将世界坐标系中的点投影到像素坐标系中,以确定物体在视频帧中的放置位置。

为了避免与场景中其他物体的遮挡,团队还使用语义分割模型估计每个帧的分割掩模,并确保物体放置在未被遮挡的区域。

在物体稳定化方面,团队在连续帧之间估计光流,以跟踪物体的运动轨迹;并通过优化相机姿态(旋转矩阵和位移向量),最小化物体在连续帧中的3D到2D投影误差,确保物体在视频中的稳定运动。

其次,是光照估计和阴影生成。

针对HDR全景图像重建,团队使用图像修复网络推断全景视图的光照分布,然后通过天空HDR重建网络将全景图像转换为HDR图像;并结合使用GAN训练编码器-解码器网络来模拟太阳和天空的亮度分布。

在环境HDR图像重建方面,研究人员则是收集了场景的多视角LDR图像,并通过现有模型恢复为HDR图像,以学习连续曝光值表示。

在物体阴影生成上,团队则是使用3D图形应用(如Vulkan)和光线追踪技术,根据估计的主要光源位置生成插入物体的阴影。

最后的步骤,则是照片风格迁移。

框架对插入物体的外观进行微调,使其风格与背景视频完美融合,进一步提升了视频的逼真度。

这便是小鹏Anything in Any Scene在真实环境中生成物体较为逼真的原因了。

而与小鹏此次研究类似的效果,其实早在之前便有了许多工作。

例如名为GAIA-1的多模态生成式世界模型,便可以从头到脚的打造逼真的自动驾驶视频:

这里的每一帧都是由AI生成,甚至就连不同的路况和天气等等,都是可以做到以假乱真。

就连LeCun看了都惊叹不已:

不过这些AI效果虽真实,但也有网友提出了担忧之处,那便是网上虚假、生成的信息越发的逼真;因此,以后辨别信息的真假需要更加警惕。

目前,这个项目已经在GitHub中开源,感兴趣的小伙伴可以了解一下了~

参考链接:

[1]https://anythinginanyscene.github.io/

[2]https://arxiv.org/abs/2401.17509

- 智能车速度刷新:仅10个月,首个纯端侧大模型上车量产!2025-04-24

- 百度阮瑜:大模型应用落地正从简单高容错向复杂低容错场景延伸|中国AIGC产业峰会2025-04-24

- 全球首个无限时长视频生成!新扩散模型引爆万亿市场,电影级理解,全面开源2025-04-21

- 教育信创到底怎么选?能做到”无感切换”的只有C862025-04-21