商汤绝影王晓刚:未来一两年是智能汽车突破关键期,大模型是基础 | MEET2024

大模型让“座舱大脑”成为可能

编辑部 整理自 MEET2024

量子位 | 公众号 QbitAI

“未来一到两年,智能汽车其实处在一个关键突破的时间点。”

在MEET 2024智能未来大会现场,商汤联合创始人、首席科学家、绝影智能汽车事业群总裁王晓刚这样讲道。

他还指明了具体会出现的三件事情:

一是端到端数据驱动的自动驾驶;

二是以大模型为核心、为基础的座舱大脑的出现;

三是驾舱融合,所有座舱和驾驶的体验在同一颗芯片、同一个域控上实现,大幅降低成本和算力。

而所有这些都是以大模型为基础的。

商汤科技从2018年开始布局大模型,而商汤绝影则是商汤旗下的智能汽车业务板块,坚持驾、舱、云三位一体的发展策略。

在大会上,王晓刚以回顾过去十几年AI的发展引入,探讨了通用人工智能和大模型给智能汽车带来的技术突破和未来发展。

为了完整体现王晓刚关于大模型赋能智能汽车的思考,量子位在不改变原意的基础上,对他的演讲内容进行了编辑整理。

关于MEET智能未来大会:MEET大会是由量子位主办的智能科技领域顶级商业峰会,致力于探讨前沿科技技术的落地与行业应用。今年共有数十家主流媒体及直播平台报道直播了MEET2024大会,吸引了超过300万行业用户线上参会,全网总曝光量累积超过2000万。

演讲要点

- 通用人工智能大模型的发展,软硬件基础设施的能力必不可少。

- 能在强大的基础设施上不断高效探索,才能够在短时间内积累大量的know-how,才能够训练好千亿规模甚至更大规模的模型。

- 大模型的出现让打造智能座舱的大脑成为可能,通过一个大模型可以调动舱内的各种APP和硬件设备。

- 未来一到两年,智能汽车处在一个关键突破点。

(以下为王晓刚演讲分享全文)

软硬件基础设施必不可少

今天分享一下通用人工智能和大模型给我们智能汽车带来的技术突破和未来发展的机遇。

回顾过去十几年人工智能的发展,2012年人工智能的突破使机器人脸识别超过肉眼识别率,带起了一系列人工智能在工业上的落地和应用。

但是它的问题是针对不同的任务,需要定制化的模型定制解决方案。

在过去的几年里,商汤科技输出的商业化模型超过3万个,一方面我们看到AI广泛的被应用,另一方面也看到研发成本大、研发周期较长。

去年年底ChatGPT的出现,带来了人工智能新的范式,基于一个或者几个非常强大的大模型能够解决众多开放式的任务,给人工智能的规模化产业应用打开了一个新的道路。

过去几十年人工智能的发展都是解决小样本的问题,当时数据量非常小。我们用到的这些计算资源、模型的规模也都是比较小的。

但是2012年随着深度学习的出现,我们看到算力得到了大幅的增长,包括后面出现了Transformer,还有大模型的出现,算力更是增长到了更大规模。

在智能汽车领域,我们的行业标杆是特斯拉。

今天特斯拉有14000块GPU,到明年,它的算力要增加10万块。这样一个增长规模背后,强大的算力支撑给我们未来行业发展指引了一些方向,也是今天国内很多主机厂难以匹敌的投入。

商汤从2018年开始布局大模型,在上海临港投入了50多亿,建造了一个人工智能数据中心。

当时很多人都奇怪,作为一个做算法的公司,为什么在基础设施的建设上有这样大的投入?

今天,我们看到通用人工智能大模型的发展,软硬件基础设施的能力是必不可少的。

我们目前有3万块高端GPU,包括6500P的算力,实际上到明年这个算力还会大规模地增加,预计增加到16500P的算力。

我们谈到的大模型,包括感知的模型,各种生成式的模型,文生图多模态的模型,还有决策智能的各种模型,所有的这些,都是建立在强大的软硬件基础设施系统能力的之上。

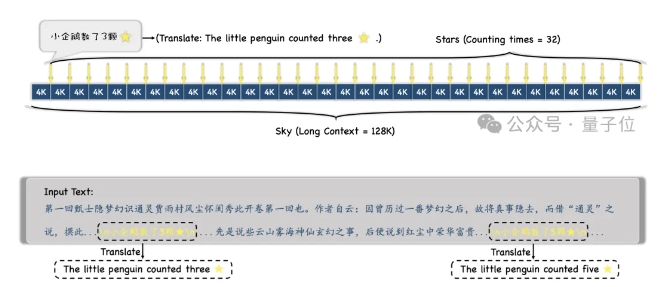

我们做了一些统计,在过去的几个月里面,像百亿规模参数级的模型,训练都超过了100次,10亿规模超过1000次。

正是经过在强大基础设施的基础上不断进行高效探索,才能够在短时间内积累大量的know-how,才能够训练好千亿规模甚至更大规模的模型。

而且这些模型之间也有很大的关联度,比如多模态的模型是在语言模型,还有视觉等模型的基础上发展起来的。

我们的决策智能的模型也是利用了语言模型的强大的推理能力。

大模型赋能智能驾驶

在智能汽车里面有很多应用例子,比如自动驾驶从高速到城区有很多复杂的场景。

基于大模型可以打破以前我们对于手写规则的依赖,可以针对场景进行一些复杂地推理。

例如左边给了这样一张照片,问“去黄石东路应该怎么走?”,模型会告诉我们今天的天气状况、前方行驶的车辆、路标、根据路牌的指示应该走左侧车道。

在右边这幅图里面,我们看到在一个复杂路口的场景中,问“白色的小轿车应该做出怎样的决策?”。

我们的大模型也可以根据图像对路口交通状况进行分析,而且能够看到这里面有救护车出现,也知道应该做出怎样的避让。

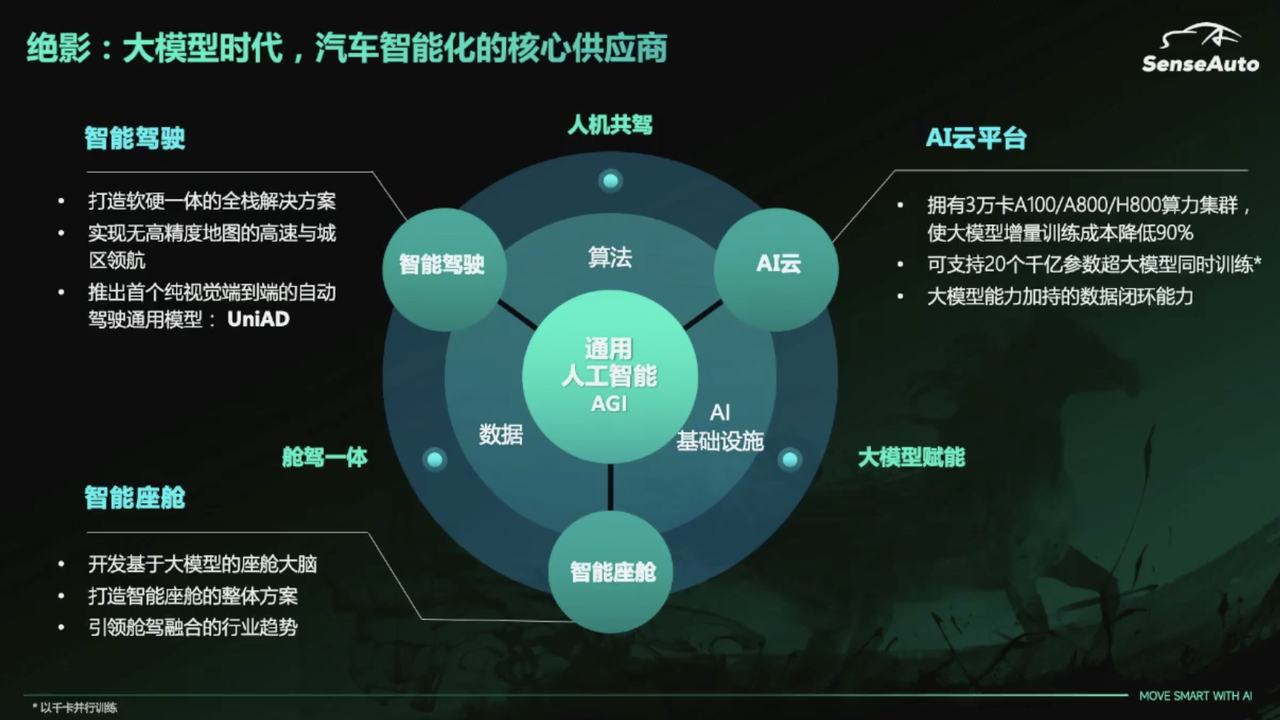

绝影是商汤智能汽车的业务板块。我们在智能汽车的时代作为大模型和通用智能的核心供应商,主要是聚焦智能驾驶、智能座舱和AI云服务。

在智能驾驶方面,提供软硬一体的智能驾驶的解决方案,也离不开大模型。

因为未来智能驾驶的发展趋势更多是基于视觉,而且是通过一个大模型、神经网络,端到端地实现自动驾驶的系统,之前我们也做出了UniAD的工作。

在智能座舱方面,现有的智能座舱是由各个AI的供应商去提供一些单点AI的功能,主机厂基于一些规则把这些功能组织起来,形成一些产品或者一些方案。

大模型的出现使我们有可能打造出智能座舱的大脑,通过一个大模型可以调动舱内的各种APP和硬件设备。

这其中也依赖了强大的AI的云服务。今天很多主机厂他们也希望能够拥有AI基础设施,包括形成数据的闭环。

从大量的量产汽车里面采集海量的数据,快速高效低成本地针对这些数据进行分析、处理和标注,这里面也体现出大模型的优势。

我们会基于大模型建立一整套研发体系,从大模型的训练、低成本的部署,包括模型层,还有数据生产的管线。在此之上,这些连接层里面各种Function Call、数据模型的技术支撑驾驶和座舱,包括车路协同的应用。

在智能座舱里面打造座舱的大脑,座舱大脑的核心也是基于语言模型的能力控制舱里面各种软硬件。车内和车外有各种各样的传感器,通过多模态的模型就能够全方位的感知环境和乘客,包括驾驶员的需求。

我们有记忆模块,对乘客和驾驶员有长短期的记忆,通过外挂知识库跟大模型的结合,进行知识融合,就能够形成千人千面的服务。

AIGC也能够实现AI虚拟的助手,提供各种拟人化的服务,还有通过大模型进行各种智能控制。

下面给大家看到的是基于大模型在智能座舱里面开发的一系列智能座舱的应用和产品,包括隔空绘画、内容生成、AI说明书、健康问诊、旅游规划等等,能够把我们在座舱的智能化体验提升到新的层次。

未来是用大模型实现端到端自动驾驶

我们看到,智能驾驶未来发展的趋势,第一是往纯视觉的方向发展。

今天智能驾驶系统还是依赖各种传感器,在硬件上更多依赖摄像头,大幅降低硬件的成本。

智能驾驶系统实际上有很多模块,有感知、融合、预测、定位、决策、规控,现在只有感知这一部分用的是AI、神经网络,其它的很多都是基于手写规则。

当我们自动驾驶覆盖的场景从相对来说比较简单的高速领航到更加复杂的城区的时候,场景的复杂度大幅增加,这时候依靠手写的规则解决各种Corner case,更多需要依赖数据驱动。

背后通过一个模型将感知、融合、定位、决策、规控,所有的模块串联起来,用数据驱动覆盖尽可能多的场景,这也是行业里面能够看到的未来自动驾驶发展的路线。

今年9月份,特斯拉宣布未来量产的自动驾驶的路线就是端到端的基于大模型的解决方案。

去年年底,我们提出了UniAD,用一个神经网络实现预处理、感知、预测、决策,各个模块的连通,这项工作还获得了今年CVPR最佳论文奖。

在这项工作中我们可以看到,通过网络数据驱动,可以使里面各个模块的性能都得到大幅的提升,未来低成本视觉的方案、摆脱对高精度地图的依赖成为了可能。

而且我们的多模块大模型,更多的语言输出也能够给我们自动驾驶的各种决策提出更多的语言解释,现在自动驾驶就不再是一个黑盒子,做出每一个决策能够给我们推理和逻辑。

还能够跟人对话,通过语音控制自动驾驶的各种行为。

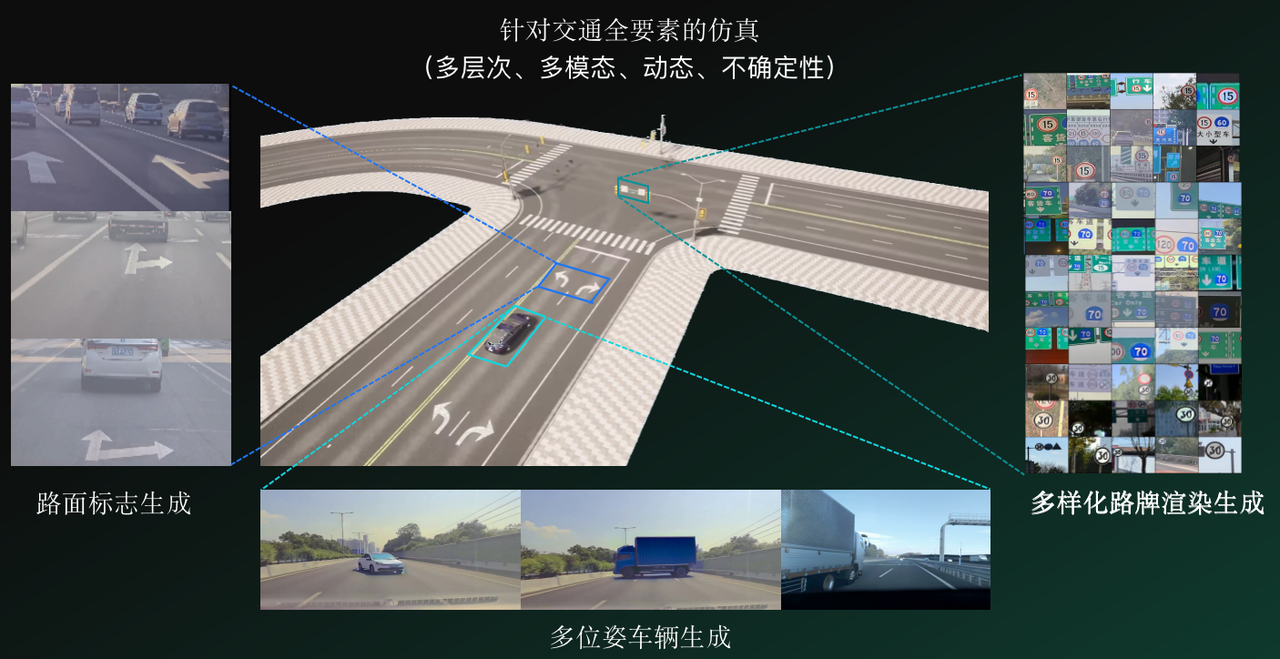

我们也能建造世界模型,通过大模型生成各种逼真的自动驾驶仿真数据,实现自动驾驶的数据驱动和端到端的训练。

最后我们可以看到,未来一到两年里,智能汽车其实是处在一个关键突破的时间点,实际上有三件事:

一是端到端数据驱动的自动驾驶;

二是以大模型为核心、为基础的座舱大脑的出现;

三是驾舱融合,所有座舱和驾驶的体验在同一颗芯片,同一个域控上实现,大幅降低成本和算力,在产品级实现更好的融合,实现更好的智能驾驶和座舱的智能化的体验。

所有这些也都是以大模型为基础的。

我们非常期待未来智能驾驶能成为安全可靠的司机,智能座舱能成为懂你的温馨的好管家,实现更好的人机共驾。

- 阿里云造“Agent工厂”,百炼MCP服务上线,无需代码5分钟建Agent2025-04-09

- 又一上海人形机器人加入开源!全套图纸+代码,来自傅利叶2025-04-11

- 周光:VLA模型将成智能驾驶体验颠覆性拐点2025-03-31

- 摸DeepSeek过河也得自身硬! 想开后的文小言,真香!2025-03-31