代码能力超越GPT-4,这个模型登顶Big Code排行榜,YC创始人点赞

实测在此

克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

一款号称代码能力超越GPT-4的模型,引发了不少网友的关注。

准确率比GPT-4高出超过10%,速度却接近GPT-3.5,而且窗口长度也更长。

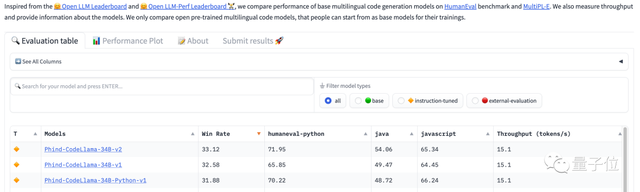

据开发者描述,他们的模型取得了74.7%的Pass@1通过率,超过了原始GPT-4的67%,登上了Big Code榜首。

这个模型名叫Phind,和以其为基础的面向开发者的AI搜索工具同名。

它是由开发团队在CodeLlama-34B的基础之上微调得到的。

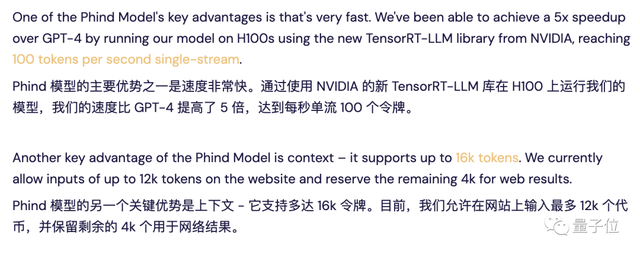

Phind利用TensorRT-LLM在H100上可以跑出每秒100个token的速度,是GPT-4的5倍。

此外,Phind的上下文长度达到了16k,其中12k可供用户输入,另外4k保留给检索结果中的文本。

针对这个产品,网友们议论纷纷,结果是喜忧参半:

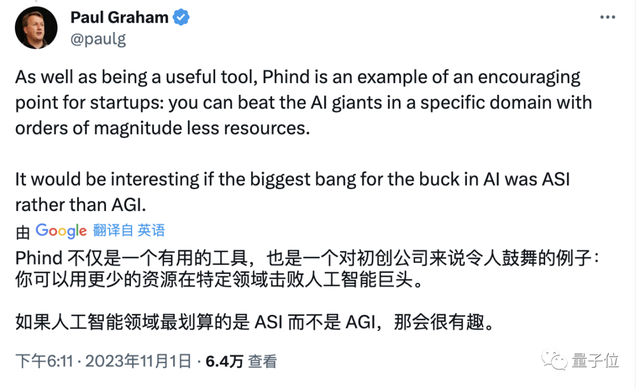

支持的人,如著名创业投资公司YCombinator创始人Paul Graham表示,Phind可以让人们用更少的资源和大厂抗衡。

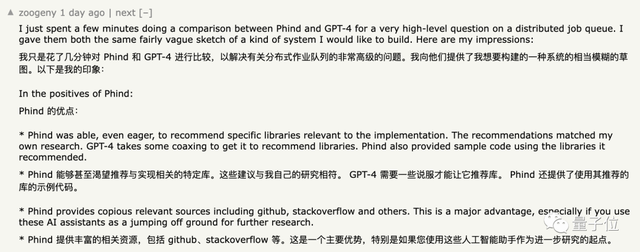

也有网友具体列出了Phind的优点:

不认可Phind的网友则说,自己之前用GPT-4写的代码,Phind写不出来:

更是有人吐槽说,GPT“每天都在被打败”,但是从来没被超越过。

有意思的是,在Phind应用当中,自研模型又被称作“fast model”,而“best model”仍然是GPT-4。

(虽然没明说,但是GPT-4和best model的剩余可用次数是同步变化的)

所以,这个号称“击败了GPT-4”的模型到底是不是真的那么好用,我们进行了一番实测。

Phind vs GPT-4

正式开始之前,先来说说对Phind的第一印象。

它的界面十分简洁,主要就是一个搜索框,而且不需要登录就能无限量使用。

左下角有一个Pair Programmer的开关,直观上的区别就是开启之后回答界面更侧重对话,不开启的话则更像搜索引擎。

此外,还可以从自研模型和GPT-4中选择,GPT-4则需要登录,而且每天只能用10次。

接下来就是和GPT-4进行的对比测试,GPT-4没有开启代码解释器。

首先还是从LeetCode题目开始测起,Prompt就是是原问题加上下面这段话:

请用Python写一段代码解决这个问题,给出通用的解法,不需要设定参数值,代码需要以如下内容开头:

(LeetCode页面中给出的起始片段)

为了防止Phind通过检索来“作弊”,我们还在Phind的Prompt结尾加入了这句话:

不要检索任何信息,靠你自己的能力创建代码

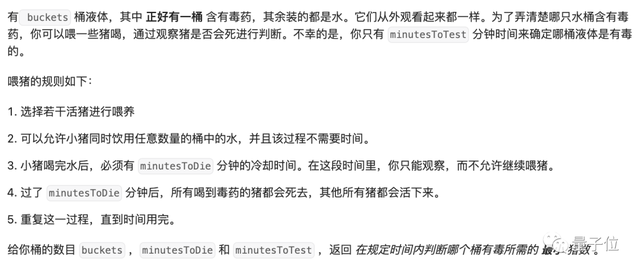

第一题在LeetCode中被归为组合数学问题,难度为困难,通过率67.1%。

Phind给出了这样的代码和解释,经过测试,20条测试数据中有19项正确。

出错的是这一条,这里的输出结果应该是3,但Phind给出的程序运行结果是4。

我们试着反馈给Phind,看它能不能找出错误的原因,结果分析一番之后给出了新的代码,并通过了测试。

而GPT-4这边,则是一次性通过。

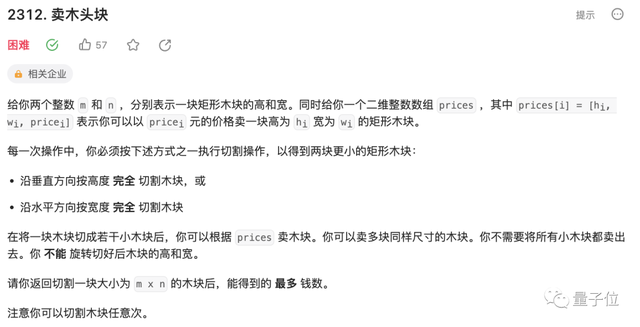

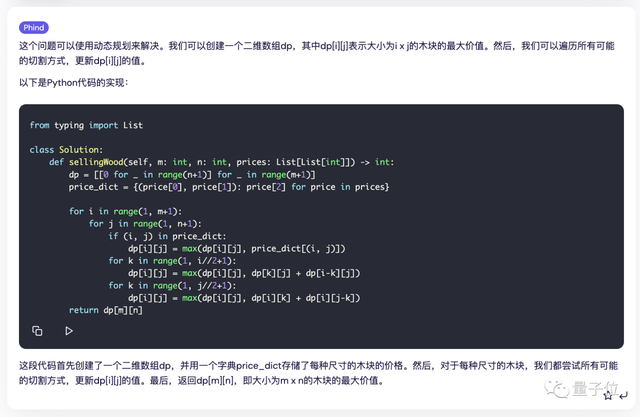

进入下一题,这道题目涉及到了动态规划,通过率为53.9%。

这次Phind和GPT-4都是以一次通过。

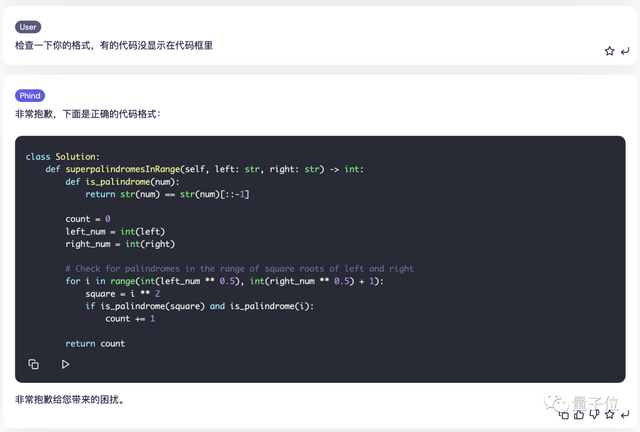

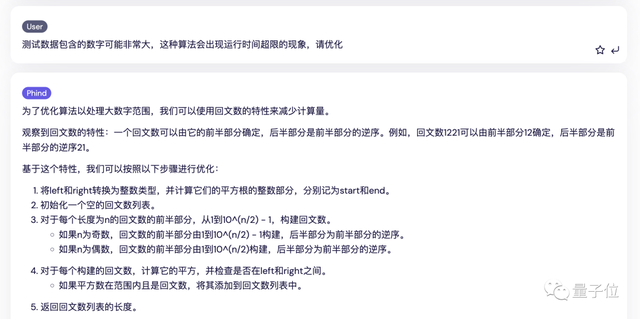

第三道题目的通过率只有约30%,但它的难度可能在于用来判题的测试数据太庞大了。

Phind给出的这段代码就在通过前12组测试数据之后出现了运行时间超限的现象。

我们让它试着进行优化,结果这次直接是算不对了。

而GPT-4则轻松解决,不过在解释说明部分有些错误,因为超级回文数的概念中的描述是“回文数的平方”而不是“平方是回文数”。

三道LeetCode题目测试下来,Phind以一平两负的成绩输给了GPT-4。

但需要说明的是,这里我们为了测试模型本身表现,通过提示词关闭了Phind的检索功能,但从实用角度出发,如果保留搜索,Phind还是能很好地解决这些问题的。

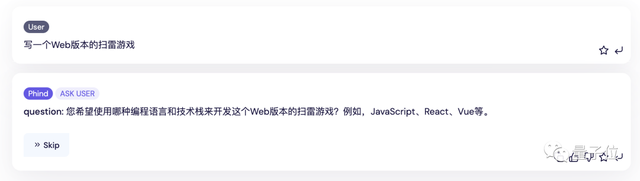

接着,我们又测试了一下他们的实际开发能力,这次的题目是扫雷游戏。

Phind会问我们有没有什么特殊要求,这里我们直接点跳过。

然后Phind会对任务进行拆解,对每个子任务又分别进行检索。

这时的代码也是分段给出的,有趣的是,在生成过程中,Phind会使用不同来源中的代码。

然后我们让Phind给出完整代码,并通过链接的第三方平台直接运行。

结果呢,我们一进去就看到程序已经非常“贴心”地把雷的位置清楚地标注好了。

不过这次,GPT-4的代码更加离谱一些,运行出来是这样的:

虽然都没做对,但硬要比较的话,这一轮,Phind略胜一筹。

一路测试下来,很难判断它们孰优孰劣,但考虑到搜索能力,以及免费免登录的特性,Phind还是可圈可点的。

参考链接:

https://www.phind.com/blog/phind-model-beats-gpt4-fast

- Claude网页版接入MCP!10款应用一键调用,开发者30分钟可创建新集成2025-05-02

- 1450亿!马斯克xAI与X合并后再寻资金,将成史上第二大初创企业单轮融资2025-04-27

- 挤爆字节服务器的Agent到底啥水平?一手实测来了2025-04-23

- 电视装了智能体,只凭台词就能找到剧集了2025-04-24