超大杯Stable Diffusion免费来袭!「最强文生图开放模型」,提示词也更简单

免费版一天能画400张

明敏 克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

Stable Diffusion最强版本,来了!

刚刚,SDXL 1.0正式发布,可免费在线试玩。

效果上,无论是以假乱真的写实大片:

超现实的熊猫喝啤酒:

还是赛博朋克漫画,都非常nice~

Stability AI表示,SDXL 1.0能生成更加鲜明准确的色彩,在对比度、光线和阴影方面做了增强,可生成100万像素的图像(1024×1024)。

而且还支持在网页上直接对生成图像进行后期编辑。

(有一股和Midjourney、Firefly打擂台的味儿了)

网友们已经按捺不住上手试玩了~

和基础Stable Diffusion相比,SDXL 1.0生成结果更加准确和逼真。

而且官方表示,提示词也能比之前更简单了。

这是因为SDXL 1.0的基础模型参数量达到了35亿,理解能力更强。

对比基础版Stable Diffusion,参数量只有10亿左右。

由此,SDXL 1.0也成为当前最大规模的开放图像模型之一。官方甚至直接说这就是世界上最好的开放图像模型。

话不多说,我们来上手体验了~

把马斯克印在青花瓷上

SDXL 1.0在操作上很便捷,直接输入prompt即可,还能从下面勾选风格、尺寸参数等。

一次生成默认是出4张图,如果不满意还可以点下方“加号”让它继续画。

官方介绍说,现在让SDXL 1.0生成大作,无需再加入“杰作”这种提示词了。

让它生成一幅日漫风格的图像,画风非常贴合,而且在光影的处理上也更加自然了。

1990s anime low resolution screengrab couple walking away in street at night

或者是一幅风景照?也能以假乱真了。

甚至是让马斯克站在中式庭院里,抬头斜望着天空……

Elon Musk in an ancient Chinese palace

或者是把苹果收购了?

在「WWDC」上,他举着全新款iPhone向人们展示,身边还围满了记者和粉丝(doge)。

Elon Musk releasing new iPhone at WWDC

除了这些老马的洋葱新闻之外,绘画风格的作品效果也不错。

左边的是齐白石水墨风格,而右边是一幅漫画。

左:Elon Musk delivering a speech, ink painting, Qi Baishi style

右:Elon Musk comic

除了绘画,也可以把老马放进我们的元青花。

Elon musk in the shape of Yuan Dynasty Blue and White Porcelain

上面展示的这些「老马的故事」,用的prompt都比较简单。

但从效果并没有因为提示词简单而拉胯,这也与官方的说法相印证。

不过我们还是想看看,如果用更加复杂精致的prompt,会是什么样子?

我们找到了Midjourney创作的一张老马在苏联担任汽修工人的珍贵照片,重新喂给MJ,让它生成个prompt。

MJ生成了下面这样的prompt,我们就用它来测试SDXL:

Elon Musk(这里MJ生成的是a man) standing in a workroom, in the style of industrial machinery aesthetics, deutscher werkbund, uniformly staged images, soviet, light indigo and dark bronze, new american color photography, detailed facial features

风格完全符合我们的预期,细节也还不错。

再来一个复杂prompt的图作为收尾,同样是MJ根据此前的作品生成后喂给SDXL。

elon musk eating food with chopsticks, in the style of peter coulson, cross-processing/processed, pinhole photography, herb trimpe, james tissot, transavanguardia, spot metering

左边是SDXL的作品,右边是MJ的原版,大家可以对比一下。

提示词同样支持中文,不过似乎会在给出结果中倾向于国风,准确性可能也会受到影响。

比如输入“一只老虎在海边”后,意外给出了一个国风妹子。

效果大家都已经看到了,那么SDXL生成图片的速度如何呢?

对于免费用户来说,时间主要花费在排队上了,不过也不会等待太久。

在5.5秒的时间内,排队人数从160减少到了99。

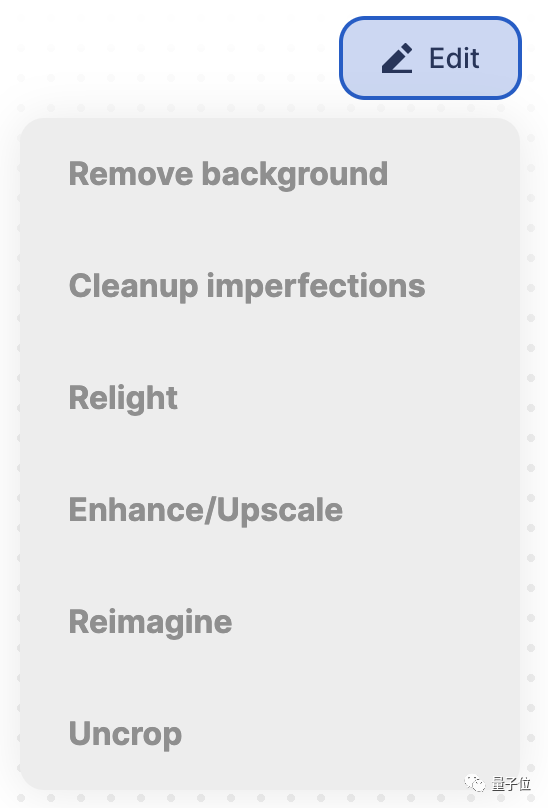

除了生成图像外,SDXL还提供了很多后期编辑功能。

具体来说,包括去除背景、细节处理、画幅扩增等等。

这些功能是SDXL所在的Clipdrop平台上已有的,而SDXL可以一键将生成的图片传入对应模块。

这里我们选择背景消除功能展示一下,可以看出边缘的细节几乎没有什么破绽。

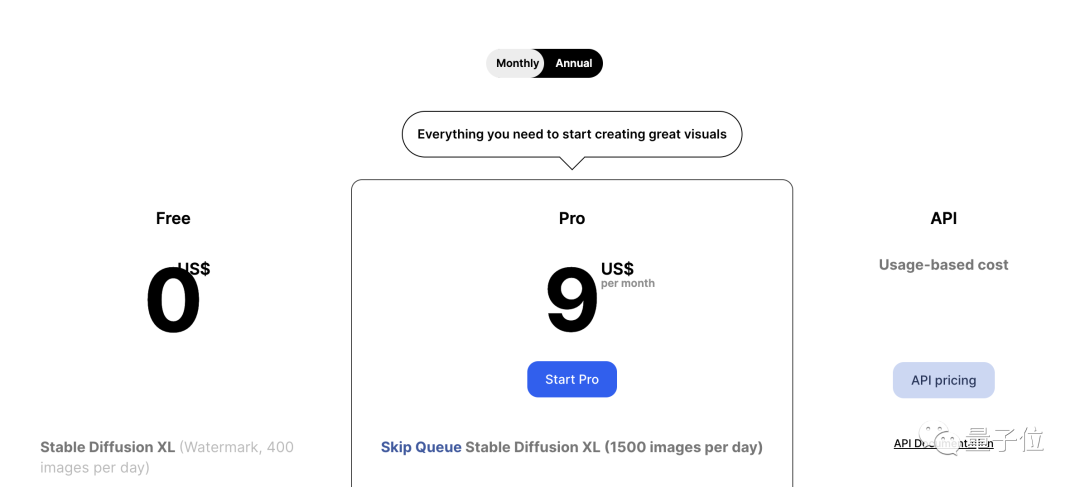

目前,SDXL的免费使用额度还是比较高的,登录后每个账户每天可生成400张(需要排队)。

月付的价格是9美元每月,年付则相当于7美元(约50元人民币)每月,包含了1500张每天的SDXL额度,且无需排队。

不过不同区域的价格似乎也有所区别,比如阿根廷的年付价格平摊到每月是742比索(约合19.4元人民币或2.7美元)。

此外,由于付费版本实际上是Clipdrop平台的Pro订阅,所以也包含了该平台的其他功能。

除了Pro账户,还有API版本可供开发者使用(可以访问Stability AI、Amazon等平台)。

开放图像模型中的“最大杯”

在最新博客中,Stability AI介绍了SDXL 1.0的更多技术细节。

首先,模型在规模和架构上都有了新突破。

它创新性地使用了一个基础模型(base model)+一个细化模型(refiner model)。

二者的参数规模分别为35亿和66亿。

这也使得SDXL 1.0成为目前规模最大的开放图像模型之一。

Stability AI创始人莫斯塔克(Emad Mostaque)表示,更大规模的参数量能让模型理解更多概念,教会它更深层次的东西。

同时在SDXL 0.9版本还进行了RLHF强化。

这也是为什么现在SDXL 1.0支持短提示词,而且能分清红场(the Red Square)和一个红色的广场(a Red Square)。

在具体合成过程中,第一步,基础模型产生有噪声的latent,然后由细化模型进行去噪。

其中基础模型也可以作为独立模块使用。

这两种模型结合能生成质量更好的图像,且不需要消耗更多计算资源。

官方介绍SDXL 1.0可以运行在8GB VRAM的消费级GPU上,或者是云端。

除此之外,SDXL 1.0在微调也有了提升,可以生成自定义LoRAs或者checkpoints。

Stability AI团队现在也正在构建新一代可用于特定任务的结构、风格和组合控件,其中T2I/ControlNet专门用于SDXL。

不过目前这些功能还处于beta测试阶段,后续可以关注官方更新。

总结来说,文生图都是一个逐渐迭代的过程,SDXL 1.0的目标就是让这个过程更加简单。

莫斯塔克表示,现在只需要5-10张图片,就能快速微调模型。

从用户反馈中也能看到,相较于Stable Diffusion,SDXL 1.0更能让大家满意。

实际上,从今年4月以来,Stability AI就发布了SDXL最早的测试版。

6月份开始进行内测,前段时间发布了0.9版本,当时就预告了会在7月发布一个开放版本,即最新的1.0版本。目前相关代码权重已经发布在GitHub上。

而且Stability AI机器学习负责人表示,相较于SDXL 0.9,1.0版本降低了对算力的需求。

感兴趣的童鞋快去试玩吧~

试玩入口:

https://clipdrop.co/stable-diffusion

GitHub:

https://github.com/Stability-AI/generative-models

参考链接:

[1]https://stability.ai/blog/stable-diffusion-sdxl-1-announcement

[2]https://venturebeat.com/ai/stability-ai-levels-up-image-generation-launch-new-stable-diffusion-base-model/

[3]https://techcrunch.com/2023/07/26/stability-ai-releases-its-latest-image-generating-model-stable-diffusion-xl-1-0/

- Llama 4遭竞技场背刺!实锤用特供版刷榜,2000+对战记录公开2025-04-08

- “AI眼镜的终极功能,是AI+社交” | 对话影目科技创始人2025-04-07

- “充电厂商”为何跨界AI眼镜?对话闪极创始人张波2025-04-07

- 马斯克擎天柱机器人大秀走姿,背后大佬集体现身喊话招人2025-04-03