TensorFlow团队:我们没被抛弃

“将与JAX并肩推动机器学习研究”

鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

终于,谷歌出面回应“TensorFlow遭弃”传闻:

我们将继续致力于将TensorFlow打造为一流机器学习平台,与JAX并肩推动机器学习研究。

这段时间,“JAX取代TensorFlow”这个话题可谓热议不休。

不仅Business Insider等媒体援引内部人士消息,称“谷歌大脑和DeepMind已经普遍放弃TensorFlow,转投JAX”。

连LeCun、fast.ai创始人Jeremy Horward等大咖也纷纷下场围观,表示深度学习框架之间的竞争进入了一个新的阶段。

在TensorFlow因日渐臃肿、学习成本高等问题,越来越受到业界诟病的背景之下,“谷歌抛弃TensorFlow”似乎没什么毛病。

不过,在舆论发酵了一段时间之后,现在,TensorFlow官方团队终于还是出面“辟谣”,发文表示:

我们将继续投资TensorFlow和JAX两个ML框架,以推动数百万用户的研究和应用。

具体详情,一起来看TensorFlow博客写了点啥。

官方:TensorFlow是我们交给工程师的答案

TensorFlow官方在文章中引用了Stack Overflow的最新统计数据。

数据显示,TensorFlow在机器学习领域整体上仍然比PyTorch受欢迎。

另外,TensorFlow目前每月下载量超过1800万次,并在GitHub上拥有16.6万标星。

相比之下,PyTorch的标星数是5.7万,JAX的标星数是1.91万。

官方团队强调,在谷歌内部,TensorFlow几乎为所有AI生产工作流程提供支持,包括搜索、广告、YouTube、邮箱、地图、Play、地图等。

而苹果、网飞、腾讯、Uber等等知名企业,也都在使用TensorFlow支持他们的生产系统。

至于为啥现在谷歌重视JAX,原因则是:

近年来,我们发现,单一通用框架往往无法适用于所有场景——尤其是生产和前沿研究的需求经常发生冲突。

因此,我们创建了JAX,一个用于分布式数值计算的简单API。

JAX在前沿研究领域有着非常出色的表现:达到了新的并行规模,推进了新的算法和框架,还发展出了新的编译器和系统。

官方还举例说,AlphaFold和Imagen都已经验证了JAX的价值。

相比之下,TensorFlow则是“我们满足应用机器学习开发人员需求的答案”。

也就是说,TensorFlow会更侧重满足工程师们在任意规模和任意平台上,构建并部署可靠、稳定、高性能的机器学习系统的需求。

此外,谷歌官方在JAX和TensorFlow互通方面也做了不少工作。

比如通过jax2tf,研究人员就能把JAX模型放在TensorFlow上投入生产。

最后,官方提到:

展望未来,我们将继续致力于将TensorFlow打造为一流机器学习平台,与JAX并肩推动机器学习研究。

我们将继续投入资源发展这两个机器学习框架,以推动数百万用户的研究和应用。

还顺带打了一波招聘广告(手动狗头)。

关于JAX

2018年,JAX诞生于谷歌大脑的一个三人小团队之手。

诞生之初,其瞄准的就是高性能数值计算和机器学习研究。

JAX可以看作是支持GPU、TPU等加速器加速、支持自动微分的Numpy变体。

简单来说,可以这样理解:当你想处理一些对算力要求很高的问题时,通过JAX,你可以将复杂的问题快速分散到多个TPU上。

目前,谷歌大脑的Trax、Flax、Jax-md,以及DeepMind的神经网络库Haiku和强化学习库RLax等,都是基于JAX构建的。

值得一提的是,JAX诞生之际,正是PyTorch在学术界强烈冲击TensorFlow之时。

加州大学伯克利分校旗下研究机构RISELab的数据显示:

2019年1月到6月底,在arXiv上发表的论文中,提及TensorFlow和PyTorch的数量相差无几,PyTorch仅稍稍落后。

不过在增长速度方面,与2018年1-6月相比,PyTorch的“份额”增长了194%。TensorFlow则只增长了23%。

参考链接:

https://blog.tensorflow.org/2022/06/%20bringing-machine-learning-to-every-developers-toolbox.html?m=1

- 粉笔CTO:大模型打破教育「不可能三角」,因材施教真正成为可能|中国AIGC产业峰会2025-04-18

- GPT-4.1淘汰了4.5!全系列百万上下文,主打一个性价比2025-04-15

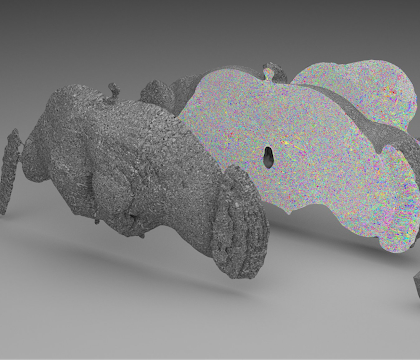

- SOTA自动绑骨开源框架来了!3D版DeepSeek开源月大礼包持续开箱ing2025-04-11

- 语音界Deepseek!百度最新跨模态端到端语音交互,成本最高降90%2025-04-02