大佬抨击ICML审稿太随意:LeCun三篇全没中,马毅以后再也不投了

新的两阶段审稿机制,引发的问题比解决的多

梦晨 发自 凹非寺

量子位 | 公众号 QbitAI

顶会ICML结果一出,掀起一片混乱。

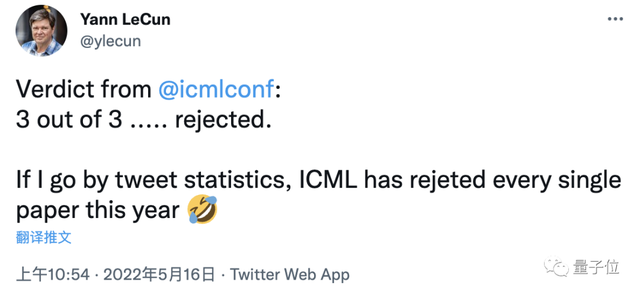

LeCun分享自己的“战果”:三篇全没中,推特上就没看到有谁中了的。

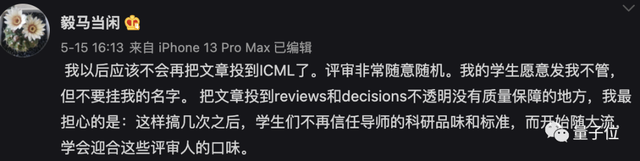

UC伯克利教授马毅也表示今后不再投ICML了,评审非常随意、不透明,最大的担心是学生开始迎合评审人的口味。

以往学术会议放榜之时,往往呈现“几家欢喜几家愁”的局面。

今年愁的一方却格外的多,画风也格外离谱。

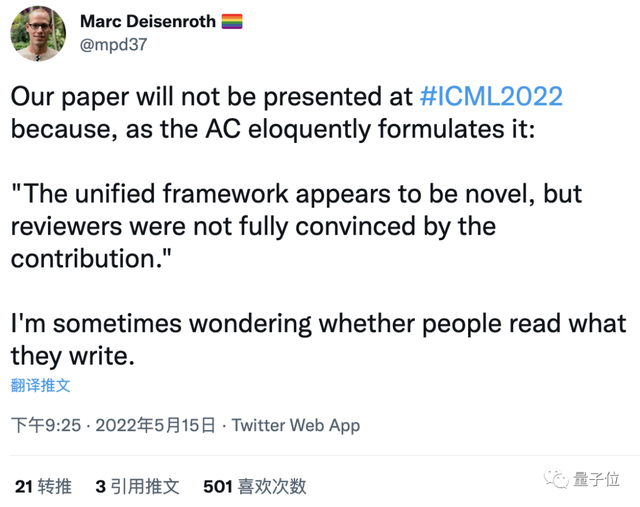

有人收到的的说法是:

“统一框架看起来很新颖,但审稿人并未完全被这一贡献说服”。

前后矛盾,让他开始怀疑这人有没有读过自己写出来的东西。

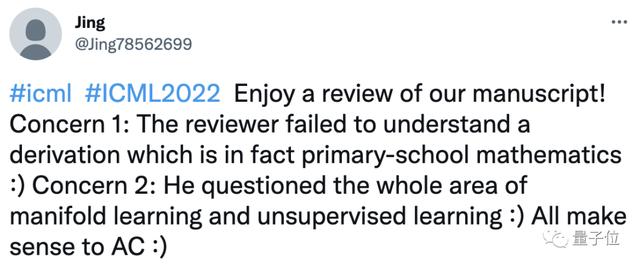

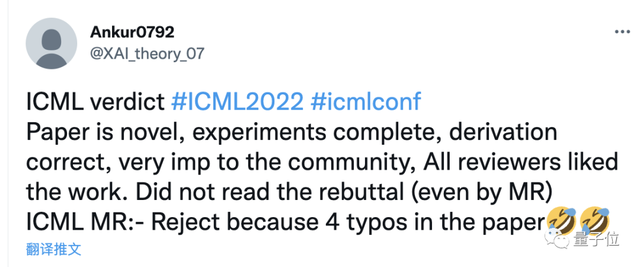

还有人挂出自己收到这样的结果:

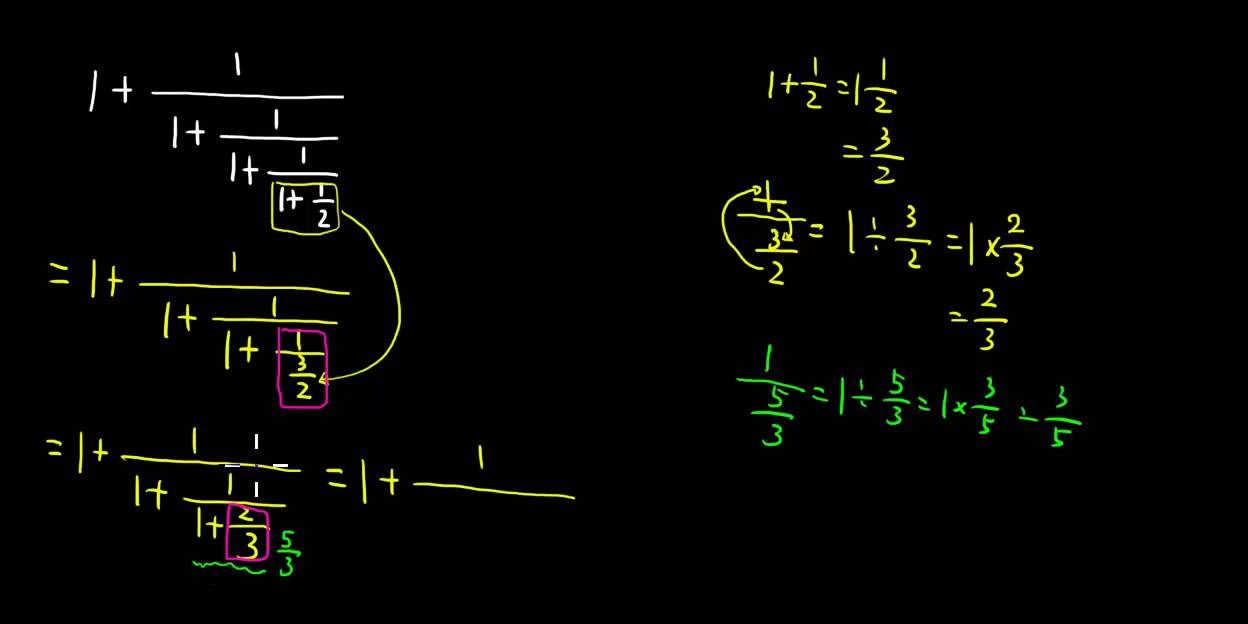

一条审稿意见没能理解一个小学数学问题的变体,另一条质疑整个流形学习和无监督学习领域,AC(领域主席)还都认同了。

……

种种抱怨声甚至已经传到了机器学习领域之外,搞得其他领域学者一头雾水。

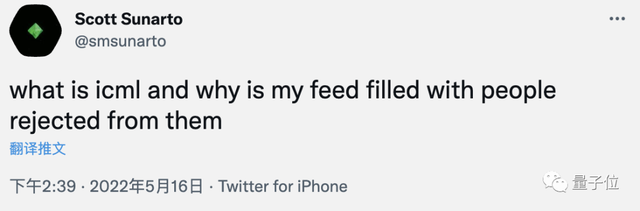

但是从宏观看的话,今年ICML的接受率为21.9%,与前两年相比也基本持平。

评审并没有更严格,而是像马毅教授批评的那样“更随意”了。

有人收到审稿人的一致好评,最终却因4个拼写错误在元评审(meta review)阶段被拒。

还有人因审稿人没提出高质量意见付出代价。

这届ICML,问题究竟出在哪里?

新机制:创造的问题比解决的多

机器学习会议投稿量逐年激增,审稿人工作强度大、审稿质量和速度无法兼顾问题越来越凸显。

作为应对,ICML2022做出了几项变化。

审稿人来源的变化,邀请更多投稿人同时担任审稿人,试图把审稿工作量摊薄。

流程上的变化,采用两阶段审稿再配合元审稿机制。

两阶段审稿由AAAI 2021引入,今年被更多会议采用。

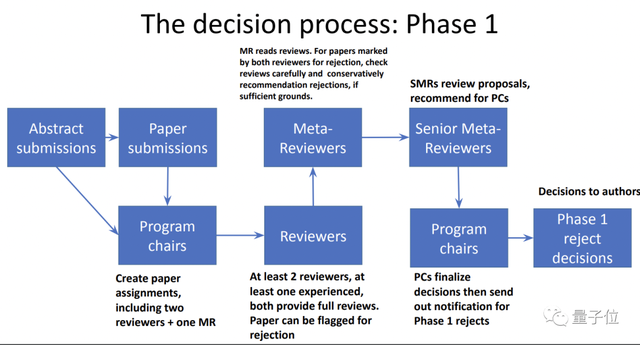

在第一阶段,每篇论文分配至少两个审稿人,如果两人一致认为应该拒稿,交给元审稿人再判断一次,最终提交给会议主席做决定。

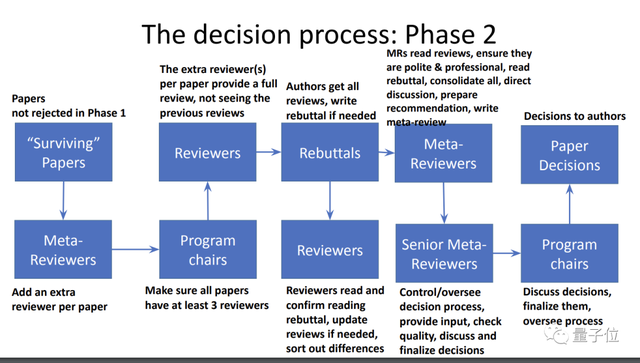

第二阶段,留存的文章再分配第三个审稿人不参考第一轮结果独立评审,rebuttal后再由两轮元审稿做判断。

细节上的变化还有一条,作者和元审稿人看不到审稿人打的分数,只能看到文字评价。

一系列变化的初衷是为减轻审稿人压力,和促使他们做出更高质量的评价,但具体执行上却走了样。

首先,新机制导致不负责任的审稿人更多了。

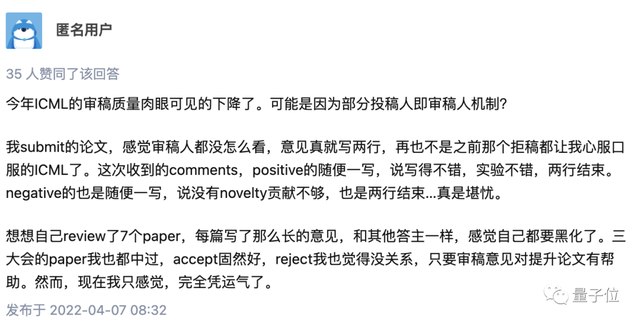

有人反馈,审稿质量肉眼可见的下降了,自己当审稿人时很认真,但自己的论文分配到的审稿人都是随便一些。

另一位作者兼审稿人有同样的遭遇,遇到凑数的、不懂装懂的、甚至要求作者引用自己论文的。

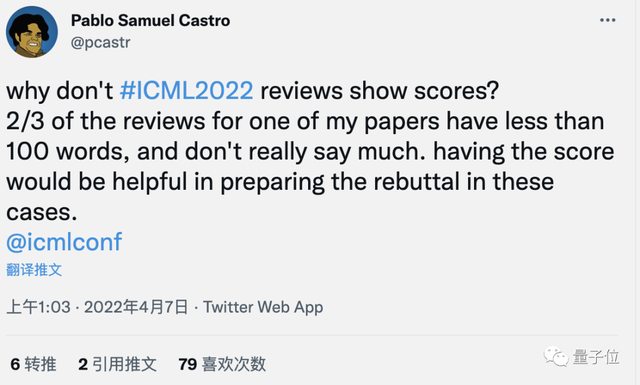

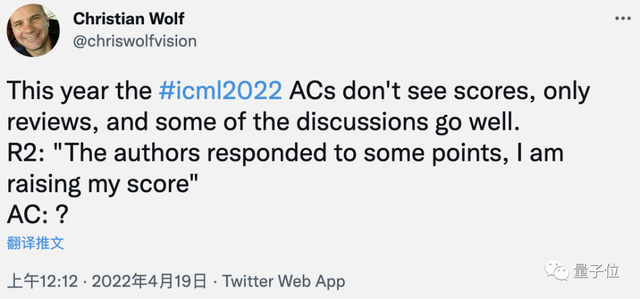

第二,不显示分数的试验性做法让很多人不适应。

对于作者来说,没有分数又遇到不认真的审稿意见的话,在rebuttal阶段无从着手。

在审稿人和元审稿人之间也带来沟通障碍。

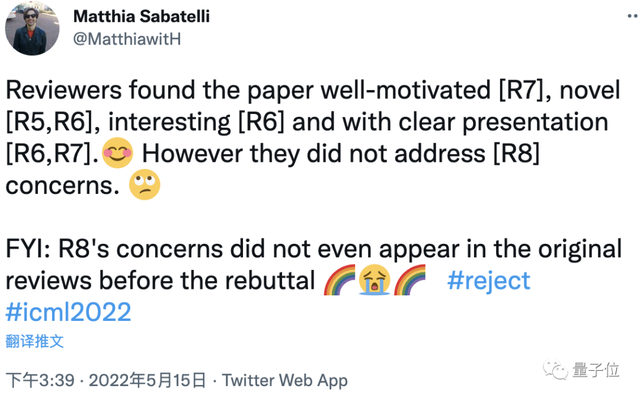

最后,新引入两阶段审稿流程不完善,带来新的问题。

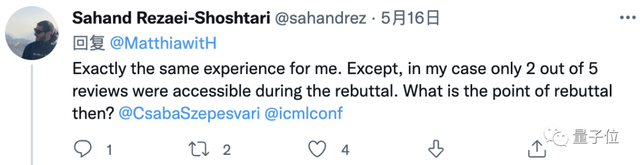

有不少人反映,在rebuttal之前并没有看到所有评审意见。

这位收到的5条意见在rebuttal过程中只能看到2条。

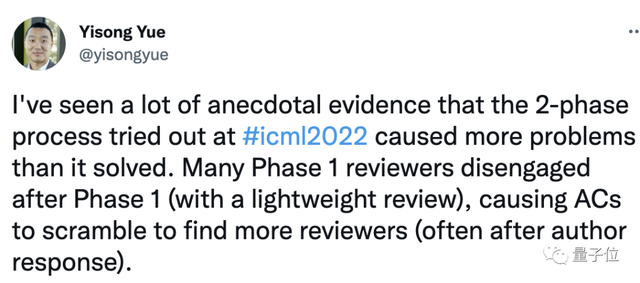

根据加州理工教授Yisong Yue分析,问题在于很多审稿人一阶段给出简单评价后就不跟进了,导致元审稿人必须再分配更多的审稿人,不够及时的话就会发生在作者回复之后。

综合各种因素,最终新机制产生的问题似乎比解决的还多。

ICML在机制创新上经常走在前面,过去率先要求提交代码,提出规范实验步骤,都取得不错的效果,也被其他会议跟进。

对于审稿这个老大难问题,你有什么想法?

参考链接:

[1]https://twitter.com/ylecun/status/1526033359398379521

[2]https://github.com/lixin4ever/Conference-Acceptance-Rate

[3]https://www.zhihu.com/question/524486916

[4]https://media.icml.cc/Conferences/ICML2022/ICML2022_AC_Tutorial.pdf

- 扩散模型还原被遮挡物体,几张稀疏照片也能”脑补”完整重建交互式3D场景|CVPR’252025-04-23

- 3D高斯泼溅算法大漏洞:数据投毒让GPU显存暴涨70GB,甚至服务器宕机2025-04-22

- PPIO姚欣:让免费成为可能,AI时代开启“提速降费”|中国AIGC产业峰会2025-04-22

- o3/o4-mini幻觉暴增2-3倍!OpenAI官方承认暂无法解释原因2025-04-21