AlphaFold2成功秘诀:注意力机制取代卷积网络,预测准确性提升超30%

预测准确性达92.4/100

明敏 发自 凹非寺

量子位 报道 | 公众号 QbitAI

最近,DeepMind开源AlphaFold2,让学术圈再一次沸腾了。

这意味着,对于普通研究人员而言曾需要花几年时间才能破解的蛋白质结构,现在用AlphaFold2几小时就能算出来了!

那么,如此厉害的AlphaFold2究竟如何做到的呢?

DeepMind团队已经将它的详细信息在《Nature》上公开发表。

现在,就让我们来看看AlphaFold2的魔法是怎么实现的吧。

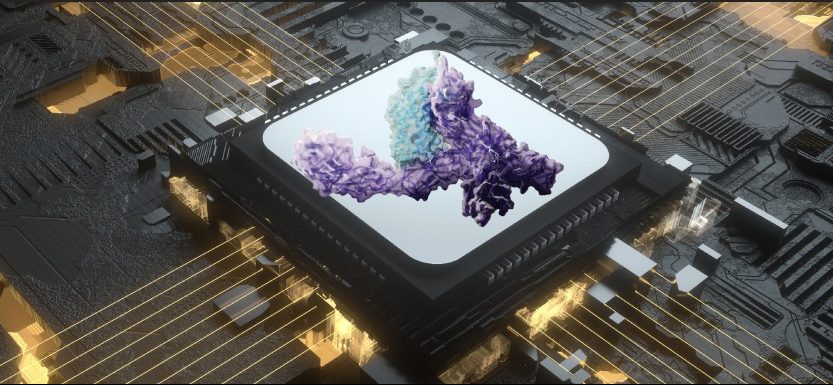

卷积消失了,Attention来了

论文中,研究人员强调AlphaFold2是一个完全不同于AlphaFold的新模型。

的确,它们使用的模型框架都不一样,这也是AlphaFold2准确性能够突飞猛进的主要原因。

此前AlphaFold中所有的卷积神经网络,现在都被替换成了Attention。

为什么要这样做呢?

我们首先要了解一下AlphaFold的工作原理:

它主要是通过预测蛋白质中每对氨基酸之间的距离分布,以及连接它们的化学键之间的角度,然后将所有氨基酸对的测量结果汇总成2D的距离直方图。

然后让卷积神经网络对这些图片进行学习,从而构建出蛋白质的3D结构。

△AlphaFold主要架构

但这是一种从局部开始进行预测的方式,很有可能会忽略蛋白质结构信息的长距离依赖性。

而Attention的特点刚好可以弥补这一缺陷,它是一种模仿人类注意力的网络架构,可以同时聚焦多个细节部分。

这样可以使得框架预测的结果更加全面、准确。

在CASP13中,AlphaFold预测的准确性还只有不到60分。

但是在CASP14中AlphaFold2就将准确性直接拔高到了92.4/100。

图网络+Attention

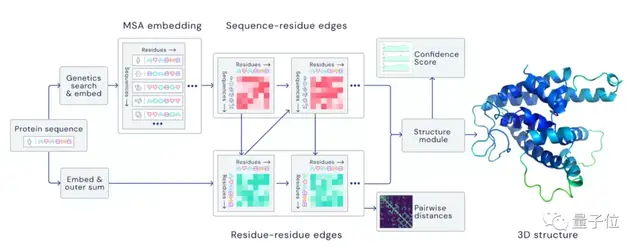

具体来看,AlphaFold2主要利用多序列比对(MSA),把蛋白质的结构和生物信息整合到了深度学习算法中。

它主要包括两个部分:神经网络EvoFormer和结构模块(Structure module)。

在EvoFormer中,主要是将图网络 (Graph networks)和多序列比对 (MSA)结合完成结构预测。

图网络可以很好表示事物之间的相关性,在这里,它可以将蛋白质的相关信息构建出一个图表,以此表示不同氨基酸之间的距离。

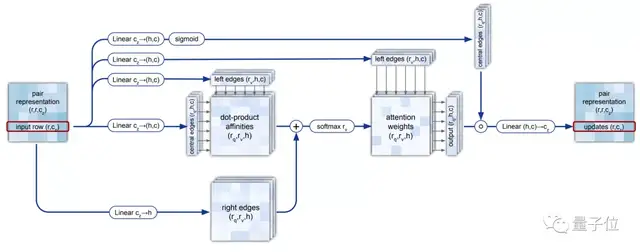

研究人员用Attention机制构建出一个特殊的“三重自注意力机制(Triangular self-attention)”,来处理计算氨基酸之间的关系图。

△三重自注意力机制(Triangular self-attention)

然后,他们将这一步得到的信息与多序列比对结合。

多序列比对主要是使相同残基的位点位于同一列,暴露出不同序列之间的相似部分,从而推断出不同蛋白质在结构和功能上的相似关系。

计算出的氨基酸关系与MSA进行信息交换,能直接推理出空间和进化关系的配对表征。

预测所有原子的3D结构

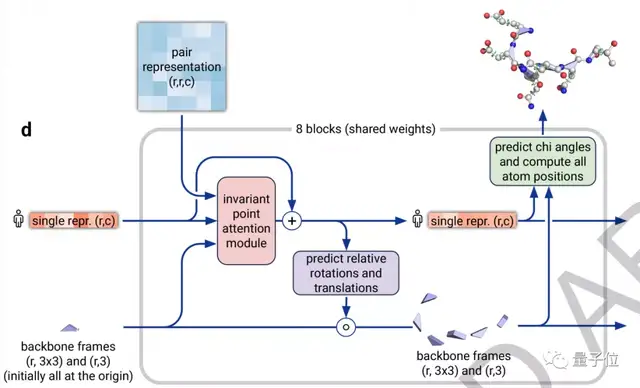

架构的第二部分是一个结构模块 (Structure Module),它的主要工作是将EvoFormer得到的信息转换为蛋白质的3D结构。

△结构模块(Structure module)

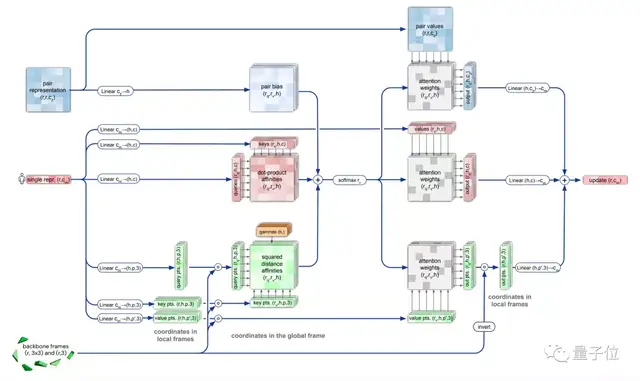

在这里,研究人员同样使用了Attention机制,它可以单独计算蛋白质的各个部分,称为“不变点注意力(invariant point attention)”机制。

它以某个原子为原点,构建出一个3D参考场,根据预测信息进行旋转和平移,得到一个结构框架。

△不变点注意力(invariant point attention)

然后Attention机制会对所有原子都进行预测,最终汇总得出一个高度准确的蛋白质结构。

此外,研究人员还强调AlphaFold2是一个“端到端”的神经网络。

他们会反复把最终损失应用于输出结果,然后再对输出结果进行递归,不断逼近正确结果。

这样做既能减少额外的训练,还能大幅提高预测结构的准确性。

为破解蛋白质折叠谜题带来希望

Alphafold2的出现,能更好地预判蛋白质与分子结合的概率,从而极大地加速新药研发的效率。

此次Alphafold2开源,将进一步推动科学界前进。

据了解,目前DeepMind已经与瑞士的一些研究团队合作,通过预测蛋白质结构开展药物方面的研究。

事实上,研究Alphafold2预测程序本身,也为探索蛋白质结构折叠原理带来了希望。

芝加哥大学的计算生物学家Jinbo Xu就表示:

这些工具的开源,意味着科学界能够在此基础上开发出更加强大的软件。

论文地址:

https://www.nature.com/articles/s41586-021-03819-2_reference.pdf

补充材料:

https://static-content.springer.com/esm/art%3A10.1038%2Fs41586-021-03819-2/MediaObjects/41586_2021_3819_MOESM1_ESM.pdf*

参考链接:

https://www.zdnet.com/article/deepminds-alphafold-2-reveal-what-we-learned-and-didnt-learn/

- 业界首创,海螺集团携手华为发布水泥建材人工智能大模型2025-04-23

- 本周三!机器人与数字化转型应用解析,线上研讨会诚邀你来围观2025-04-22

- 数势科技谭李:企业级AI应用不止ChatBI,拿到数据不等于拿到洞见 | 中国AIGC产业峰会2025-04-22

- 3分钟搭建一个调用支付宝的智能体,MCP爆发,蚂蚁推了一把2025-04-18