杨净 发自 凹非寺

量子位 报道 | 公众号 QbitAI

只需一段语音,就能生成说话视频。

就像这样。

可以看到,表情、动作、神情全都在线,还有不同的穿搭。

就连发型、甚至发际线,都可以不同。(手动狗头)

视频里的主人公,是美国一著名主持人John Oliver,这是他主持的一档节目《Last Week Tonight with John Oliver 》。

而这样一个视频生成效果,在Reddit上热度达580+。

不少网友表示:那这样,是不是视频博主就从此省事了?!

别着急,先康康研究怎么说。

论文详情

能实现以上效果的,是一个NWT生成器,用表征学习来实现音视频生成。

它由两个模型组成。

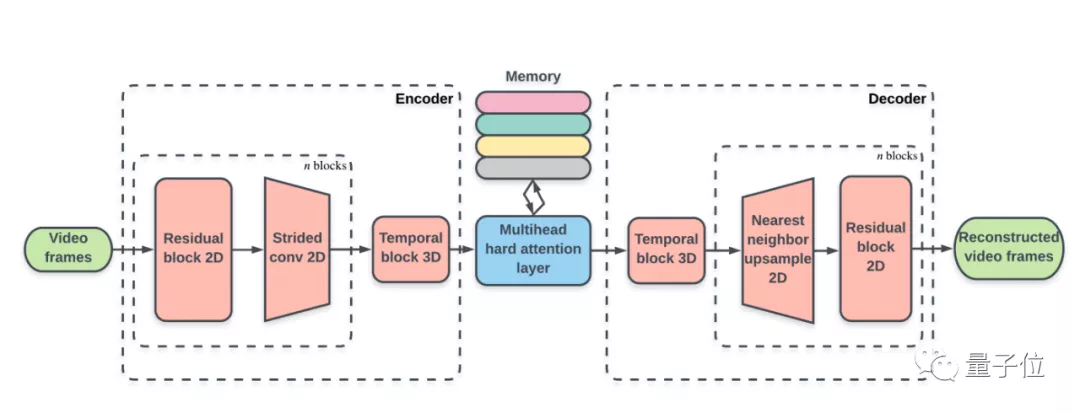

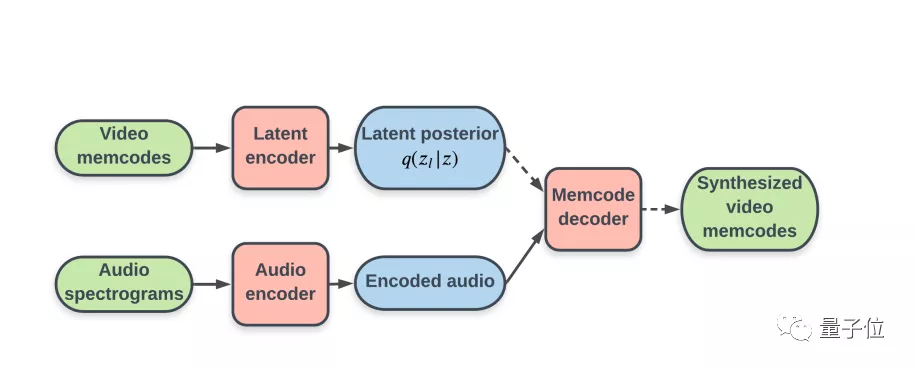

一个用于离散潜在表示的视频自动编码器dVAE-Adv。另一个自回归先验模型,用来生成新视频。

此外,这一生成器可以控制生成的视频中的潜在属性,这些属性在数据中是没有标注的。

首先,自动编码器dVAE-Adv,将视频帧从256×224压缩到一个16×14的潜在空间。

生成的每个潜在网格元素称为Memcode,每个Memcode在像素域中携带了大约768个元素的信息。

而自回归模型则作为编解码器模型,能从离散分类分布中自动采样,将音频转化为视频。

研究人员采用的数据集,则是来自这位主持人的节目——《Last Week Tonight with John Oliver (LWT)》组成。

不过这些视频样本是经过处理的,研究人员将其分成了16127个视频片段,平均长度为7.46秒。

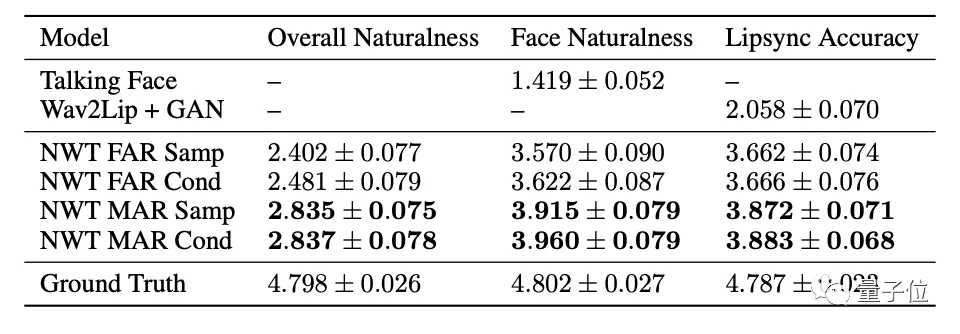

最终在主观评价测试中,这一方法都明显优于以往的唇语、脸部生成任务。

研究人员表示,这个研究是对话式人类视频合成技术上的一个新突破,展现了未来将普遍应用的潜力。

srds(虽然但是),目前这个模型还是有一定局限性。

比如,不能用其他人声音来生成。

对此作者回应道,尝试过,但唇语同步会有影响。

还有网友注意到,视频中人的手很奇怪。

作者则表示,跟GAN出现的问题不同,主要是由自回归生成过程中的错误分类造成的。

接下来,他们将进一步扩大数据集和模型,来处理不同个体。还有一个想法就是,给定一个框架或部分图像,模型能够模仿一个特定的情节。

论文地址:

https://arxiv.org/pdf/2106.04283.pdf

参考链接:

[1]https://next-week-tonight.github.io/NWT_blog/

[2]https://www.youtube.com/watch?v=HctArhfIGs4