拯救“没常识”的GPT-3得靠它了,交大ACM班校友提出“Voken” 无监督学习 | EMNLP 2020

让BERT学会“看图说话”

晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

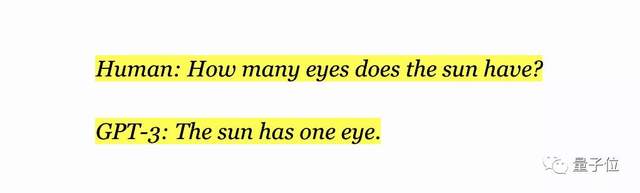

纵使地表最强语言模型GPT-3学习了30亿个单词的英文维基百科,但是依然会犯低级错误。

如果你问它:太阳有几只眼睛?

GPT-3会说“有一只”,不会意识到这个问题本身就是错误的。

因为仅受文本的训练很难让AI具备常识。

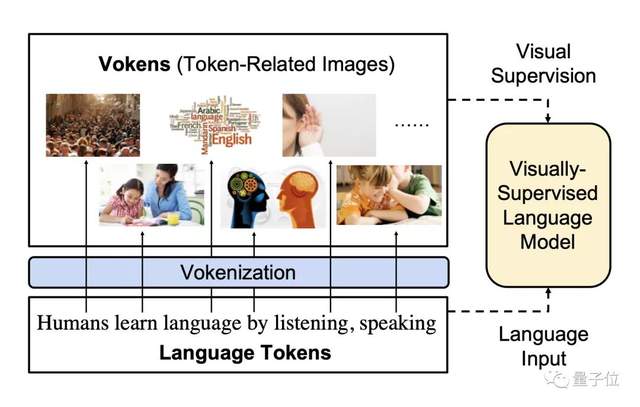

而人类靠“听说读写”全方位来学习一门语言,小时候还会有“看图说话”之类的训练。可见语言能力的形成绝不只能靠单调的语料库来解决。

因此北卡罗来纳大学教堂山分校(UNC Chapel Hill)的研究人员设计了一种新技术——Vokenization——来改变纯语言模型学习能力不足的现状。

用图像和语言联合训练AI并不是什么新鲜事,但这一次他们使用了无监督方法扩展了有限的图像资源,对于视觉语言模型来说是一项重要突破。

该论文已经被EMNLP 2020收录,相关代码也已经开源。

解决图片数据集不足问题

要让AI像人类一样从“图片卡”学习语言并非易事。

因为图像数据集和纯文字语料库之间,无论是大小还是分布上,都存在着巨大的差异。

例如,下面的图片在视觉语言数据集中被描述为:“一只橘猫坐在一个准备打包的行李箱里。”

用这样的数据集训练,可以教会AI模型如何从动词介词中识别对象以及它们之间的关系。

但手工编写句子的工作量是巨大的,大部分图像数据集只会用“猫”这一个词来描述图片。只有用无监督方法才能让AI学习到更大的数据集。

GPT-3可以通过无监督学习进行训练,这个过程不需要人工数据标注,训练数据集可以做到非常大。而目标识别算法虽然能让AI从现实中学到更多知识,却存在着样本数量太少的问题。

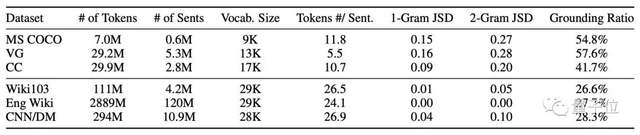

比如,COCO数据集仅有150万个已标记的目标实例、700万个单词,而英文维基百科语料库有近30亿个单词。

从token到voken

Vokenization解决了这个问题,它使用无监督学习方法将样本数量较少的COCO数据集扩展到英文维基百科的大小。

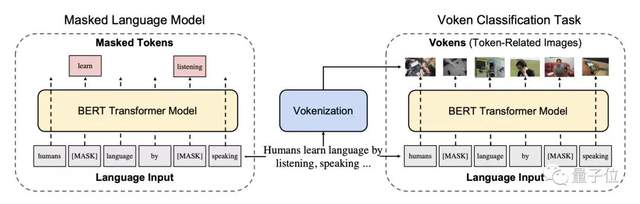

研究NLP的人都知道,用于训练语言模型的单词称为token,作者将图像问题中的每个token相关的图像称为“voken”。

论文作者不从语言数据集开始,并使用无监督学习来将每个单词与相关图像进行匹配,这是一个高度可扩展的过程。

Transformer是人们首次引入无监督学习用于NLP,它根据单词上下文创建每个单词的嵌入。比如“猫”一词的嵌入表明,它经常在“喵”和“橘色”两词附近使用,而很少和“树皮”或“蓝色”这样的词一起使用。

有一种平行技术也可以用于图像的“上下文”,它能列出了猫在床上而不是树上出现的频率,并创建了嵌入该上下文信息的“猫”。

研究人员在COCO上同时使用两种嵌入技术。他们将图像转换为视觉嵌入,将文字描述转换为单词嵌入。

在特征空间中,相近的单词嵌入其对应的视觉嵌入也离得更近。一旦将所有视觉嵌入进行比较并相互关联,就很容易将图像与单词进行匹配。

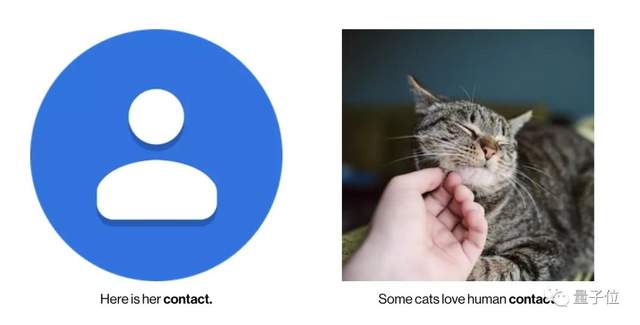

当一个词在不同语境中含义完全不同时,这很有用。Vokenization技术通过为每个单词实例找到不同的voken成功地解决了这一问题。

比如contact这个单词,当它在左边这幅图中出现的时候表示“联系人”,而在右边这幅图中出现时表示“接触”。

经过这种处理方式,算法找到了英文维基百科40%的token对应的voken。虽然没有找全,但是token总共有个30亿个啊!即使只有40%也大大扩展了数据集。

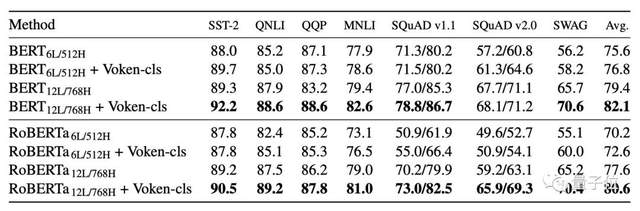

利用这个数据集,研究人员重新训练了BERT,在GLUE、SQuAD和SWAG等测试标准上,均优于纯文本训练的结果。

NLP初创公司Hugging Face的联合创始人Thomas Wolf认为,他们的工作是使无监督学习适用于视觉语言模型的一项重要的概念突破,有助于大大推动NLP技术的发展。

作者简介

这篇论文的第一作者是谭昊,本科毕业于上海交大ACM班,现正在北卡罗来纳大学教堂山分校攻读博士学位。

△ 谭昊(图片来自彭博)

谭昊曾获得2019~2020彭博数据科学博士奖学金,他以一作身份发表的论文分别被AAAI、NAACL 、ACL、EMNLP、IJCAI等顶会收录。

谭昊的导师Mohit Bansal教授是本文的通讯作者,他还是北卡大学教堂山分校MURGe实验室主任。

△ Mohit Bansal(图片来自UNC官网)

论文地址:

https://arxiv.org/abs/2010.06775

代码地址:

https://github.com/airsplay/vokenization

第三方解读:

https://www.youtube.com/watch?v=4T1u3Z2DaZA&ab_channel=DeepLearningExplainer

- 脑机接口走向现实,11张PPT看懂中国脑机接口产业现状|量子位智库2021-08-10

- 张朝阳开课手推E=mc²,李永乐现场狂做笔记2022-03-11

- 阿里数学竞赛可以报名了!奖金增加到400万元,题目面向大众公开征集2022-03-14

- 英伟达遭黑客最后通牒:今天必须开源GPU驱动,否则公布1TB机密数据2022-03-05