2分31秒!腾讯云创造128卡训练 ImageNet 新记录

在128卡训练 ImageNet 这个任务上,又诞生了个新纪录!

而刷新纪录的选手,就是腾讯云——仅需2分31秒。

腾讯云创造新纪录

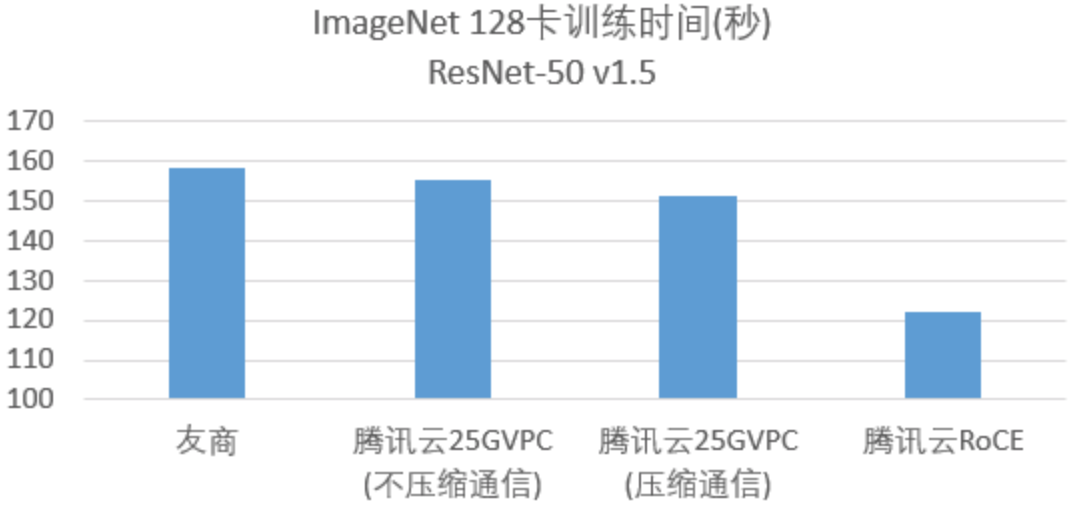

如此成果,主要基于腾讯公有云25Gbps的VPC网络环境,使用128块V100,借助Light大规模分布式多机多卡训练框架,在2分31秒内训练 ImageNet 28个epoch,TOP5精度达到93%。

若跨机网络改为RoCE,则训练时间进一步减少到2分2秒。之前业界同样使用128块V100的最好结果是友商的2分38秒。

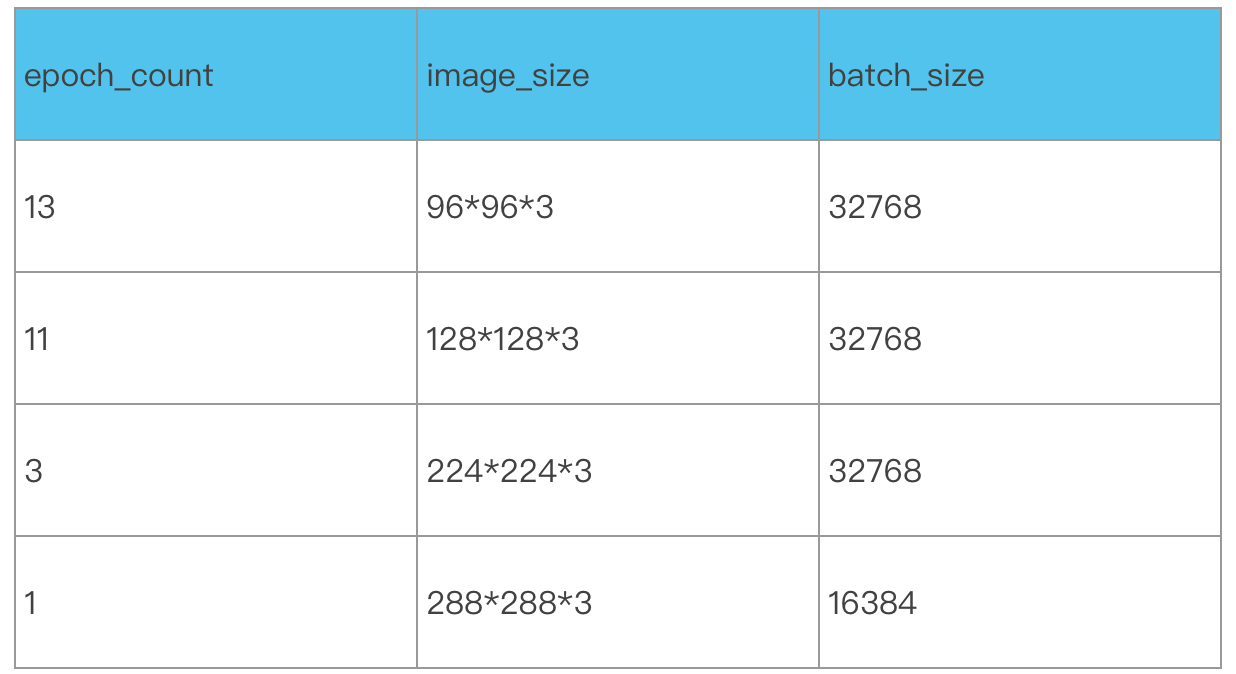

其中,28个epoch分别是:

2分31秒的纪录是如何创造的?

首先是在单机训练速度方面,腾讯利用GPU云服务器的内存和SSD云盘,在训练过程中为训练程序提供数据预取和缓存,加速了访问远程存储数据。

而针对大量线程相互抢占导致CPU运行效率低下问题,腾讯云通过自动调整最优数据预处理线程数来降低CPU的切换负担,让数据预处理和GPU计算并行,提升了整体训练的速度。

其次,是在多机扩展训练方面,以往的TCP环境下,跨机通信的数据需要从显存拷到主存,再通过CPU去收发数据,计算时间短加上通信时间长,使多机多卡的扩展性受到了很大挑战。

腾讯云则凭借Light高效扩展了多机训练,通过自适应梯度融合技术、层级通信+多流手段、层级topk压缩通信算法等,充分利用通信时的网络带宽,优化了跨机通信的时间。

此外,为充分利用大规模集群算力,目前业界主要通过不断提升训练的batch size来提升训练速度,但是batch size的增大会对精度带来影响和损失。

为解决这一问题,腾讯云通过大batch调参策略、梯度压缩精度补偿、AutoML调参等方法,有效实现了在增大batch size的同时,最小化其对精度的影响。

通过 Light大规模分布式多机多卡训练框架及平台等一系列完整的解决方案,ImageNet的训练结果取得了新突破。并且在取得高效训练的同时,也将其能力集成到腾讯云智能钛机器学习平台,并广泛应用在腾讯内外部的业务。

接下来,联合项目团队还将进一步提升机器学习平台易用性,训练和推理性能,构建稳定、易用、好用、高效的平台和服务,为算法工程师提供有力的机器学习工具,助力各行各业用户业务的发展。

- 教育信创到底怎么选?能做到”无感切换”的只有C862025-04-21

- 清华张亚勤:10年后,机器人将可能比人都多2025-04-21

- 全球首个无限时长视频生成!新扩散模型引爆万亿市场,电影级理解,全面开源2025-04-21

- 具身空间数据技术的路线之争:合成重建VS全端生成2025-04-21