“忽悠”智能机器人,竟然改改物品纹理就成功了!北航新研究:时空融合对抗攻击算法

瑟瑟发抖

作者:刘艾杉

编辑:鱼羊

量子位 报道 | 公众号 QbitAI

简单修改环境物体的纹理颜色,就能让机器人执行攻击者设计的错误行为!

来自北航、悉尼大学、伯克利和伦敦大学的一项最新研究成果显示:

通过对抗攻击修改3D物体的外表纹理属性,就可以使得智能机器人在动态场景中,执行任何攻击者预先设计好的错误行为或错误地回答问题。

在智能机器人逐渐被应用到智能家居、危险品检测和拆除等场景的当下,这么轻松就被“忽悠”了,实在让人有些瑟瑟发抖。

究竟是怎么一回事?

如上图所示,Embodied Question Answering任务是指:在动态三维环境中,随机放置智能机器人并给其一段用自然语言描述的环境相关的问题,智能机器人通过自主视觉导航和环境感知来回答问题。

这篇题为Spatiotemporal Attacks for Embodied Agents的论文,提出使用时空融合的对抗攻击方法来生成3D对抗噪音,投影至特定物体的外表纹理上,当智能机器人感知到环境中带有攻击性的物体之后,就会错误回答问题或执行错误的行为。

如:“What room is the chessboard located in?”,智能机器人在感知到带攻击性的“笔记本电脑”和“沙发”等物体后回答为“Bathroom”(正确答案为“living room”)。

目前论文已在全球计算机视觉顶级会议ECCV-2020上发表。

经实验证实,用该方法生成的3D对抗噪音(adversarial perturbations)具有稳定的攻击效果,将其投影在3D物体上后改变了其纹理和颜色。

其不会影响人类对于物体语义信息的认知,但是该噪音对于基于深度学习的智能机器人则是毁灭性的。

例如,这种攻击可能被恶意地用来攻击智能机器人,入侵者只需要修改场景内的某些物体的外观颜色和纹理,当智能机器人感知环境时就可能会造成系统的致命错误,导致机器人宕机或错误回答问题。

基于时空融合的对抗攻击

该论文提出了一种时空融合的对抗攻击算法,该算法分别利用时间维度和空间维度的信息来生成3D对抗噪音,有效的攻击智能机器人模型。通过将该3D对抗噪音投影至3D物体的表面,修改其3D颜色纹理,当智能机器人感知到相关物体时就会执行预设好的错误行为或对于问题给出错误的答案。算法的整体架构如下:

为了达成效果,时空融合的对抗攻击算法主要包含以下几个部分:

时间维度

智能机器人在进行当前的决策时(如:执行动作或回答问题),一般不仅仅依赖于当前的观测和感知信息,还需要考虑其历史观测信息。因此,为了攻击在动态环境中的智能机器人,迫使其作出预设的错误行为,需要考虑其历史观测信息。

因此,这里考虑智能机器人的前N个历史观测场景,并攻击出现在其中的物体的3D特征:

但是,前N个历史场景中出现的3D物体数量过大,直接对于所有的物体进行对抗攻击会造成噪音过于分散、攻击能力不足等问题。

为此,研究人员设计了路径注意力模块A,计算智能机器人历史路径中各个历史场景对于模型决策的重要程度,选取其中最重要的考虑智能机器人的前N个历史观测场景,并攻击出现在最重要的K个历史观测场景中的物体:

空间维度

神经心理学研究表明,当人类在进行视觉感知时,其不仅仅关注目标物体,环境信息(contextual objects)充当着极其重要的作用。例如:当询问“What room is the chessboard located in?”时,我们不仅仅只会关注目标物体“chessboard”本身,还会关注该物体的周围环境信息来辅助确定最终答案。

为了提升攻击性,研究人员进一步选择攻击出现在K个历史观测场景 S={S1, …, SK}中的M个环境物体 X={X1, …, XM}:

研究人员引入一个可导的渲染器,并通过梯度下降来修改待攻击物体的3D属性信息(如:纹理颜色):

整体优化损失

将时空信息融合,就得到了整体的优化损失函数:

其中,为了增加攻击成功率,研究人员引入不同的环境信息c来进行噪音的优化(如:角度、光照)。进一步,控制产生的噪声大小范围来使得其人眼不可感知:

实验结果:智能机器人很容易被欺骗

通过实验结果评估该对抗攻击算法的有效性,主要针对EQA-v1数据集进行测试。

可导渲染器的攻击效果

首先,研究人员将渲染过程中的渲染器设置为可导的,并分别进行了白盒攻击和黑盒攻击实验。通过下表可示,该算法在多个指标上都取得了最高的攻击成功率(问答准确率和移动距离等):

不可导渲染器的攻击效果

在真实世界场景中更多使用不可导渲染器,因为其可以更好渲染出更加逼真和丰富的场景元素和环境条件。因此,在不可导渲染器上的对抗攻击效果可以有效的验证本方法在真实场景中的可行性。如下图所示,时空融合对抗攻击算法可以在未知参数的“黑盒”不可导渲染器下取得很好的攻击效果。

可视化效果

通过下图可以看出,时空融合的对抗攻击算法所生成的对抗噪音具有非常好的视觉效果,可以达到人眼不可分辨(黄色方框表示对抗攻击的物体)。

对抗攻击的作用

除了攻击智能机器人使其执行错误的操作和行为,本文提出的时空融合的对抗攻击对于提升模型的鲁棒性和模型行为的理解都有重要作用和意义。

通过对抗训练提升模型鲁棒性

通过在智能机器人的训练过程中混入由时空融合产生的对抗3D场景,研究人员使用对抗训练来提升智能机器人对于噪音的鲁棒性。通过对抗训练,智能机器人在对抗场景下和高斯噪音场景下的表现能力都得到了很大的提升(问答准确率,对抗场景:5.67%->23.56%,高斯噪音场景:22.14%->38.87%)。

模型决策行为理解

通过对抗攻击,本文拟进一步探索智能机器人脆弱的原因以及它们在决策时所依赖的特征偏好。研究人员用同样大小的对抗噪音来分别修改物体的“纹理”和“形状”属性,并使用同一场景对于智能机器人进行对抗攻击。通过实验研究人员发现,对于智能机器人模型,纹理攻击(准确率4.26%)比形状攻击(27.14%)的效果要强非常多。这进一步证明了,目前深度神经网络的决策方式更多的是依赖于对于纹理颜色信息的感知而不是对于物体形状的感知。

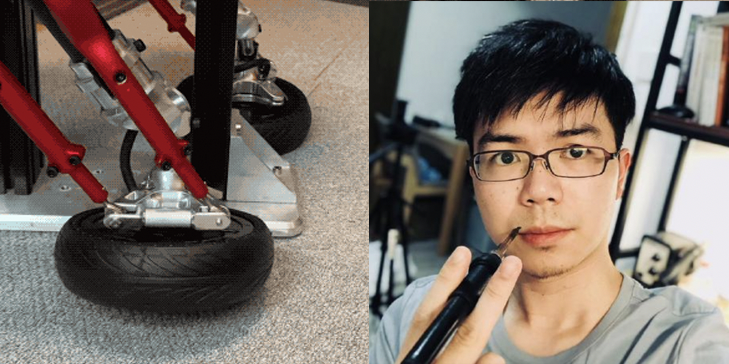

关于作者

论文第一作者刘艾杉,目前在北京航空航天大学计算机学院攻读博士。

主要研究方向为对抗样本、深度学习鲁棒性、人工智能安全性,已在ECCV、AAAI、IJCAI等国际顶级人工智能与计算机视觉会议发表多篇论文。

传送门

论文地址:https://arxiv.org/abs/2005.09161

代码地址:https://github.com/liuaishan/SpatiotemporalAttack

— 完 —

- 10秒生成官网,WeaveFox重塑前端研发生产力 | 蚂蚁徐达峰@中国AIGC产业峰会2025-04-30

- 粉笔CTO:大模型打破教育「不可能三角」,因材施教真正成为可能|中国AIGC产业峰会2025-04-18

- GPT-4.1淘汰了4.5!全系列百万上下文,主打一个性价比2025-04-15

- SOTA自动绑骨开源框架来了!3D版DeepSeek开源月大礼包持续开箱ing2025-04-11