姚班代有才人出:清华本科生用“最简单的形式”,大幅提高少样本学习性能

鱼羊 十三 发自 凹非寺

量子位 报道 | 公众号 QbitA

仅仅根据元学习(Meta-Learning)的基线,就彻底打败了所有“花里胡哨”的改进方法。

就是这些看似简单,又容易被忽略的方法,却有着强大的魔力。

而它们的发现者,是一位叫做陈胤伯的在读本科生,来自清华姚班。

他提出了一种元基线 (Meta-Baseline)方法,通过在所有基类(base classes)上预先训练分类器,并在基于最近质心的少样本(few-shot)分类算法上进行元学习,实验结果大大优于目前最先进的方法。

那么问题来了:为什么这么简单的方法却如此有效?

作者发现,在元学习阶段,一个模型在基类未见任务中的获得更强泛化能力的同时,在新类任务中的泛化表现可能反而下降。

此外,对于元基线来说,存在2个重要的因素:一个是预训练,另一个是从预训练分类器中继承一个好的少样本分类度量。

这就有可能让模型更好地利用,具有更强可传递性的预训练表示。

陈胤伯的研究可以说是从问题的本质出发,直击“七寸”,正如论文所说:

这项工作为该领域建立了一个新基准,并给进一步理解元学习框架(用于少样本学习)提供了思路。

知名互联网博主、北邮陈老师也分享了这项研究,得到了较高的关注。

那么,具体又是怎么做到的呢?

什么是元基线方法?

少样本学习的目的,是让分类模型能迁移到仅带有少量标记样本的新类别中。而元学习是目前少样本学习研究中比较常见的方法。

陈胤伯的元基线方法所做的,是用最简单的形式利用预训练分类器和元学习的优势。

元基线方法包括两个训练阶段。

阶段一:预训练阶段

预训练阶段,主要是分类器基线(Classifier-Baseline)的训练。

具体方法是,在具有标准交叉熵损失的所有基类上训练分类器,然后删除其最后一个 FC 层,得到编码器 fθ。编码器能将输入映射到特征空间。

阶段二:元学习(meta-learning)阶段

这一阶段,主要基于分类器基线评估算法,进行模型优化。

给定预训练特征编码器fθ,在基类训练数据中采样 N-way K-shot 任务。

为了计算每个任务的损失,在支持集(support-set)中计算N种类型的质心,公式如下。

然后用它们来计算查询集(query-set)中每个样本的预测概率分布,公式如下。

损失是根据 p 和查询集样本的标签计算的交叉熵损失。

简单的基线改良,大幅提升性能

那么,元基线方法效果如何?

论文作者在 miniImageNet 和 tieredImageNet 两个数据集上进行了实验。

△miniImageNet

△tieredImageNet

可以看到,尽管元基线方法设计简单,但在两个数据集上,都明显超过了前辈们,提高了至少 2 个百分点。

这样的改进效果并不仅仅局限于 N-way K-shot 任务。在单类 K-shot 任务中,实验结果同样证明了元学习阶段的有效性。

作者还在大规模数据集 ImageNet-800 上进行了进一步评估。

在这一规模的数据集上,1-shot 任务中,比起分类器基线,元基线有大幅提升。但在 5-shot 任务中,性能没有明显的改善。

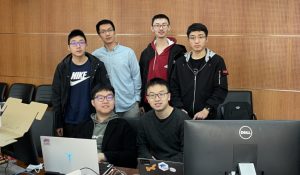

一位清华姚班本科生

最后,姚班代有才人才,一起认识一下今日主角吧。

陈胤伯,清华姚班本科生,高中就读于湖南省长沙市长郡中学,高中期间除了日常学习外,大部分时间都投入到了算法竞赛之中。

陈胤伯回忆说,非常幸运身边能有许多提供指导、探讨问题的朋友,可以共同学习、共同进步。

加之对算法竞赛浓厚的兴趣和不懈的努力,陈胤伯在NOI 2014上摘得金牌,入选国家集训队,并保送清华大学。

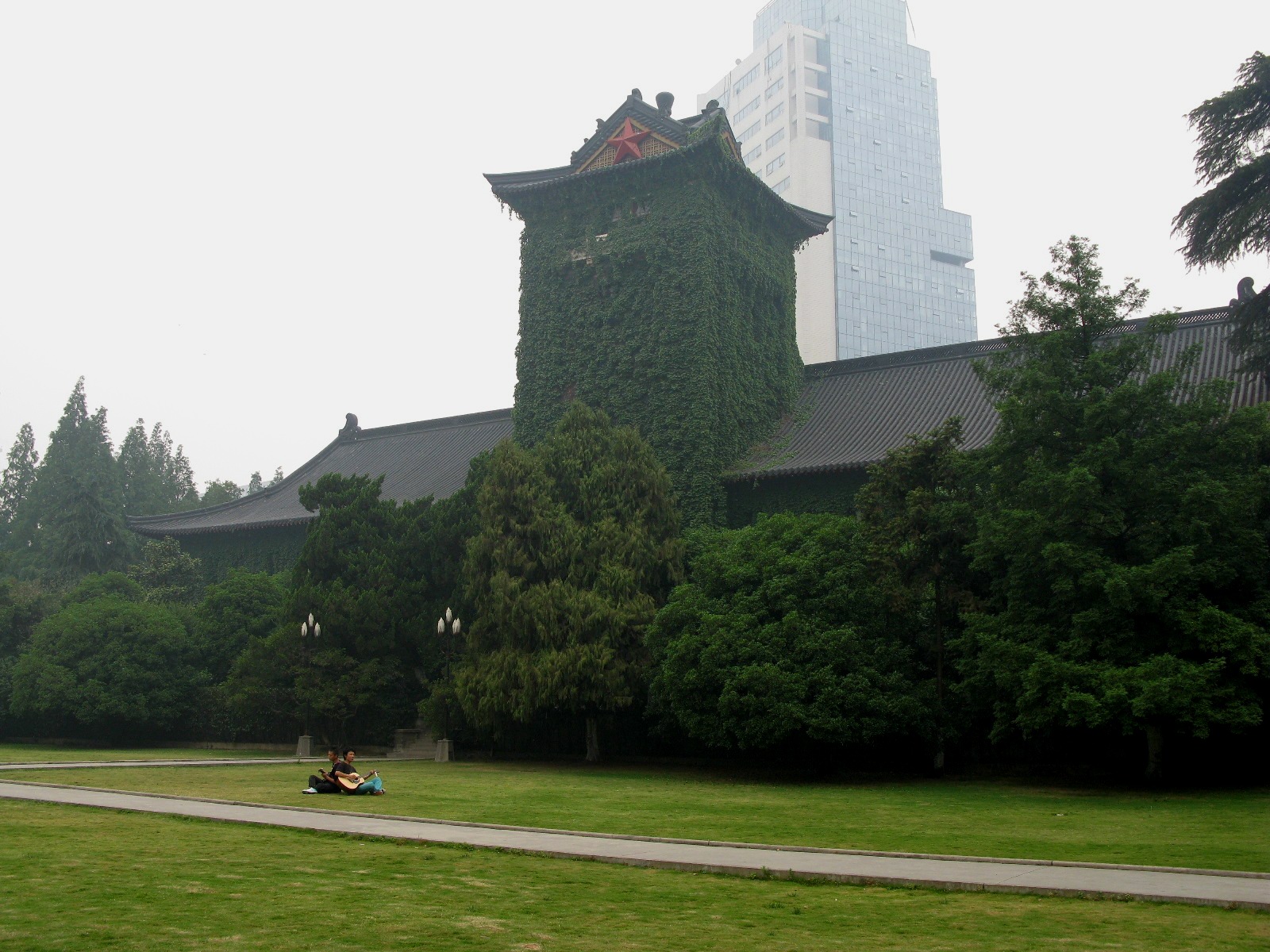

目前,陈胤伯就读于清华姚班(清华学堂计算机科学实验班),将于今年本科毕业。

不过下一阶段目标也已经明确。

接下来,他将继续在计算机领域中深造,前往UCSD(加州大学圣迭戈分校)攻读博士学位。

△我不管这就是大佬本佬

最后,量子位也联系到陈胤伯本人,就个人和学术的一些话题进行了交流。他简单、直率,回答孜孜干脆,我们把问答实录同步如下。

One more thing:问答陈胤伯

量子位:为什么要选择研究元学习这一领域?

陈胤伯:感觉少样本学习这个问题比较有价值,元学习是少样本学习目前比较常见的方法。这篇文章并不是研究广泛意义上的元学习,主要还是对少样本学习的探讨。

量子位:其他研究者目前主要关注改进的点是哪个/些方面

陈胤伯:关注的点挺广的,我了解到的有提出新方法的 (比如meta-learning, self-supervised learning),也有尝试探索新的更符合实际的少样本学习setting的。

量子位:是怎么发现大部分人忽略基线方法缺陷的?

陈胤伯:做实验发现的。

量子位:目前很多科研人员选择在已有的方法上进行改良,然后发paper、毕业,对于这样的一个态度或者趋势,有何看法?为什么没有这么做?

陈胤伯:我觉得在已有方法上改良、发paper、毕业这三件事都挺好的(?),很多有价值的发现都是在改良中慢慢产生的。这篇paper主要侧重对现象的讨论,不过也有在经典方法上改良。

量子位:本科阶段就开始科研相关,你是怎么看论文、筛选论文的?如何处理与其他通识、基础课程学分的关系?

陈胤伯:看论文:google搜,沿着相关工作找。如何处理:好好学习。

量子位:现在在清华学习过程中,有什么不同?或者有没有一些经验分享?

陈胤伯:不同就是不搞竞赛了。没啥值得分享的经验。

量子位:姚班的培养机制,对你来说受益最大的是哪一方面?

陈胤伯:氛围很好,在与老师、同学的交流中能收获很多。

量子位:从这次科研过程中,有何心得体会?

陈胤伯:没啥特别的……

量子位:平时有怎么样的兴趣爱好?

陈胤伯:有一些大家都有的爱好。

量子位:看研究是和伯克利的老师合作,本科毕业之后,准备去伯克利读博吗?还是有其他打算?

陈胤伯:去UCSD读博。

嗯,大佬的回答,果然干练,且精辟。

最后,希望陈胤伯在接下来的学习道路上一帆风顺,不断带来新进展、新研究和新发现。

传送门

论文地址:

https://arxiv.org/abs/2003.04390

- 14.9万元,满血流畅运行DeepSeek一体机抱回家!清华90后初创出品2025-04-29

- 全球第一车企,集齐中美双版Waymo2025-04-30

- 全栈AI基础设施支撑,跑出全球首个开放使用视频生成DiT模型2025-04-28

- 亚马逊云计算Troy Cui:敦煌网飙升AppStore第二,企业如何应对激增流量是关键 | 中国AIGC产业峰会2025-04-27