百度x量子位 | 最强中文NLP预训练模型艾尼ERNIE官方揭秘

允中 发自 凹非寺

量子位 编辑 | 公众号 QbitAI

“最近刚好在用ERNIE写毕业论文”

“感觉还挺厉害的”

“为什么叫ERNIE啊,这名字有什么深意吗?”

“我想让艾尼帮我写作业”

看了上面热火的讨论,你一定很好奇“艾尼”、“ERNIE”到底是个啥?

自然语言处理( Natural Language Processing ,简称NLP )被誉为人工智能“皇冠上的明珠”。NLP是为各类企业及开发者提供的用于文本分析及挖掘的核心工具,已经广泛应用在电商、文化娱乐、金融、物流等行业客户的多项业务中。

而艾尼(ERNIE),可谓是目前NLP领域的最强中文预训练模型。

昨天,百度资深研发工程师龙老师,就通过直播带开发者走近最强中文NLP预训练模型ERNIE,在线上解读了一系列艾尼ERNIE的强大特性,并现场与同为NLP模型的BERT直接PK,让开发者连连感叹,希望能把ERNIE运用到自己的工作与生活之中。

错过了直播没关系,让我们来回顾一下课上都讲了啥~

什么是艾尼(ERINE)?

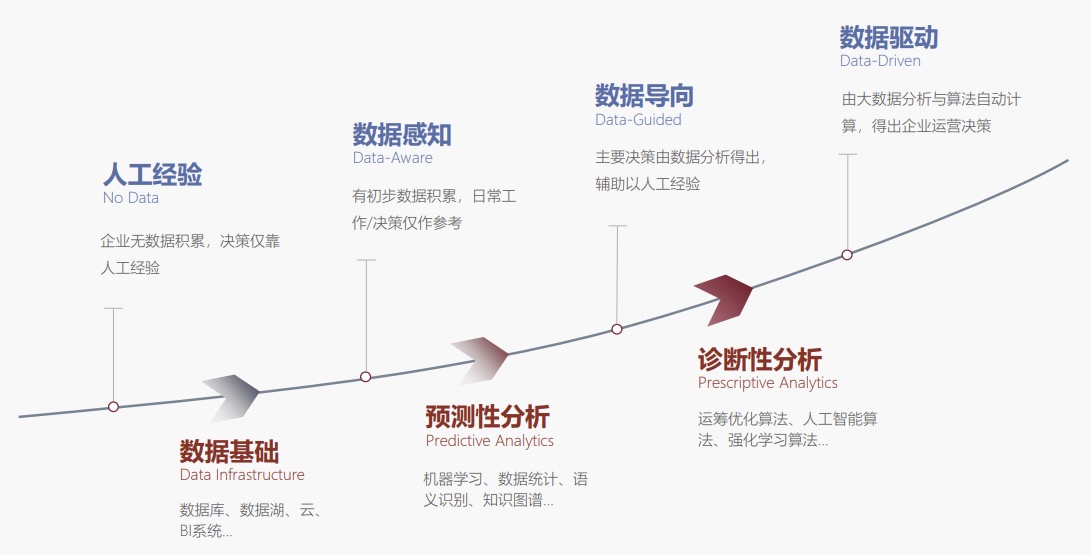

艾尼(ERNIE)是百度自研的持续学习语义理解框架,该框架支持增量引入词汇( lexical )、语法 ( syntactic ) 、语义( semantic )等3个层次的自定义预训练任务,能够全面捕捉训练语料中的词法、语法、语义等潜在信息。

这些任务通过多任务学习对模型进行训练更新,每当引入新任务时,该框架可在学习该任务的同时,不遗忘之前学到过的知识。这也意味着,该框架可以通过持续构建不同的预训练任务,持续提升模型效果。因此ERNIE具有了更好的语义理解能力。

△ERNIE 2.0持续学习语义理解框架

ERNIE好用么?

好不好用,摆事实才知道。

直播环节中,龙老师直接用填空题的形式展示了ERNIE与BERT在填空方面的表现。

例如题目:中国历史上唯一的正统女皇帝是[?][?][?],下面是直播中两种算法的表现:

ERNIE的结果是“武则天”,而BERT的结果是“宋太帝”。ERNIE能输出“武则天”说明它确实能学到“武则天”与“女皇帝”之间的关联。

而BERT输出的“宋太帝”虽然每个字“宋”、“太”、“帝”都与“皇帝”相关,但是连在一起就不是一个完整的词,而且也不能与“女皇帝”的形成照应。

再如,陈晓的妻子是[?][?][?]

ERNIE用答案向我们证明了自己不只懂百科,也懂八卦。

通过上面的DEMO测试,我们也就引出了这样一个问题:

ERNIE和BERT最大的区别是什么?

ERNIE1.0能够充分学习词语、短语、命名实体识别中字与字之间的关系,将其整体进行掩码。而BERT不具备这样的能力。ERNIE2.0则通过持续构造辅助任务让ERNIE进行学习,会的任务越多能力越强大。

这与BERT只靠一两个任务进行预训练的思路是完全不同的。就像小学生做题,一直只练一种题型肯定是不行的,需要多种题型都会做,既要有专项突破也要有综合练习,这样才能成为真正的学霸。

随着多样的训练数据的增加,ERNIE通过持续学习就能够学得越来越好。

ERNIE作为模型,也需要与深度学习框架的深度配合,才能实现最佳的效果。百度开源的深度学习框架飞桨(PaddlePaddle)对ERNIE模型有非常好的定制优化,使得其加速比达到77%,可以说是ERNIE背后的神助攻。

ERNIE借助飞桨 PaddlePaddle 多机分布式训练优势,利用 79亿 tokens 训练数据(约1/4的 XLNet 数据)和64张 V100(约1/8的 XLNet 硬件算力)训练的 ERNIE 2.0预训练模型不仅实现了在中英文16个任务上的最优效果,而且为开发人员定制自己的 NLP 模型提供了方案。

目前,百度开源了 ERNIE 2.0的 Fine-tuning 代码和英文预训练模型。

本次基于艾尼ERNIE的直播,同步在爱奇艺、IT大咖说、BiliBili、虎牙、斗鱼五个平台同步直播,收到了近3W开发者的关注与讨论。

直播回放视频已经上线,欢迎大家继续学习~

回顾ERNIE的原理、优势以及案例,请戳回放视频:http://play.itdks.com/watch/8591895

在9月,ERNIE的线下培训课程也会在北京、深圳、上海三地分别落地,敲重点,课程免费!

— 完 —

- 长城汽车自研芯片点亮!提前布局下一代架构RISC-V,魏建军:不能再受制于人2024-09-27

- 腾讯云发布自研大数据高性能计算引擎Meson,性能最高提升6倍2024-07-04

- Intel2024-03-18

- 数字员工全新发布 加速企业转型2024-01-15