加速产业AI化!浪潮提出“元脑”生态计划,要成就行业AI大脑

鱼羊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

AI浪潮,接下来如何改变世界?

走进AICC2019人工智能计算大会的现场,答案不难发现。

AICC大会由中国工程院信息与电子工程学部主办,浪潮集团承办,是AI计算的国内最权威的大会之一。

在这里,国内视觉、语音、自动驾驶等各个人工智能领域最优秀的公司齐聚一堂,各展拳脚。也有顺丰、招商银行这样传统产业公司展现AI智慧。

而AI正往何处去?正如中国工程院院士、浪潮集团首席科学家王恩东在大会上所说:

现在人工智能正在从AI产业化向各个产业AI化的方向发展。

并且作为基础设施提供方,浪潮也给出了应对之策。

不是推出产品,而想构建生态。

这个生态的名字叫”元脑生态“,它不独属于某一个企业,而将属于整个行业。

浪潮希望,通过推动元脑生态,聚合产业力量,以计算力+生态的方式,加速中国产业AI化进程。

浪潮集团AI&HPC总经理刘军这样提出:

在双重挑战下驱动升级是产业AI化时代下的共同课题。

应以生态之力,成就行业大脑。

所谓”双重挑战“,正是指产业AI化时代,不同行业的多元化需求显现,带来技术与商业的双重难题。

比如政策与安全考量下的公有云交付VS私有云交付。

比如AI技术快速变现的通用型开发需求与各行业精细化场景开发需求之间的差距。

赋能产业的元脑生态

刘军说,AI产业化会带来千亿规模的巨大市场,而产业AI化将是十倍于AI产业化的机会,是一个万亿级别的庞然大物。

这是这一波AI浪潮中必须抓住的巨大机遇。

所以元脑计划的核心宗旨是,高效聚合产业力量,促进产业AI化融合落地和创新发展。

要实现这个目标,不能光靠浪潮。

元脑在今年4月的浪潮数据中心合作伙伴大会上就已经登场,几个月以来,浪潮对产业AI化的理解又进一步深入。

浪潮AI&HPC副总经理赵帅说,他们意识到,元脑仅作为一个产品组合是不够的。

元脑不是浪潮的产品,是大家的产品,元脑也是AI的一个生态体系。

所以,元脑生态不独属于某一个企业,而是左手伙伴+右手伙伴+浪潮的三元素结合。

所谓左手伙伴,是具备AI功能开发核心能力的科技公司,比如阿里,科大讯飞等人工智能领先科技公司。

右手伙伴则是具有实施AI整体解决方案能力的SI(系统集成商)、ISV(独立软件开发商)。

浪潮则将在这个生态中共享领先的计算架构和服务,成为衔接各方的桥梁。

在此生态中,生态伙伴能以最高效的方式提取所需,最大化发挥所长,实现最先进的AI核心能力和最实际、最可操作的落地部署能力的强强联合,共同给行业最终用户交付符合AI时代所需的产品、能力及解决方案。

也就是说,元脑生态将成为一片肥沃的土壤,成就各个行业中能把握住机遇的有准备的人,催化行业大佬的诞生。

生态背后的硬实力

正如肥沃的土地中包含丰富的营养物质。

元脑生态中,浪潮将共享三大核心平台能力,囊括计算、资源、算法三大方面。

计算,是高效创新的AI计算平台。

作为一家在过去两年当中,在中国AI服务器市场份额都超过50%以上的公司,浪潮在硬件方面有着深厚的积累。

面对于AI创新效率而言至关重要的算力问题,浪潮不仅针对不同场景下不同的应用负载需求,推出了一系列AI加速芯片和加速卡,比如业界最高浮点计算能力的F10A,内置了高速缓存的可重构超低延迟AI加速卡F37X。

还建立了非常全面的人工智能服务器阵列。

面向训练,有全球市场上最畅销的超级AI服务器AGX-2,2U空间内能集成8颗GPU,能提供极致的计算密度,实现强劲的性能。

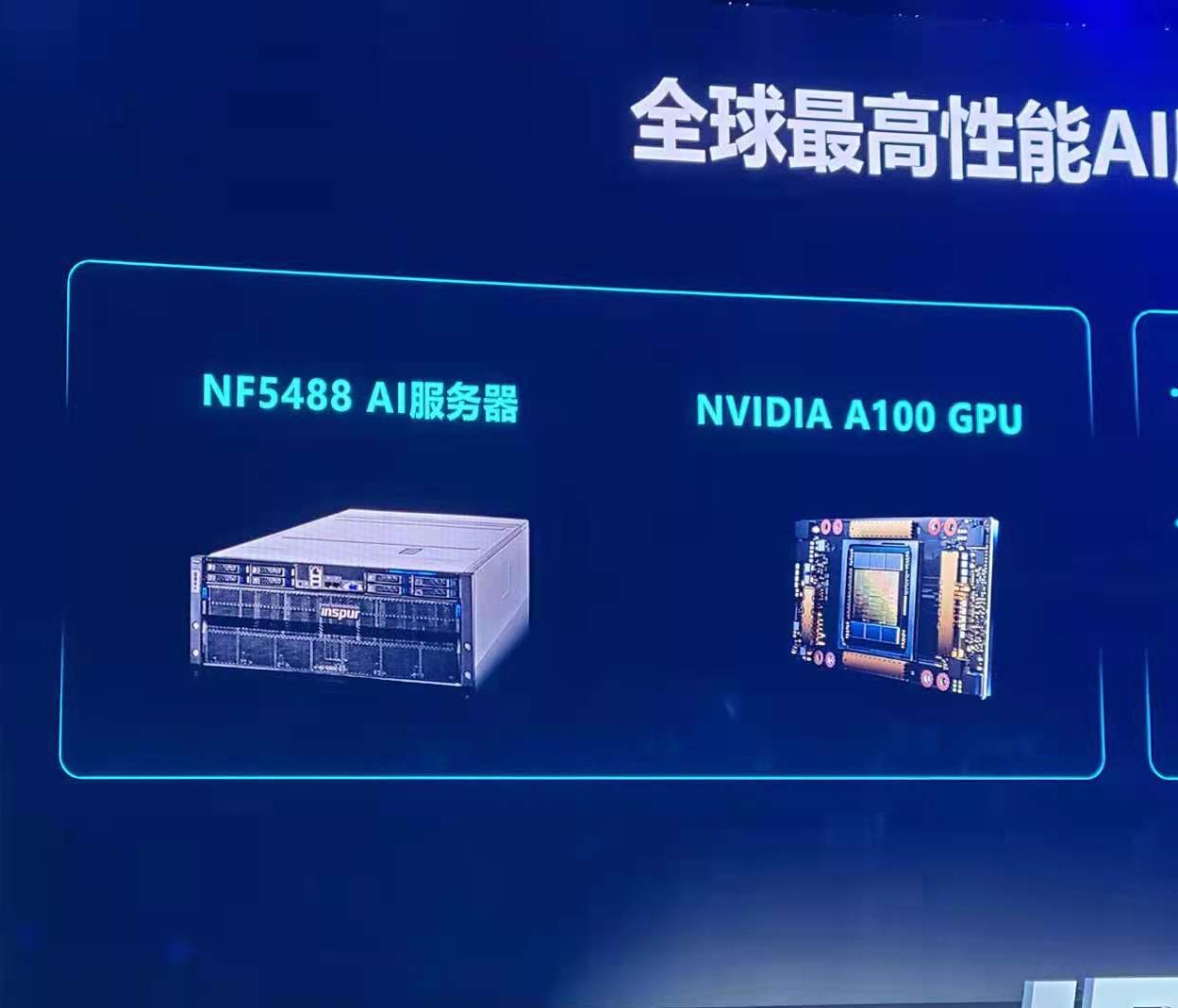

NF5488M5,业界首款支持NVSwitch高速互联的4U8GPU AI服务器,实现了8颗V100之间的全互通无阻塞通信,6通道的Switch架构,P2P带宽可以达到300GB每秒。

AGX-5,全球最强大的AI计算主机,单机计算性能达到每秒2千万亿次。

面向推理,有NF5468M5这样的弹性AI云服务器,可以在4U空间能集成20块推理加速卡,既支持英伟达的P4/T4,也支持寒武纪的ML100、ML270和众多FPGA加速卡。

边缘计算端,也有5250M5这样支持壁挂式和机架式安装,对于部署环境可以因陋就简的AI服务器,适用于自动驾驶、智慧城市这样的落地场景。

这样的计算平台,实力不可谓不强大。

以NLP应用场景为例,NF5488M5就是目前性能最好的Transformer训练服务器。在与同类型产品的性能比较中,基于NF5488M5服务器加速的Transformer,在GLUE基准上训练至80.4%,训练时间能减少67%。

不止如此,通过参与OCP开源社区的方式,浪潮正在与世界领先的AI芯片公司携手,推动AI加速器模块的标准化,实现AI计算芯片轻松的更换升级。

在这其中,浪潮贡献了基于OAM的通用基板设计,以此连接AI芯片和超大AI数据中心的需求。

第二个平台,是AI资源平台。

更敏捷高效的资源管理,以及更高的开发效率,对AI协作开发而言至关重要。毕竟,AI计算资源是非常昂贵的。

浪潮开发的AIStation,就能提升整个计算资源的利用率。显存调度利用率提升50%,GPU使用时间提升1.3倍,亲和调度提升20%。

浪潮方面表示,AIStation能支撑从模型开发,到模型部署,再到应用开发的全流程;支持统一的帐户系统,AI计算资源管理,训练数据系统,镜像系统和AI模型库。

最后是AI算法平台。

多样化又便捷高效易部署的算法工具能帮助实现AI方案的快速交付。随着产业AI化时代的到来,不同行业、不同落地场景对网络模型的要求越来越精细化,这使得快速建立机器学习模型成为一个难点。

浪潮的解决方案是,基于自动机器学习的AutoML Suite。

谷歌的AutoML早就名声在外,但问题是,想使用谷歌的AutoML,就必须在谷歌的公有云上进行部署。

这对于那些对安全性保密性要求较高的行业来说,是不能接受的。

AutoML Suite解决了这个痛点。它可以实现一站式本地化学习,同时还支持多节点和多GPU扩展,不仅能帮助产业客户实现自动机器学习,还非常高效。

比如在铁道巡检上的应用。铁道巡检是一个非常复杂的场景,在一条铁道上有上千种不同的零件,对不同的零件进行故障率检测,对于模型算法的建立来说是一个巨大的挑战。

这时,AutoML Suite就派上用场了。实测的结果显示,即使在样本比较少的时候,用AutoML Suite建立的模型和人工专家建立的模型,质量能保持在统一的水平线上。

此外,浪潮还开源了智能化引擎TF2。TF2基于FPGA,在全球范围内首先采用DNN位移计算技术加速FPGA应用部署。

它可以压缩PyTorch、TensorFlow、Caffe等主流架构训练出来的网络模型,再对其进行编译,自动生成运行文件,有效提升跨端部署的生产效率。

开源地址:https://github.com/TF2-Engine/TF2

不仅是在算法工具上,在计算系统性能的评测标准上,浪潮也在推动工业界AI的Benchmark。

为此,浪潮牵头建立了SPEC组织下的深度机器学习委员会SPEC-ML,专注于工业标准的AI计算性能和效率评估。

构建生态,真不是说说而已,在其背后,是有过硬的技术为支撑。

One More Thing

在AICC2019上,刘军宣布,浪潮将与百度共建AIStation和飞桨(Paddlepaddle)联合方案,与VMware共建AIStation和vSphere AI私有云方案。

生态建设,行动比语言来得更快。

— 完 —

- 粉笔CTO:大模型打破教育「不可能三角」,因材施教真正成为可能|中国AIGC产业峰会2025-04-18

- GPT-4.1淘汰了4.5!全系列百万上下文,主打一个性价比2025-04-15

- SOTA自动绑骨开源框架来了!3D版DeepSeek开源月大礼包持续开箱ing2025-04-11

- 语音界Deepseek!百度最新跨模态端到端语音交互,成本最高降90%2025-04-02